编者按:当我们都在关注人工智能对生活带来的积极影响时,另一种担忧的声音正在产生:自主智能系统在许多社会机构早已司空见惯,但我们却无法找到真正能评估其持续性影响的方法。本文提出了目前业界解决AI系统的社会和伦理学影响的三种方法,并提出了从社会系统分析入手的第四种方法,指出要关注人工智能在社会层面的意义。文章首发于Nature,作者Kate Crawford和Ryan Calo,老吕及何忞编译,未经许可不得转载。

芝加哥警察利用算法推测涉及枪案的嫌疑人,

但事实证明这种方法效果不明显

Sanchez/Chicago Tribune/TNS/Getty

白宫于本周发布了一份报告,阐述了它们对未来人工智能(AI)的看法。这份报告由来自西雅图、匹兹堡、华盛顿和纽约的四个研究小组耗费三个月时间撰写而成。

在这份报告中,许多来自不同领域的世界顶尖思想家讨论了AI如何改变我们的生活方式,其中包含大量的例子,生动地解释了机器学习和其他AI技术在解决生活中复杂问题方面的巨大作用,涉及从皮肤的变化预测癌症,到减少数据中心的能源消耗等多个方面。

此外,报告还强调了眼下我们在 AI 研究上存在的主要盲点:自主智能系统在许多社会机构早已司空见惯,但我们却无法找到真正能评估其持续性影响的方法。

最近几年,人类在人工智能领域取得了巨大的进步。相应的,来自多个学科的设计师和研究人员需要对 AI进行系统性的分析,他们必须评估出技术对社会、文化以及政治环境的影响。

举例来说,我们需要研究出 AiCure 应用是如何改变医患关系的,这款应用可以追踪病人是否坚持吃药并将数据传给医师。同时,此类技术的使用还能通过对历史数据的分析来预测犯罪高发地带,减少警方对边缘社区的警力滥用。此外,我们还需找出为何出手阔绰的投资者与低收入的借贷者总是会被区别对待。

老生长谈的“奇点降临”

“人们总是担心电脑变聪明后会接管世界,但现实问题是它们在相当愚蠢时已然统治了全世界。”这是计算机科学家 Pedro Domingos 在其2015年的著作《The Master Algorithm》中给出的经典论述。许多研发人员也认为 AI 的发展正处于初级阶段,技术奇点还未到来,他们正推动 AI 系统(相对未经测试的)进入各个社会机构。

正是由于 AI 研发人员的不断努力,此类系统才成了医师们指导诊断的利器。此外,法律机构也利用 AI 给客户提建议,帮助他们打赢官司。金融机构则可利用 AI 找出贷款放给谁最安全,而雇主则能通过 AI 在应聘者中找出综合实力最强的人。

分析师认为未来 AI 系统的适用范围将得到大幅扩展,其经济价值更是高达数十亿美元。而 IBM CEO 更是看好该技术的发展,她认为未来十年 AI 系统中蕴含着价值2万亿美元的新机遇。当然,这一切都只是初步预测,毕竟我们对如何衡量 AI 的价值还没有形成共识。

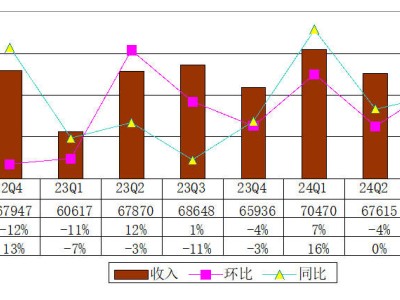

CB Insights 的研究显示,AI领域的投资呈逐年上升趋势

CB Insights

许多人认为,AI 在做预测和指导性决策时没有人类明智,但工程师却认为 AI 能找出人类在决策时存在的偏见和傲慢。不过,它也不是万能良药。至少在当下,AI 的缺点依然会让它在种族、性别和社会经济背景方面犯错,而这些因素本就是人类做决策时的软肋。

2013年的一项研究显示,在谷歌搜索典型的黑人名字,搜索结果中出现犯罪记录搜索的可能性比白人名字高25%。在另一例与种族有关的案例中,非营利机构 ProPublica 发现,法庭普遍使用的算法也存在种族歧视,在它眼中,黑人罪犯再次入狱的几率是白人的两倍。

三种工具

如何避免这种影响呢?目前,解决 AI 系统的社会和伦理学影响的有三种主流模式:服从模式、价值观设计、思维实验。这三者都很有意义,但是不论是单独为人们所用,或是三者齐头并进,都不能有效解决这个问题。

部署和执行方法(deploy and comply)

通常情况下,企业或者其他组织采取基本的步骤,坚持一系列行业最佳实践或是法律义务,来躲避政府或媒体的监督。这种方法可以得到短期利益。比如说,2015年谷歌系统错误地将一对美籍非裔夫妻识别为大猩猩后,及时调整了他的图像识别算法。公司还提出了想法,将一种“红色按钮”引入其 AI 系统中,当工程师发现系统不对劲时,可以按下按钮防止失控。

同样地,Facebook 因为将这张越南小女孩 Kim Phúc 逃离燃烧弹袭击的照片认定为裸体儿童照片并予以屏蔽,遭到了公众的强烈谴责。而就在上个月,包括微软、亚马逊和 IBM 在内的几家领先的 AI 公司,达成合作伙伴关系,意图提升公众的理解,并以此设立一些公共的标准。

“部署和执行”方法尽管可以是活跃的点对点模式,但如果他们缺少充足的批判声音和独立的观点贡献者,那么该行业的努力仍旧存在进步空间。新的 AI 合作伙伴关系正在邀请伦理学家好社会组织者们的参与。但是人们的关注点依然在于,企业是否可以相对自由地在公众中测试他们的 AI 系统,而无需持续地研究短期或中期的影响。

价值观设计方法(Values in design)

多亏了技术中伦理道德方面设计的先驱们,包括极有影响力的学者 Batya Friedman 和 Helen Nissenbaum 的贡献,现在的研究者和企业都执行了诸如价值敏感设计或“有责任的创新”的方法来定义可能涉及的利益相关者,并对他们的价值观进行界定。焦点小组或其他研究手段被用来建立人们关于个人隐私、环境问题等等的观点。无论设计的是 App 还是无人车,这些未来用户的价值观都应渗透进技术的设计中。AI 系统的开发者们应该对这些方法加以重视。

不过,这些工具常常有一个前提假设:这个系统一定会被设计出来。他们无法帮设计者、政策制定者或者整个社会回答,某个系统是否应该被设计出来?某个基础设施的系统原型是否太过于初级、不够可靠而无法作为基础设施(比如医院系统或法庭系统)?

哮喘患者被一个预测肺炎的 AI 系统错误地评为低风险等级

Craig F. Walker/Denver Post/Getty

思维实验方法(Thought experiments)

过去的几年中,各种假设情境涌现,成为了公众讨论 AI 社会影响的争论热点。

最热门的讨论是关于人类设计出的高级智能系统最终统治或毁灭了人类自己的可能性。另外,还有一个从1967 年就开始的相关思维实验——电车难题也获得了新生,这个场景提出了关于责任和罪行的问题。在该问题中,一个人既可以让一列正在行驶的电车碾压过五个正在工作的人,也可以是电车变道冲向另一条只有一个人的路。很多评论家把这个假设的场景放在自动驾驶汽车中考虑,他们认为汽车应该自动做出包含有道德要求的选择。

与机器人末日相比,无人车发生“谋杀选择”的可能性提供了一种更为狭窄的道德推理框架。电车问题为我们解决更广泛的社会问题提供了一些方便的指导:比如大量对自动汽车而非对公共交通的投资的价值问题;在无人车被允许上路前,安全性能应该有多高;(我们应该用什么工具来定义安全性?)、无人车在交通拥堵、环境和就业问题上的潜在影响有哪些等问题。

社会系统分析方法(Social-systems analysis)

我们相信诚然还需要第四种方法。一种实践的、可以广泛应用的社会系统分析法,它可以考虑到 AI 系统对所有方面的可能影响,并且能同时包括在每一个阶段中的社会影响,包括概念阶段、设计阶段、部署阶段和调控阶段。

在第一阶段,政府部门和行业等大范围的研究者们需要开始调查大众的信息、财富和基本服务的获取渠道与 AI 系统的训练数据之间有什么区别,如何匹配。

用芝加哥、伊利诺斯的“热度地图”(heat maps)识别那些人更容易卷入枪击事件的算法为例,上个月发表的一份研究表明,这种地图是无效的,他们扩大了特定人群的可能性,吸引了更多警力,但是却没有减少当地的犯罪率。

社会系统方法可以在“热度地图”中考虑到当地社会和警局的历史数据。这可能要求对社区成员的问询和对警察针对社区治安积极或消极反馈的权衡。这也可能意味着要将监督委员会和法律机构的发现考虑进去。这种社会系统分析法还会要求系统的风险和报酬要保持平衡。所以在这个案例中,警方使用相似的技术来识别官员们谁可能有不正当行为(比如暴力)。

在另一个例子中,2015 年的一份研究表明,应用于预测医院的哪个病人会得肺炎的机器学习技术在很多情形中都运行良好。但是它却犯了一个严重的错误:尽管一些哮喘病人情况危急,它仍然指导医生将这些病人送回了家。因为通常医院会自动将哮喘病人送去重症监护病房,所以在系统被训练的数据记录中,这些病人很少出现在“需要后续护理”的分类里。使用社会系统分析法,我们就需要将医院治疗、保险政策等隐形因素考虑其中,适当地调整患者的病例记录。

社会系统分析法可以让系统回答一些提问:比如自身是如何运转的?金融咨询者们曾经在应用机器学习时受到限制,因为他们的客户总是希望他们回答为何做出某个决定。但是到目前为止,已经受到 AI 算法限制的个体,还不可以像人类一样回答为什么的问题。

社会系统分析法在各种学科中,需要重点关注心理、法律、社会学、人类学和科学技术领域的研究。 该方法必须开始研究社会的、政治的和文化上的价值观是如何与技术发展和科学研究相互影响的。与单纯只包含计算机科学和犯罪学的思考相比,我们只有在对 AI 影响社会层面提出更加广泛的问题,才能够对人工智能的影响产生出更加完整而和谐的理解。

未来还是有希望的。像下一个月在纽约举行的研讨会“机器学习的公平性、责任感和透明度”研讨会就是一个很好的例子。但是赞助者们——包括政府、基金和企业,都应该为我们描述的 AI 发展方法付出更多的努力才行。

人工智能代表了一种技术层面上的文化转变。这跟历史上的很多技术对文化的重大影响转折点很像,比如印刷术的使用、火车的开通,等等。自动化的系统正在改变工作室、街道和学校。我们需要保证,在技术逐渐渗透进我们日常生活的基础设施之前,这些改变是对我们有益的。