编者按:以云计算为代表的信息化手段对于当下疫情的防控工作有着卓然的成效,无论是远程视讯、病毒分析、疫情风控分析、视频监控、前端如体温和人脸采集分析等都离不开后端数据中心的支持。这势必牵扯到海量的数据处理能力,而这海量的数据处理能力则依托的是服务器集群所提供的计算能力。

没有技术能够一劳永逸地解决所有问题,当年的主机如是,现今的PC Server如是,代表未来的云计算更如是。于是,我们也只能边用边改、边总结边探索。

虽然我们已经推开了数字时代的门扉,看到了数字技术给商业和社会带来的巨大改变。但在数字基础架构层面,问题还远远没有结束。甚至可以说,即使最先进的超大规模数据中心也同样有着自己的近忧和远虑。

近忧是数据中心的建设和运维成本;而远虑则是全新计算类型不断出现所带来的架构性挑战。

成本——数据中心永远在翻越的山峰

即便将数据中心选址在地价、电价相对便宜的地区,数据中心仍是IT建设中最显而易见的重资产项目,其建设与运营都需要巨量的资本。由于需要大量土建工程和基础设备的支持,数据中心内每一平米能够留给IT设备的面积都需要五位数乃至六位数的价格。

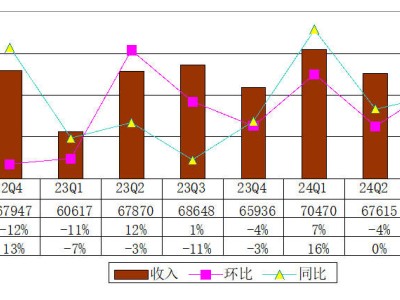

面对堪比北上广房价的数据中心建设费用,计算的密度就成为了任何数据中心建设者都会关心的核心设备指标。而在对于计算密度的极致追求之下,Olympus、Open19、ODCC天蝎项目、OpenRack等定制服务器项目的不断出现也就不足为奇了。

当然,除了在设备结构上精雕细琢,对于绝大多数数据中心而言,提升计算密度和效率还有另外一条更直接的道路可选——拥有更多核心、更高性能的计算平台。

AMD第二代EPYC平台:巅峰性能且更具性价比

继2017年推出代号为“那不勒斯”的第一代EPYC处理器后,AMD于2019年发布了代号为“罗马”的第二代EPYC处理器。

代号为“罗马”的AMD第二代EPYC系列处理器

作为业界首款基于7nm工艺的处理器,第二代EPYC处理器最高内置64核128线程,256M三级缓存,八通道DDR4-3200内存(单路4TB)、128条PCIe 4.0等一系列新特性。根据AMD公布的数据,其双倍核心数量加上针对提升周期指令数进行的优化,其浮点性能相较上一代产品提升约4倍。同时,引入7nm制程工艺带来了更高能效;这也意味着第二代EPYC的能效比是上一代产品的2倍。第二代EPYC处理器在多种业内性能基准测试中领先,迄今为止保持超过了 140项世界纪录。

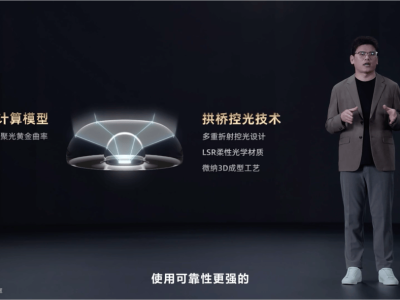

得益于Chiplets设计,第二代EPYC平台在较短的时间内完成了产品的迭代升级。相比较单片SoC的方式,采用Chiplets设计更具灵活性,因为在许多场景下如果将功能都集成在一颗die上,其性能、功耗、面积通常难以做到最优。而采用Chiplets还可以缩短产品的开发周期,并从一定程度上降低设计风险。AMD将其称为“AMD Infinity”混合多芯片架构,这种架构在第二代EPYC处理器中的应用达到了新的高度。

在第二代EPYC平台上,AMD采用了最新的7nm工艺设计了Core Chiplet Die(简称CCD)部分,而每个CCD部分均包含两个CPU Complex(简称CCX),每个CCX整合了四个core。而在内存、PCI-e以及磁盘控制器等I/O处理的部分,则采用了14nm的工艺来降低成本与开发周期。每个I/O核心最多可与8个CCD核心相连,即最高64核的设计。

在2月份举行的SSCC2020大会上,AMD方面谈到了采用7nm+14nm工艺对比单纯7nm工艺设计有效降低了成本:如果将64核产品作为基准比较,在48核、32核、24核、16核产品上有着最高约两倍的节省,其中核心数量越大,所节约的成本越多。

而采用台积电7nm工艺封装的核心部分不仅大幅提升了能效比,相比第一代EPYC还有效降低了CCD的面积,这使得在第二代EPYC平台中的CCD部分可以塞入更多的内核。同时,改进了的分支预测器,优化过的 L1 指令缓存,两倍的浮点单元数据宽度,指令存储队列,两倍的 L1 数据缓存读写带宽。单个CCX两倍的 L3 缓存等多种改动使得 Zen 2 相对于 Zen1 有超过 15% 的 IPC 提升。最终使得Zen 2相较Zen 1有了约两倍的能效比提升。值得一提的是,由于采用这种非一体化的芯片设计有效地缩短了产品设计周期,AMD还将推出代号“米兰”的第三代EPYC,采用台积电7nm+工艺有望进一步提高能效比。

目前,AMD EPYC平台已经得到了包括腾讯云、亚马逊、微软、甲骨文、谷歌等大型云服务提供商的青睐;此外,包括戴尔、HPE、H3C、联想等顶级OEM合作伙伴也与AMD合作推出了丰富的基于第二代EPYC平台的服务器产品。

从另一层面来看,在EPYC平台从第一代到第二代的升级过程中,AMD并没有更换处理器插座。这意味着,用户可以通过升级固件并安装新CPU的形式在不更换服务器整机的前提下就获得更多核心及更多性能。显然,这对于一些用户来说是十分具有吸引力的。

回看文章最初的问题,构建数据中心通常需要一个相对复杂的流程,实际情况根本没有那么多推倒重来的可能。而在不改变原有风火水电等配套设施的前提下,如何在持续提高计算性能的同时保证出色的能效比则是企业数据中心长期的追求。而纵观AMD EPYC平台的设计思路,则可以很大程度上对客户的原有投资进行保护,满足大多数用户分批次升级的产品生命周期规划。

Chiplets助力摩尔定律 开创更多可能

面对越来越丰富的计算类型,服务器也出现了计算场景化的趋势。通过安装GPU、FPGA、AISC等不同类型的计算核心,服务器往往能够获得在特定应用场景中更好的计算效率。但与此同时,通过不断增加计算卡的方式来实现算力多元化,也会对服务器的功耗、散热、物理空间占用等方面提出更高要求。

面对这样的矛盾, 由AMD在数据中心计算平台中首先实践的Chiplets则给出了令人期待的解决路径。未来,通过将不同的晶片集成在同一基板之上,AMD及其合作伙伴则可以在Socket的方寸之间就解决算力多元化的大挑战。而由于CPU在服务器内往往有着最好的供电和散热资源,通过计算卡形式进行算力多元化所带来的多种问题也将因此迎刃而解。

换句话说,在已有的基板之上,AMD可以较为方便的对晶片数量进行增减。这就让AMD可以用更低的成本和售价来推出面向中端或入门纯处理器产品。当然,在去掉一些CCD之后,空余的IO带宽和总线还可以用来与同样集成在基板上的其他类型晶片相接驳,从而打造面向特定应用的“异构”处理器。

顺着这一思路想象,我们可以期待的未来将更加丰富多彩。例如,我们可以将CPU上的其中一个或多个CCD替换为GPU并增加相应的HBM,从而获得更好的ML/DL及推理应用性能(而这种方式也很有可能是解决多GPU之间数据交换与同步的新方法);再比如,我们也可以将这些CCD替换为更有针对性的ASIC来增强CPU在其他特定算法中的性能表现,进而打造出更具场景化的计算平台方案。

相对于以往的芯片整体设计思路,这种利用Chiplets技术打造异构芯片的方法不仅能够让现有IP继续发挥价值,更可以大幅降低新处理器或计算平台的研发周期和成本,让更多计算场景能够以更低成本获得大幅度的性能优化和基础设施架构简化。

而从更宏观的层面来看,Chiplets技术也很可能是延续摩尔定律的有效催化剂。

决战方寸之间

作为服务器乃至整个数字基础架构的核心,处理器是一门相当复杂的艺术。说它是艺术不仅因为它需要在设计、制程与工程之间不断探索新的平衡,更因为一款处理器要应对来自当下和未来的双重挑战。

而一款优秀的处理器所代表的计算平台则要做到在为用户提供可见的性能提升的同时,为用户乃至行业的未来提供新的发展方向、新的发展思路。

从这两方面来看,第二代EPYC处理器都具备独特的意义。64核与7nm的组合为用户带来了肉眼可见的计算性能和密度提升,能够帮助数据中心站上成本与性能的新高度。而Chiplets技术的应用则为制程进步趋缓背景下摩尔定律的继续生效提供了全新路径。

能够在几百平方毫米的方寸之间将对技术和未来洞察演绎至此,几年以来,这样的产品的确罕见。

在这里我并不想着墨过多溢美之词;并不是因为这款产品不值得,而是因为很快我们还会有全新的Milan可以期待。届时在做品读亦为时不晚。