AI换脸的兴起意味着图像技术日趋成熟,同时也面临 “AI 黑产”带来的系列问题。近日,百度在权威DeepFake防伪数据集FaceForensics Benchmark上刷新纪录,以整体检测准确率0.821的成绩超越SOTA,领跑行业。

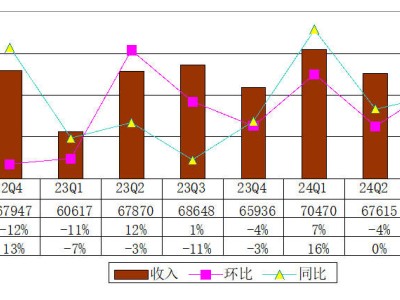

faceforensic-benchmark榜单结果

FaceForensics Benchmark是德国慕尼黑工业大学(TUM)联合Google等多家机构共同发布的大规模人脸伪造数据集,用于促进对人脸伪造检测的学术研究,并提升工业界对于人脸防伪业务落地的重视程度。FaceForensics Benchmark数据集拥有四种业界先进的人脸伪造技术,分别是Face2Face、FaceSwap、DeepFakes和NeuralTextures。这些伪造出来的人脸图像自然逼真,人眼几乎无法辨别真伪,极大地提高了任务难度。

基于此,百度将自研的Learning Generalized Spoof Cue算法(论文参考:https://arxiv.org/pdf/2005.03922.pdf)引入人脸合成图像鉴别任务,整体检测准确率进一步提高,并登顶FaceForensics Benchmark榜单。

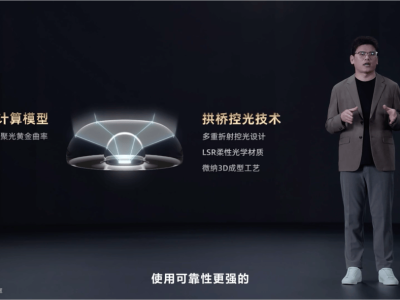

LGSC网络结构图

据悉,LGSC方法最早用于解决人脸活体的鉴别问题,在解决活体问题时引入异常检测的思想,假设活体为具有相同特征的闭集,活体攻击为闭集以外的离群样本,以解决攻击方式的多样性对于活体判别效果的影响,其对攻击图像与活体图像之间的可区分攻击线索(Spoof Cue)进行建模,将活体的攻击线索定义为与输入图像尺度相同的all-zero map,将活体攻击的攻击线索定义为none-zero map,设计了一种攻击线索生成器进行攻击线索生成并引入辅助分类器进行联合训练。

在模型训练过程中,LGSC方法只对活体进行显式的L1 Regression Loss监督,对非活体不进行任何回归监督,通过隐式的多级triplet Loss将活体样本在特征空间中进行拉近,将攻击样本推离活体区域,通过与原始图像的残差连接和辅助分类器进一步提升攻击线索的可区分性和泛化性。值得注意的是,LGSC方法通过联合监督的方式学习得到了兼具可区分性和泛化性的攻击线索,在预测时其并不使用分类器输出进行结果判别,而是直接使用攻击线索图的量化数值用于评估一张图片是否为攻击图像,该方法已在多个活体数据集中的多项protocol上均取得State Of The Art结果。

随着DeepFake、FaceSwap等人脸编辑及生成技术的发展,极大的推动了如虚拟主播、人脸合成等新兴娱乐文化的应用,但同时也给人脸安全带来了潜在威胁。例如通过 “换脸”技术进行色情视频生成、虚拟政治人物讲话等,对社会造成严重不良影响。有调查显示,目前的AI换脸俨然已经形成了一个黑产产业链,上游提供软件及技术、中游提供视频、照片定制、下游售卖成品视频,也有商家做全产业链的生意,已造成严重危害。

此外,在一些使用人脸注册识别场景下,可能会存在不法分子通过上传AI合成人脸图像企图蒙混过关。一系列“换脸”技术合成的人脸图像很难通过肉眼辨别真伪,加上人脸数据涉及到用户的肖像和个人隐私,篡改人脸数据也将对用户个人信息安全造成威胁。

“换脸”引发的问题,已在业界引起广泛关注。百度LGSC方法在学术研究的同时已完成落地,百度大脑已基于该算法在人脸识别的活体模块中首发对人脸合成图鉴别能力,并在“人脸检测”、“H5视频活体检测”、“在线活体检测” API中上线。在多种活体技术加持的基础上,新增功能可以准确鉴别AI换脸技术和黑客工具生成的人脸图像,安全等级实现进阶。此外,该项新功能在人脸审核、新闻鉴真、肖像维权、色情图像审核等诸多方面均有很高的实用价值,不仅保护着广大个人用户的信息、权益,还协助企业提升了其服务安全性。

目前,百度已开放线上合成图检测接口,后续将持续优化针对不同落地场景的差异化能力,保障人脸相关应用的安全,以技术美化生活,更以技术守护生活。