据HOTHAREDWARE报道,英伟达官方发布了基于Ampere架构的A100已经被认为是高性能计算集群(HPC)的首选GPU,但为了巩固自身在行业之中的位置,特别是竞争对手AMD发布了基于新一代CDNA架构的Instinct MI100加速卡,英伟达推出了搭载80GB HBM2e大容量显存版的A100。

根据NVIDIA的介绍,A100 80GB版可提供2TB/s的带宽,高于40GB HBM版的1.6TB/s。英伟达将其称为全球最快的数据中心GPU,认为其非常适合各种对数据有巨大需求的应用,比如天气预报和量子化学等。

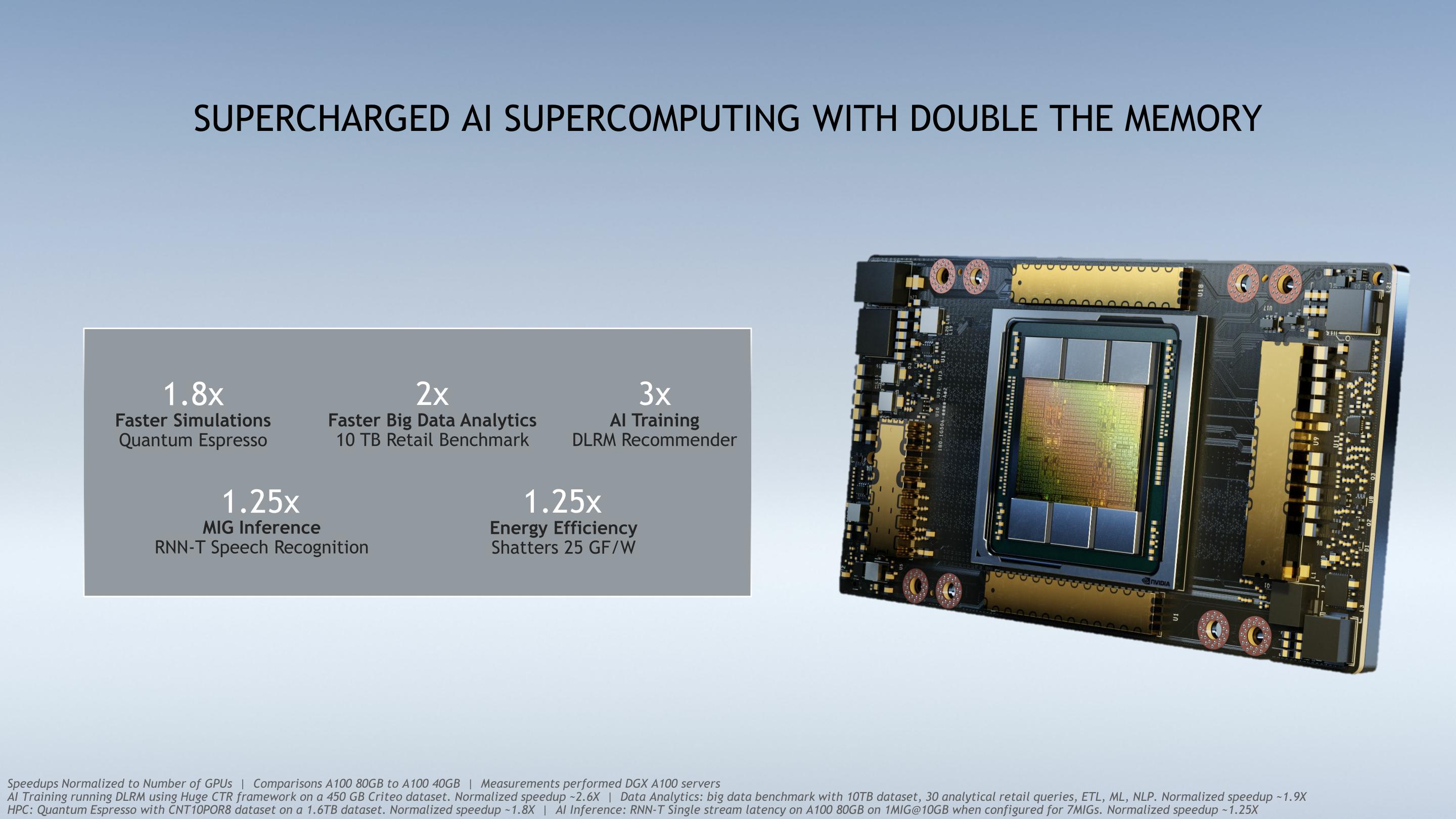

这一次升级,除了将显存增大了一倍,也拥有更快的速度。被称为HBM2e的HBM2改进型,频率为3.2Gbps,而A100 40GB版的频率为2.4Gbps,这就是显存带宽增加的原因。其他规格基本保持不变,包括19.5 TFLOPS的单精度性能和9.7 TFLOPS的双精度性能。

"在HPC和AI研究中取得最先进的成果需要建立最大规模的数据模型,但这些模型对内存容量和带宽的要求比以往任何时候都高",英伟达深度学习研究副总裁Bryan Catanzaro,"A100 80GB GPU提供的显存是半年前刚刚推出的前代产品的两倍,并突破了每秒2TB的障碍,使研究人员能够应对世界上最重要的科学和大数据挑战"。

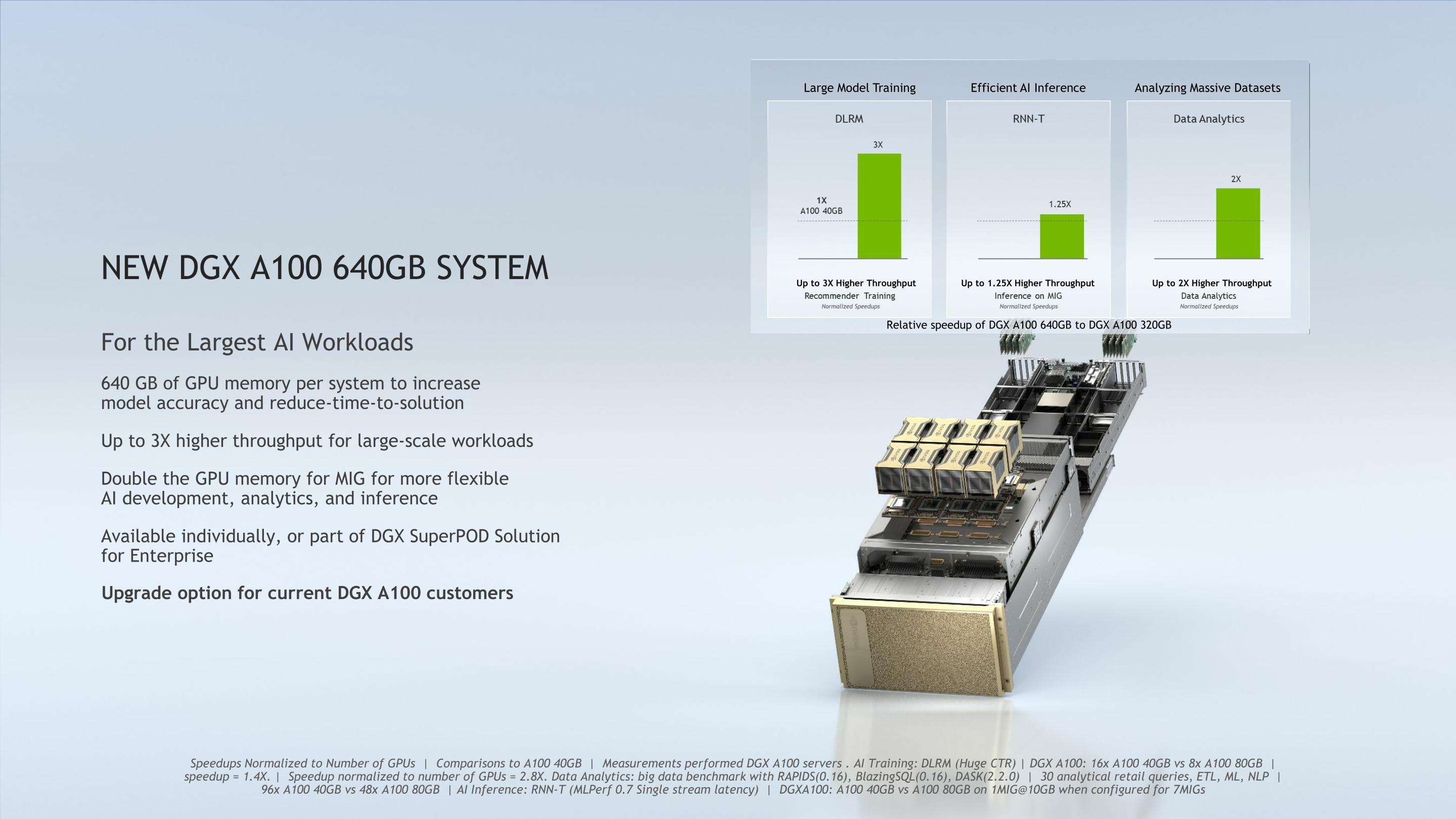

英伟达提供了一些基准测试的数据,最大的提升是以DLRM Recommender为代表的AI深度学习,提升了3倍,其次是大数据分析,提升了2倍。这些方面提升效果是明显的,对于需要进一步挖掘性能的客户来说,这是一次可喜的升级。

升级后的80GB HBM2e版已经出现在NVIDIA新款DGX Station A100里面,它基本上是一个小型数据中心了,装载了4块A100 80GB 版加速卡可以提供2.5 PetaFLOPS的性能。

DGX Station A100将在本季度上市。