2 月 18 日报道,本届集成电路设计领域顶会 “国际固态电路会议(ISSCC 2021)”正在进行中(2021 年 2 月 13 日到 22 日)。作为已有近 70 年历史的集成电路产学届盛会,ISSCC 2021 亦被许多厂商视为发布其领先芯片技术的权威舞台。

本届会议上,IBM 发表了据称是 “全球首款”的高能效 AI 芯片,该芯片采用 7nm 制程工艺,可达到 80% 以上的训练利用率和 60% 以上的推理利用率,而通常情况下,GPU 的利用率在 30% 以下。

性能参数方面,IBM 新品的运算密度高于同样采用 7nm 工艺的 NVIDIA A100 GPU;其在多种精度下的整数运算性能,还优于联发科 7nm 专用 AI 芯片等产品。

据 IBM 官网分享,其新款 7nm 高能效 AI 芯片该款芯片在多种场景中均有较好的应用前景,比如,可用于混合云环境中的低能耗 AI 训练、或用于实现更接近边缘的云端训练等。

一、IBM 新款高能效 AI 芯片:能效比高过 NVIDIA A100

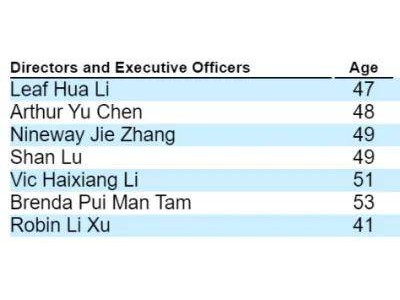

对比结果显示,IBM 新款 7nm 高能效 AI 芯片的性能和能效,不同程度地超越了 IBM 此前推出的 14nm 芯片、韩国科学院(KAIST)推出的 65nm 芯片、阿里巴巴旗下芯片公司平头哥推出的 12nm 芯片含光 800、NVIDIA 推出的 7nm 芯片 A100、联发科推出的 7nm 芯片。

IBM 新款 7nm 高能效 AI 芯片支持 fp8、fp16、fp32、int4、int2 混合精度。

在 fp32 和 fp8 精度下,IBM 新款高能效 AI 芯片的每秒浮点运算次数,分别达到 16TFLOPS 和 25.6TFLOPS;运算密度分别为 0.82TFLOPS/mm^2 和 1.31TFLOPS/mm^2;能效比分别为 3.5TFLOPS/W 和 1.9TFLOPS。

在 int2 和 int4 精度下,IBM 新款高能效 AI 芯片的运算密度分别为 3.27TOPS/mm^2 和 5.22TOPS/mm^2;能效比分别为 16.5TOPS/W 和 8.9TOPS/W。

对比之下,IBM 此前推出的 14nm 芯片在 fp32 和 fp8 精度下的每秒浮点运算次数,分别为 2TFLOPS 和 3TFLOPS;在在 fp32 精度下的能效比为 1.4TFLOPS/W。

另外,在 7nm 芯片阵营中,NVIDIA A100 GPU 在 fp16 精度下的能效比为 0.78TFLOPS/W,在 int4 精度下的能效比为 3.12TOPS/W,均低于 IBM 新款高能效 AI 芯片。

▲ IBM 新款高能效 AI 芯片与同类产品的性能参数对比

二、采用 IBM 自研超低精度训练 / 推理设计

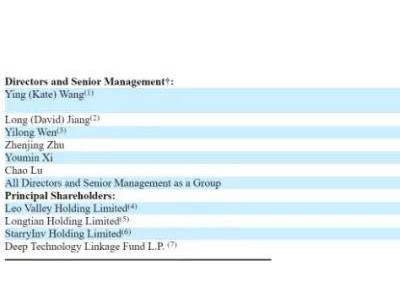

IBM 官网文章写道,其新款 AI 芯片之所以能够兼顾能效和性能,是因为该芯片支持超低精度混合 8 位浮点格式((HFP8,hybrid FP8)。这是 IBM 于 2019 年发布的一种高度优化设计,允许 AI 芯片在低精度下完成训练任务和不同 AI 模型的推理任务,同时避免任何质量损失。

据悉,目前 IBM 将超低精度混合 8 位浮点格式用于训练、超低精度混合 4 位浮点格式用于推理,并开发了数据通信协议,以提升多核心 AI 芯片上不同核心间的数据交换效率。

据 IBM 官网文章,自 2015 年起,该公司每年将芯片的功耗性能提升 2.5 倍。这背后,IBM 致力于实现算法、架构、软件堆栈等各方面的创新。

▲ IBM 在低精度 AI 训练、推理方面的研究历程

除了采用超低精度混合 8 位浮点格式外,IBM 新款高能效 AI 芯片添加了电源管理功能。IBM 研究显示,在同等功率的情况下,通过减缓计算阶段的功率消耗,可以最大限度地提升芯片性能。

结语:AI 发展对芯片能耗提出更高要求

随着智能化浪潮席卷各个领域,AI 模型的复杂性日趋提高。相应地,AI 应用的能源消耗水平亦水涨船高。这一背景下,如何最大限度提升能效,成为 AI 芯片设计玩家们面临的重要命题。

IBM 通过采用超低精度混合 8 位浮点格式和内置电源管理功能,为其新款 AI 芯片实现了业界领先的高能效。但是,这一芯片尚未实现规模化量产,仍有待市场检验。