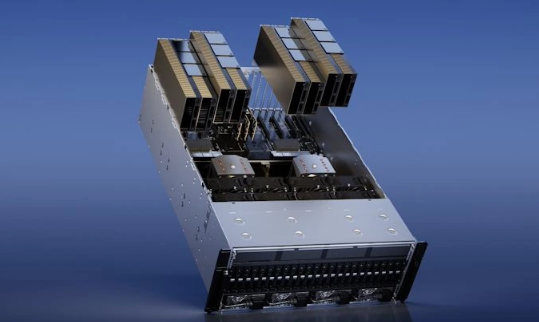

【ITBEAR科技资讯】3月22日消息,英伟达在GTC Spring 2023主题演讲中推出了全新的双GPU产品H100 NVL,该产品可满足不断增长的人工智能市场需求。据悉,H100 NVL在顶部配备了3个NVlink连接器,使用两个相邻的PCIe显卡插槽。H100 NVL最高可提供188GB HBM3显存,单卡显存容量为94GB。这在运行大型语言模型(LLM)时非常重要,因为常规显卡的显存无法驾驭庞大的数据流。H100 NVL的显存容量更高,能够满足这种需求。

H100 NVL的功耗略高于H100 PCIe,每个GPU的功耗为350-400瓦(可配置),比H100 PCIe增加了50W。然而,总性能实际上是H100 SXM的两倍。FP64为134 teraflops,TF32为1979 teraflops,FP8为7916 teraflops,INT8为7916 teraops。此外,内存带宽也比H100 PCIe高得多,每个GPU为3.9TB/s,总和为7.8TB/s,而H100 PCIe仅为2TB/s,H100 SXM为3.35TB/s。

据ITBEAR科技资讯了解,H100 NVL为大型语言模型等需要大量显存的应用提供了更好的解决方案,同时提供了高性能和高内存带宽。这将使研究人员更容易处理海量数据,训练出更准确的模型,从而加速人工智能的发展。英伟达表示,H100 NVL已经开始出货,但并未透露其价格。