【ITBEAR科技资讯】3月10日消息,热门聊天机器人ChatGPT的日处理请求量已突破2亿次,而其惊人的电量消耗也随之浮出水面。据The New Yorker报道,ChatGPT每天的电量消耗可能高达50万千瓦时,这一数字令人咋舌。要知道,美国普通家庭的日均用电量仅为29千瓦时,这意味着ChatGPT的能耗是普通家庭的近1.7万倍。

随着生成式人工智能技术的广泛应用,其电量消耗问题日益凸显。荷兰中央银行数据科学家Alex de Vries在《焦耳》期刊上发表的论文中指出,如果谷歌将其应用于所有搜索,每年的电量消耗将达到惊人的290亿千瓦时。这个电量足以匹敌肯尼亚、危地马拉和克罗地亚三国的年总发电量。

然而,要准确评估蓬勃发展的AI行业的实际电量消耗却并非易事。据ITBEAR科技资讯了解,尽管大型科技公司在AI领域处于领先地位,但它们对于自身的能源消耗情况却讳莫如深。此外,不同的人工智能模型在运行方式上也存在巨大差异,这使得电量消耗的估算变得更加复杂。

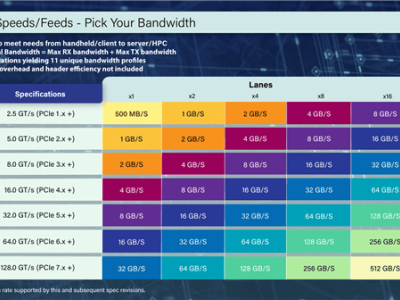

尽管如此,de Vries还是根据英伟达公布的数字进行了粗略计算。据CNBC报道援引New Street Research的数据,英伟达在图形处理器市场份额中占据了约95%的份额。de Vries估计,到2027年,整个AI行业的电量消耗将达到85至134太瓦时之间。这是一个相当可观的数字,甚至可能占到全球电量的一半左右。

与世界上一些耗电量最大的企业相比,AI行业的电量消耗也显得尤为突出。据Businessinsider基于消费者能源解决方案报告的计算,三星的年耗电量接近23太瓦时,而谷歌等科技巨头的数据中心、网络和用户设备每年的耗电量也略高于12太瓦时。微软的耗电量则略高于10太瓦时。尽管如此,与AI行业未来的电量消耗相比,这些数字仍然相形见绌。