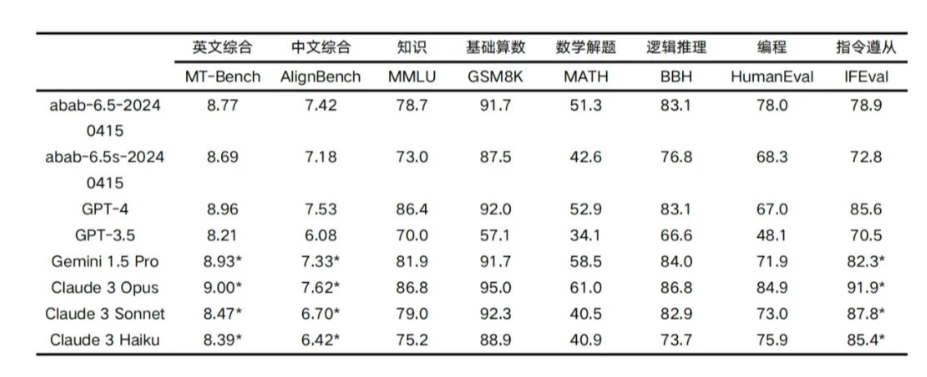

【ITBEAR科技资讯】4月17日消息,国内AI初创企业MiniMax稀宇科技今日宣布,他们已成功研发出基于MoE(Mixture of Experts)混合专家模型架构的abab 6.5系列模型,这标志着该公司在人工智能领域取得了重要突破。据悉,该系列模型的核心能力已经开始接近当前领先的GPT-4、Claude-3和Gemini-1.5等模型。

abab 6.5系列包含两个重要模型:abab 6.5和abab 6.5s。其中,abab 6.5模型拥有万亿级别的参数,能够支持长达200k tokens的上下文长度,展现出强大的语言处理能力。而abab 6.5s模型则在保持与abab 6.5相同训练技术和数据的基础上,实现了更高的效率。它同样支持200k tokens的上下文长度,并且能在1秒内处理近3万字的文本,为实时、高效的语言处理提供了可能。

据ITBEAR科技资讯了解,自今年1月MiniMax发布国内首个基于MoE架构的abab 6模型以来,该公司一直致力于通过改进模型架构、重构数据pipeline、优化训练算法及并行训练策略等手段,加速Scaling Laws的过程。这一系列努力终于取得了阶段性的成果,即abab 6.5系列的诞生。

为了验证abab 6.5系列模型的性能,MiniMax官方进行了业界常用的“大海捞针”测试。在该测试中,官方在一段很长的文本中插入一个与该文本无关的句子,并尝试通过自然语言向模型提问,以检验模型是否能够准确找出这个“针”。经过891次测试,abab 6.5均能够准确地回答出这个“针”,展现出极高的精确度和可靠性。

随着abab 6.5与abab 6.5s模型的推出,MiniMax稀宇科技将进一步巩固其在人工智能领域的地位。这两个模型将陆续更新至MiniMax旗下的产品中,包括海螺AI和MiniMax开放平台。