【ITBEAR】微软近日宣布了一项重大开源项目——OmniParser,这是一款专为解析和识别屏幕上可交互图标设计的AI工具。传统自动化方法受限于HTML或视图层次结构,而现有的视觉语言模型在处理复杂GUI元素时又显得力不从心。为此,微软推出了这款纯视觉基础的工具,旨在解决当前屏幕解析技术的局限性。

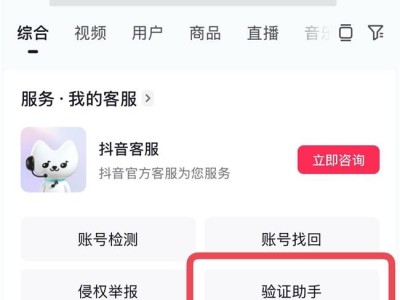

OmniParser结合了可交互区域检测模型、图标描述模型和OCR模块,无需依赖HTML标签或视图层次结构等显式基础数据。这一特性使得它能够在桌面、移动设备和网页等多种平台上跨平台工作,显著提高了用户界面的解析准确性。OmniParser还能将识别出的屏幕元素转换成结构化的数据。

在实际测试中,OmniParser展现出了卓越的性能。在ScreenSpot数据集中,它的准确率提高了73%,远超依赖HTML解析的模型。同时,当GPT-4V使用OmniParser的输出后,图标的正确标记率从70.5%提升至93.8%。这些改进充分证明了OmniParser在解决当前GUI交互模型根本缺陷方面的有效性。

微软已在Hugging Face上发布了OmniParser,这一举措将有助于普及这一前沿技术,进一步推动多模态AI的发展,特别是在无障碍、自动化和智能用户辅助等领域。