【ITBEAR】近期,人工智能技术的迅猛发展使得多模态技术成为业界瞩目的焦点。在这一背景下,度小满凭借其在多模态领域的深厚积累,携手哈尔滨工业大学,成功研发出一款名为SmartTrim的自适应剪枝算法。

SmartTrim算法的出现,旨在解决视觉语言大模型(VLM)在研究和应用中面临的高计算成本问题。该算法通过智能分析模型中各层的token表示和attention head的冗余性,有效削减了多模态大模型中的冗余计算,从而实现了计算效率的显著提升。相关研究成果已在国际自然语言处理领域的顶级会议COLING 24上发表。

在基于VQA微调的METER的跨模态编码器中,层内不同token和attention head表示的相似性示意图

SmartTrim算法的核心在于其自适应剪枝能力。该算法通过两个关键组件——跨模态感知的Token修剪器和模态自适应的注意力头修剪器,实现了对模型中不必要计算负担的智能识别与剪除。Token修剪器利用多层感知器(MLP)结构,综合考虑Token在单一模态序列中的独立重要性及其在跨模态交互中的贡献,智能地识别并去除那些对当前层不重要的Token。而注意力头修剪器则直接集成在模型的自注意力模块中,评估并修剪那些冗余的注意力头,进一步优化了模型的计算效率。

SmartTrim框架结构图

在训练SmartTrim模型时,研究人员采用了一种创新的双重优化策略,该策略结合了任务相关目标和计算开销目标,通过重参数化技巧解决了不可导二值mask的问题,实现了模型的端到端训练。自蒸馏和课程学习策略的引入,进一步提高了剪枝后模型的性能,确保了训练过程的稳定性和高效性。

Token的逐步裁剪修剪过程示意图

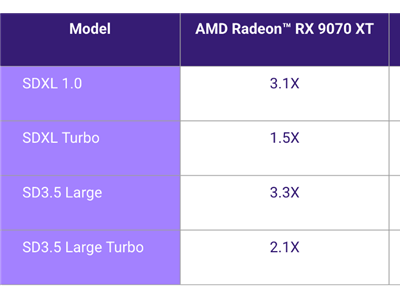

实验结果表明,SmartTrim算法在METER和BLIP两个VLM上实现了2-3倍的加速效果,同时成功将性能损失降至最低。在1.5倍加速比下,SmartTrim的性能甚至超过了原始模型,展现出其在高加速比下的显著优势。这一成果不仅为理论研究提供了新的视角,也为实际应用中的模型优化提供了切实可行的解决方案。

度小满表示,SmartTrim技术的推出标志着多模态大模型研究迈出了重要的一步。未来,度小满计划将SmartTrim技术整合到公司的轩辕大模型中,以进一步提升大模型技术的性能和应用效果。这一举措将有望为金融领域带来全新的变革和发展机遇。