Hugging Face,这一在人工智能领域备受瞩目的平台,近期宣布了一项重大进展:他们成功研发并开源了一款名为SmolVLM的创新视觉语言模型。此举意味着,广大研究者与技术开发者将能够自由访问该模型的全部资源,包括模型检查点、数据集、训练方法及配套工具,所有内容均遵循Apache 2.0许可协议。

在架构设计上,SmolVLM巧妙融合了Idefics3的先进理念,并选用了性能卓越的SmolLM2 1.7B作为其语言处理的核心。该模型通过引入一项创新的像素混洗技术,实现了视觉信息的高效压缩,压缩率惊人地提升了9倍,从而大幅提高了处理速度。

为了训练这一强大的模型,Hugging Face精心挑选了Cauldron和Docmatix两个大型数据集。他们还对SmolLM2进行了上下文扩展,使其能够轻松应对更长的文本输入以及多张图像的处理需求。这些优化措施不仅显著降低了内存占用,还有效解决了大型模型在普通设备上运行时的性能瓶颈问题。

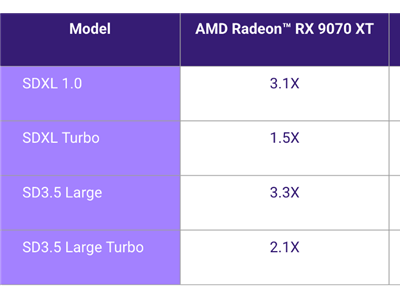

在内存管理方面,SmolVLM展现出了令人惊叹的能力。它能够将384x384像素的图像块高效编码为81个tokens,这一表现在同类模型中堪称佼佼者。在与知名模型Qwen2-VL的对比测试中,SmolVLM在相同测试图片下的内存占用大幅降低。在多项基准测试中,SmolVLM更是展现出了卓越的性能优势:其预填充吞吐量比Qwen2-VL快了3.3至4.5倍,而生成吞吐量更是达到了惊人的7.5至16倍提升。