近日,月之暗面科技公司正式推出了其最新研发的视觉思考模型k1,这一创新成果基于先进的强化学习技术,旨在实现端到端的图像理解和思维链技术的原生支持,并将应用范围拓展至数学以外的多个基础科学领域。

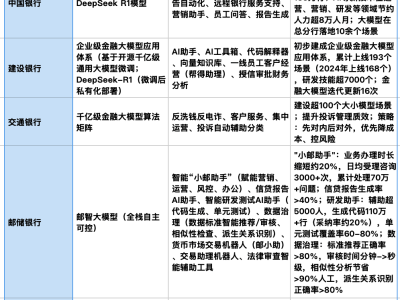

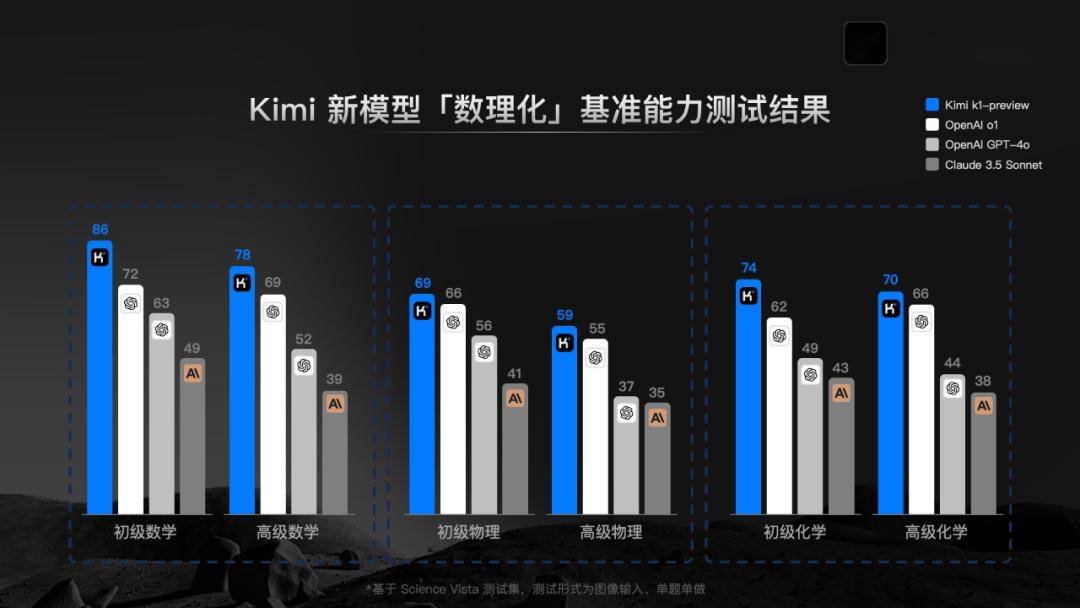

据月之暗面官方透露,k1模型在基础科学学科的基准测试中表现出色,其性能已经超越了OpenAI的o1、GPT-4o以及Claude 3.5 Sonnet等业界知名模型。这一成就标志着k1模型在理解和解答科学问题上的能力迈上了一个新台阶。

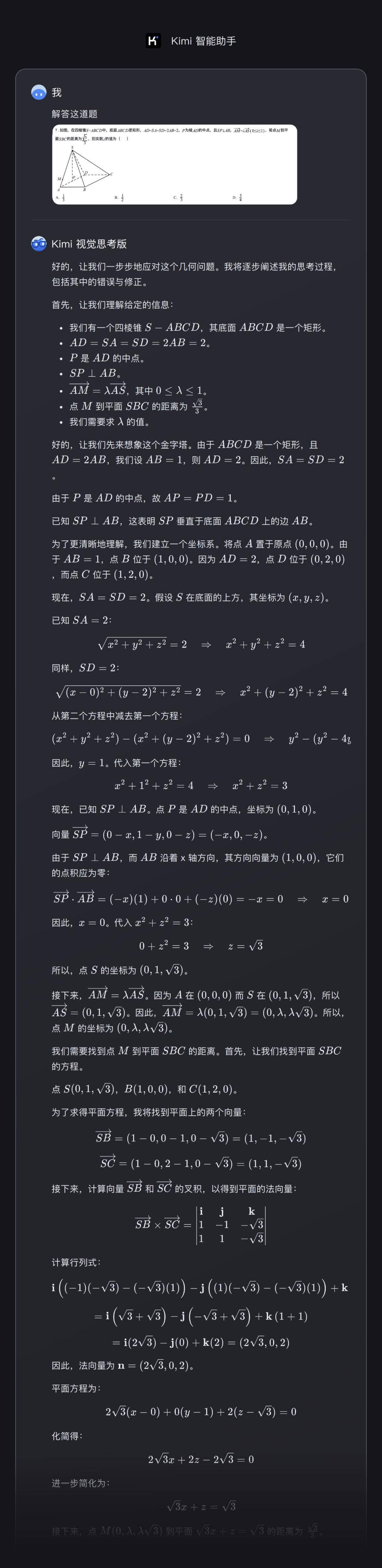

k1视觉思考模型一经发布即上线,用户可以在最新版“Kimi智能助手”的Android和iPhone手机App以及网页版kimi.com上体验到这一新功能。用户只需在App或网页版中找到“Kimi视觉思考版”,即可通过拍照或上传图片进行体验。该模型不仅能够给出答题结果,还能完整展示推理思维链CoT,让用户清晰看到模型思索答案的全过程。

从模型训练的角度来看,k1视觉思考模型的训练过程经过了两个阶段的精心打磨。首先,通过预训练得到基础模型,然后在基础模型上进行强化学习后训练。在基础模型阶段,k1特别优化了字符识别能力,在OCRBench上取得了903分的优异成绩。同时,在MathVista-testmini、MMMU-val和DocVQA等基准测试集上,k1也分别获得了69.1、66.7和96.9的高分。

月之暗面在k1的强化学习后训练阶段也进行了诸多优化,特别是在数据质量和学习效率方面取得了显著进步。同时,公司在强化学习的规模化上实现了新的突破,为k1模型的高性能表现奠定了坚实基础。

在科学模型能力基准测试方案方面,月之暗面也面临着行业内的重要挑战。由于市场上缺乏针对基础科学学科的图形测试集,Kimi模型研发团队自主构建了一个标准化的测试集Science Vista。该测试集涵盖了不同难度的数理化图片题目,且与实际用户需求较为匹配。月之暗面表示,该测试集将开放给全行业使用,以推动基础科学领域大模型技术的发展。

然而,在内部测试中,月之暗面也发现了k1视觉思考模型存在的一些局限性。例如,在分布外问题的泛化能力、复杂问题的成功率、噪声场景的准确率以及多轮问答效果等方面,k1仍有较大的提升空间。与OpenAI的o1系列模型相比,k1在某些场景和泛化能力上仍存在一定差距。月之暗面表示,将继续努力优化模型性能,为用户提供更加高效、准确的视觉思考服务。