在人工智能领域的激烈竞争中,英伟达这一巨头似乎依然稳坐钓鱼台,然而2025年的AI算力市场正酝酿着重大转变。行业的焦点正逐渐从模型训练转向模型推理,这一趋势为众多专注于推理的“小”芯片公司提供了崭露头角的机会。

模型推理,作为AI技术商业化的关键阶段,其重要性日益凸显。无论是OpenAI的o1和o3模型,还是Google的Gemini 2.0 Flash Thinking,都在通过增强推理策略来提升训练后的结果质量。这意味着,AI工作负载的格局正在发生深刻变化,推理计算需求将快速增长,并有望超过训练计算需求。

据巴克莱研报显示,AI推理计算需求将迅速提升,预计其将占据通用人工智能总计算需求的70%以上,甚至可能达到训练计算需求的4.5倍。这一转变,为那些拥有强大推理能力的芯片公司提供了广阔的发展空间。

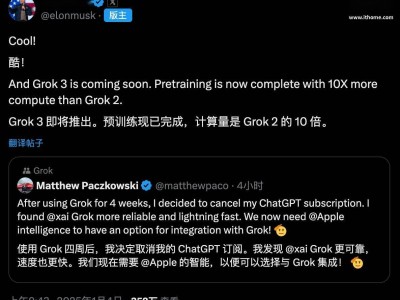

在这场竞争中,Groq、SambaNova和Positron AI等初创公司纷纷向英伟达亮出了挑战的姿态。Groq,这家由前谷歌TPU核心团队创办的公司,以其号称“世界最快推理”的AI推理引擎LPU,吸引了众多目光。Groq的LPU不仅在大模型速度上表现出色,还拥有远低于GPU的token成本。2024年,Groq更是推出了一款名为“猛兽”(Beast)的高性能计算芯片,据称在AI推理任务中的性能超越了英伟达的某些主流GPU。

然而,Groq也面临着一些质疑。虽然其创始人宣称LPU的速度和能效远超英伟达GPU,但一些专家指出,Groq的架构建立在小内存、大算力上,对于大模型的推理部署可能需要大量芯片并联,从而增加了硬件成本和能耗成本。尽管如此,Groq依然坚持其技术优势,并期待市场能够更快地接受这种优先考虑效率和可持续性的技术。

与Groq相比,SambaNova则显得更为野心勃勃。这家公司不仅提供定制的技术堆栈,从芯片到服务器系统,甚至包括部署大模型,还以其RDU架构的高性能和可持续性吸引了众多大客户。SambaNova的RDU架构拥有GPU 10倍以上的片上分布SRAM,以及适用于大规模计算任务的HBM,使得其在性能上相较于GPU有了2-4倍的优势。目前,SambaNova已经赢得了包括世界排名前列的超算实验室在内的大客户。

而Positron AI,虽然成立时间较晚,但同样展现出了强大的竞争力。其推出的推理芯片声称可以执行与英伟达H100相同的计算,但成本仅为五分之一。Positron AI的愿景是让人人负担得起AI推理,其CEO Thomas Sohmers表示,通过提供更多专用于推理的计算资源,将能够推动AI技术的广泛采用。

面对这些挑战者,英伟达似乎并未感到太大的压力。近日,英伟达推出了专为推理大模型打造的B300系列芯片,相较于B200在算力上提高了50%,显存也从192GB提升到288GB。这款芯片将有效提升大模型的推理性能,降低推理成本,提高模型能力。

然而,英伟达也并非高枕无忧。随着AI技术的不断发展和应用领域的不断拓展,市场对AI芯片的需求也在不断变化。英伟达需要不断创新和升级其产品,以满足市场的多样化需求。同时,也需要警惕来自其他芯片公司的竞争和挑战。