在2024年初,一个名为Gunnar Morling的开发者发布了一项名为“十亿行挑战”(The One Billion Row Challenge,简称1BRC)的编程竞赛,迅速引起了技术社区的广泛关注。这项挑战要求参赛者解析一个包含十亿行气象站温度数据的大文件,并计算每个气象站的最小、最大和平均温度,最后按字典序输出结果。

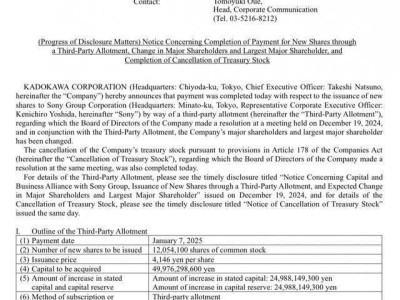

挑战的核心文件是一个巨大的文本文件,每行记录一个气象站及其对应的温度值,格式简单明了:气象站名称与温度值之间用分号分隔,温度值保留一位小数。尽管需求看似简单,但文件的大小却达到了惊人的13GB,对于普通计算机来说,处理如此庞大的数据集无疑是一项艰巨的任务。

官方提供了一个基线版本的Java代码,使用流式编程和`groupingBy`方法进行数据处理,避免了浮点计算以提高效率。然而,即使在高性能的服务器上,该基线版本也需要大约2分钟才能完成处理。相比之下,普通计算机上的运行时间更是接近14分钟。

然而,真正的挑战才刚刚开始。当比赛结果公布时,人们惊讶地发现,一些参赛者竟然能在短短几秒内完成这项任务。其中,第一名选手在1.5秒内就完成了整个处理过程,这一成绩让许多人难以置信。毕竟,光是读取13GB的文件也需要一定时间,更不用说解析和计算了。

为了揭开这些高手的秘密,我们深入研究了他们的代码。尽管这些代码对于普通开发者来说可能难以理解,但它们的优化思路却值得我们学习。例如,第一名选手的代码采用了多种高级优化技术,包括并行I/O、内存映射、位运算等,极大地提高了数据处理速度。

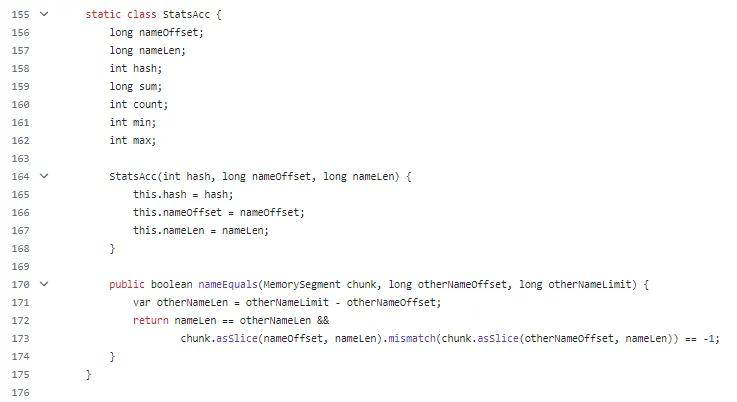

其中一位名为Marko Topolnik的参赛者,在比赛结束后继续优化他的代码,最终将运行时间缩短到了1.7秒。他详细记录了自己的优化过程,从最初的71秒到最终的1.7秒,每一步都充满了智慧和汗水。他的优化策略包括更换JVM、并行I/O、优化温度解析方法、自定义哈希表以及使用`Unsafe`和SWAR技术等。

Marko Topolnik的优化过程充分展示了数据指标的重要性。他通过收集和分析程序的运行指标,找到了性能瓶颈,并针对性地进行了优化。例如,他通过火焰图发现`BufferedReader`占用了大量性能,于是采用了并行I/O和内存映射技术来提高读取速度。同时,他还通过自定义哈希表和位运算技术来减少内存消耗和提高计算速度。

这些高手的代码虽然难以理解,但他们的优化思路却对我们有很大的启发。他们教会我们如何在面对庞大数据集时,通过巧妙的算法和高效的编程技巧来提高数据处理速度。这些经验不仅对于参加编程竞赛有用,更对于我们日常的工作和学习具有重要的指导意义。

通过这次挑战,我们不仅见识到了高手们的编程实力,更深刻体会到了技术优化的魅力和重要性。在未来的工作中,我们或许不会经常遇到如此庞大的数据集,但掌握这些优化技巧无疑会让我们在处理各种复杂问题时更加得心应手。