近期,国内AI领域迎来了一位重量级新成员——DeepSeek-R1大模型,其由幻方量化旗下DeepSeek公司精心打造,一问世便迅速吸引了业界的广泛关注。令人瞩目的是,芯动力公司在极短时间内成功完成了与DeepSeek-R1的适配工作,展现了其在AI技术领域的强大实力。

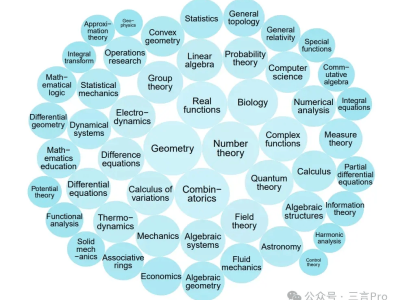

DeepSeek-R1作为DeepSeek公司推出的系列推理模型佼佼者,采用了先进的强化学习训练方式,其推理过程中融入了丰富的反思与验证环节,思维链长度惊人,可达数万字之巨。在数学运算、代码编写以及复杂逻辑推理等任务上,DeepSeek-R1展现出了与OpenAI o1相媲美的卓越推理能力,更能够为用户详尽展示其思考过程,极大地提升了用户体验。在1月24日的Arena基准测试中,DeepSeek-R1表现出色,整体排名跃升至全类别大模型第三位,尤其在风格控制类模型(StyleCtrl)分类中,更是与OpenAI o1齐头并进,共同占据榜首位置。

随着AI技术的飞速发展,大模型的训练成本逐渐降低,商业化门槛也随之放宽。大模型作为技术基石,为各行各业的应用创新提供了无限可能,边缘大模型因此逐渐成为业界的主流趋势。芯动力公司所设计的芯片恰好满足了这一开发应用需求,为AI技术的普及与应用奠定了坚实基础。

芯动力公司此次能够迅速完成与DeepSeek-R1的适配,离不开AzureBlade K340L M.2加速卡的强大支持。这款高性能AI加速卡实现了高性能、低功耗与小体积的完美结合,堪称业界翘楚。其内置的AE7100芯片虽然体积仅相当于半张名片大小(22mm×80mm),但算力却高达32TOPs,功耗更是控制在8w以下。AzureBlade K340L加速卡采用标准M.2接口设计,便于集成到各种设备中,成为业界最小、最薄的GPU之一。该加速卡全面兼容CUDA和ONNX标准,能够满足各类AI应用需求。其高算力与内存带宽确保了数据的高效稳定处理与传输,为AI技术的广泛应用提供了有力保障。

目前,AzureBlade K340L加速卡已经成功支撑大模型在AI PC等设备上运行,并顺利适配了DeepSeek-R1、Llama 3-8B、Stable Diffusion、通义千问等开源模型。该加速卡还在工业自动化、泛安防、内容过滤、医疗影像以及信号处理等多个领域得到了广泛应用,展现了其强大的跨领域适应能力。

AzureBlade K340L加速卡的卓越性能与广泛适用性,使其在大模型端侧设备部署中发挥着举足轻重的作用。它不仅助力AI技术在更多场景中落地生根,更推动了AI技术的持续发展与广泛应用,为AI应用开启了全新的篇章。可以预见,在未来的AI技术发展中,AzureBlade K340L加速卡将继续发挥关键作用,为AI技术的创新与应用注入新的活力。