近日,豆包大模型团队携手北京交通大学与中国科学技术大学,共同研发的视频生成实验模型“VideoWorld”正式宣布开源。这一创新成果在业界树立了新的里程碑,它首次实现了无需语言模型辅助,即可实现对世界的认知。

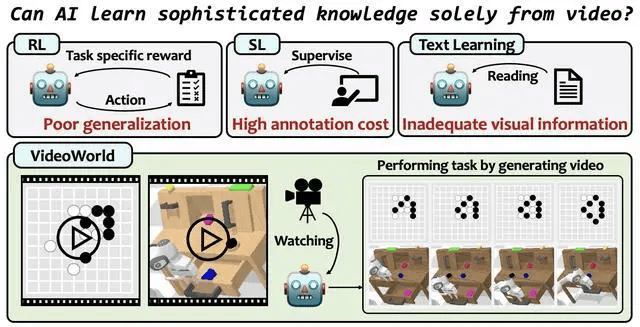

传统的多模态模型,如Sora、DALL-E和Midjourney等,大多依赖于语言或标签数据来获取知识。然而,语言作为一种表达工具,其局限性在于无法全面捕捉真实世界中的所有复杂信息。例如,折纸艺术或打领结等细致入微的技巧,往往难以通过语言进行精确描述。而VideoWorld则打破了这一限制,它摒弃了语言模型,通过纯视觉信号进行统一的理解、执行和推理。

VideoWorld的核心优势在于其独特的潜在动态模型。这一模型能够高效地压缩视频帧间的变化信息,从而显著提升知识学习的效率和效果。这一突破性的技术使得VideoWorld在无需依赖强化学习搜索或奖励函数机制的情况下,依然能够达到专业级的围棋水平——在5段9x9围棋比赛中表现出色。它还能在多种复杂环境中执行机器人任务,展现出强大的应用潜力。

这一成果的发布,标志着视频生成技术迈向了一个新的发展阶段。VideoWorld不仅为学术界提供了新的研究方向和思路,同时也为工业界带来了广阔的应用前景。随着技术的不断成熟和完善,相信VideoWorld将在更多领域发挥重要作用,推动人工智能技术的进一步发展。