近日,字节跳动旗下的豆包大模型团队对外公布了一项重大技术突破,他们研发出了一种名为UltraMem的全新稀疏模型架构。这一创新架构旨在解决当前混合专家(MoE)模型在推理过程中面临的高昂访存问题,为提升AI模型的推理速度和降低成本提供了新的解决方案。

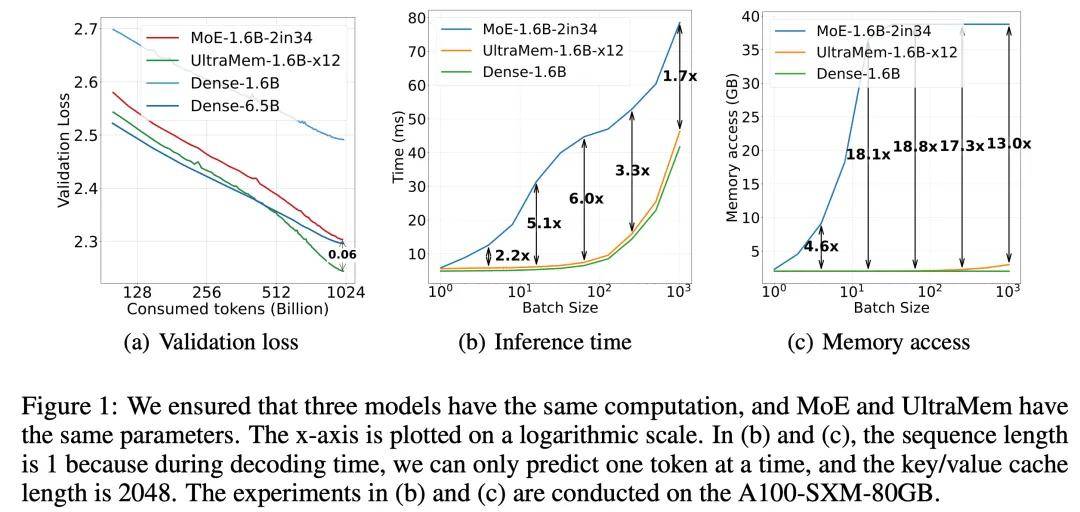

据悉,UltraMem架构通过独特的设计,成功实现了计算与参数的解耦,从而在保持模型效果的同时,显著降低了推理时的访存需求。与传统的MoE架构相比,UltraMem在推理速度上实现了2至6倍的提升,推理成本最高可降低83%。这一成果不仅彰显了UltraMem在性能上的优势,更为构建大规模AI模型开辟了全新的路径。

实验数据表明,当UltraMem模型的训练规模达到2000万value时,它在同等计算资源下展现出了业界领先的推理速度和模型性能。这一突破性的表现,预示着UltraMem在构建数十亿规模value或expert的AI模型方面具有巨大的潜力。

UltraMem架构的核心优势在于其高效的内存访问机制。在参数和激活条件相同的情况下,UltraMem不仅超越了MoE模型在效果上的表现,还显著提升了推理速度。在常见的batch size规模下,UltraMem的访存成本几乎与同计算量的Dense模型相当,这一特点使得UltraMem在实际应用中具有更高的性价比。

在Transformer架构的背景下,模型的性能往往与其参数数量和计算复杂度密切相关。然而,随着大型语言模型(LLM)规模的不断扩大,推理成本急剧增加,速度也随之变慢。MoE架构虽然通过将计算和参数解耦在一定程度上缓解了这一问题,但在推理时仍面临较小的batch size激活全部专家导致的访存急剧上升和推理延迟大幅增加的挑战。

UltraMem架构的推出,正是针对这一挑战提出的解决方案。它不仅继承了MoE架构在计算和参数解耦方面的优势,还通过优化内存访问机制,显著降低了推理时的访存成本和延迟。这一创新成果不仅为AI模型的发展注入了新的活力,也为未来AI技术的应用提供了更加高效、经济的解决方案。