在2025年,中文大模型领域迎来了一场颠覆性的变革。DeepSeek的横空出世,不仅打破了英伟达在算力方面的垄断地位,还撼动了美国在大模型领域的长期主导地位。这一创新甚至引发了全球大模型领域的价格战,使得更多人能够享受到大模型带来的便利和乐趣。

从社交媒体的反应来看,DeepSeek确实将“人工智能”这一曾经遥不可及的概念带到了普通大众的身边。即使是像我这样的技术爱好者,也在春节期间频繁向家人和亲戚介绍DeepSeek,并时常拿起手机体验这一智能工具。DeepSeek能够在不收费的基础上提供高质量的中文问答,这在目前市场上是独一无二的。

然而,DeepSeek也并非完美无缺。服务器问题成为了用户的一大困扰。当请求发出后,长时间的等待却只能换来“服务器繁忙,请稍后再试”的提示,这种挫败感让人迫切想要拥有一个属于自己的本地DeepSeek推理模型。

对于普通消费者来说,购置一台能够运行大模型的设备成本高昂。要么选择售价在5000元以上的AI PC笔记本,要么自己动手组装一台搭载独立显卡的整机。但幸运的是,对于DIY玩家来说,挑战极限预算并组装出“能用”的主机,正是他们的乐趣所在。

我决定尝试用400元的预算来打造一台能够运行DeepSeek模型的电脑。尽管近期内存和硬盘价格有所上涨,但一些老旧硬件的价格却相对稳定,甚至有所下降。我决定挑战这一极限预算,看能否成功组装出性价比颇高的入门级本地大模型主机。

在硬件选择上,我选择了Intel Core i3-4170处理器,这款二核四线程的处理器虽然规格老旧,但具备3MB智能缓存和HD4400核显,售价仅为22元。主板方面,我选择了铭瑄MS-H81M Turbo,售价79元,虽然接口有限,但性价比极高。散热器则选择了14.9元的双热管风冷散热器,足以应对这套低价配置。

显卡方面,我选择了闲鱼上的技嘉P106-100矿卡,售价130元。这款显卡具备6GB显存,足以应对本地大模型的运行需求。内存方面,我选择了两根杂牌DDR3内存组成双通道,电源则选择了300W的长城电源,硬盘则是一块120GB的SATA SSD。

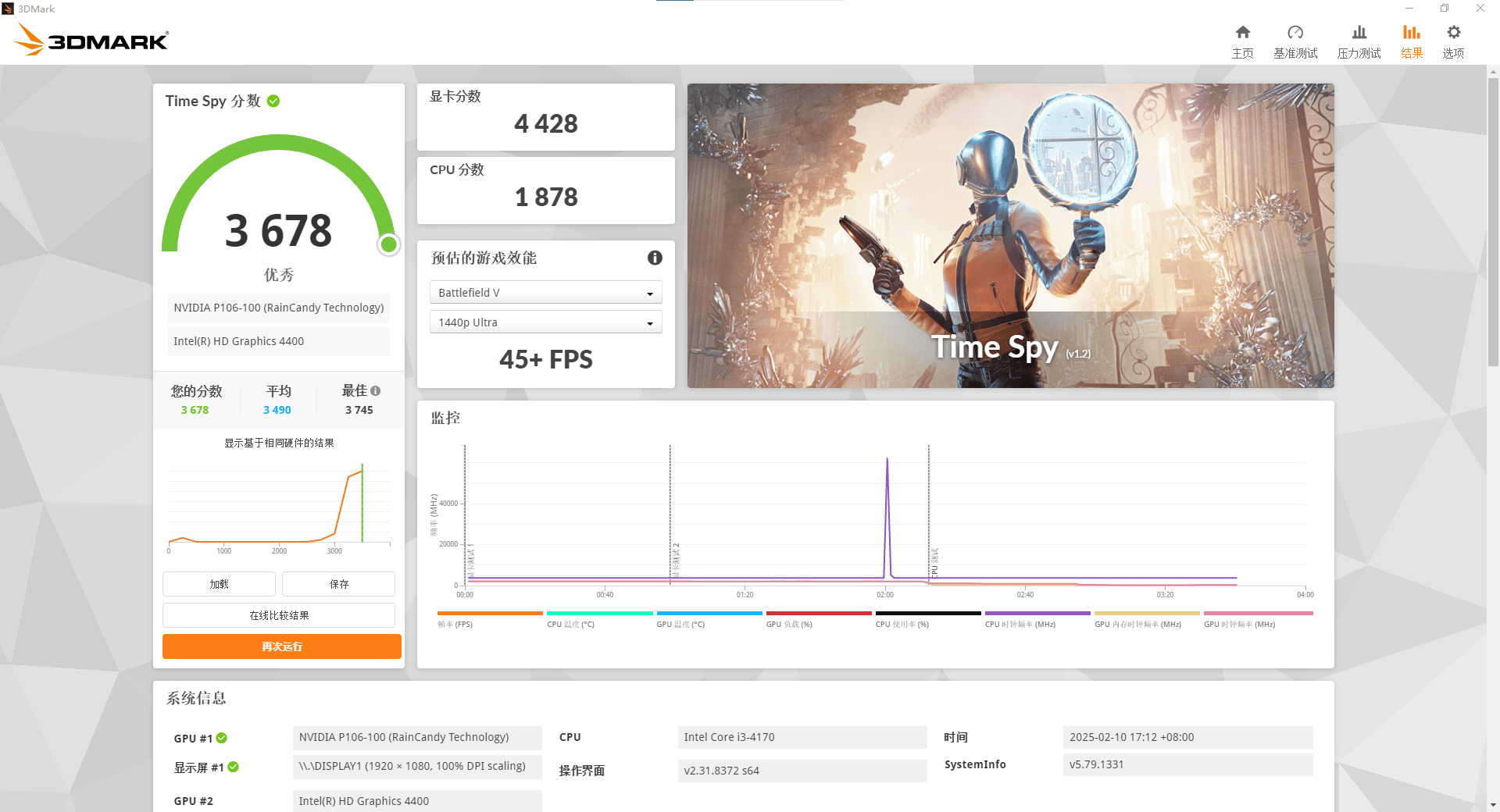

组装完成后,我对这台电脑进行了简单的性能测试。CPU-Z测试显示单核跑分373.4分,多核跑分1025.2分。在CINEBENCH测试中,R20多核得分为824cb,单核得分为346cb;R23多核得分为1914cb,单核得分为905cb。虽然性能不算亮眼,但足以应对日常办公和轻度娱乐。

在GPU方面,技嘉P106-100在Fire Strike Extreme测试中取得了6490分的图形分数,在TimeSpy基本测试中取得了4428分的图形分数,性能与GTX1060相当,甚至能与移动端的RTX 3050一较高下。

接下来是DeepSeek的部署。由于真正的DeepSeek-R1模型需要大量计算资源和显存,我选择了使用蒸馏模型。DeepSeek-R1-Distil-Qwen-7B是表现最出色的蒸馏模型之一,适合在本地部署。

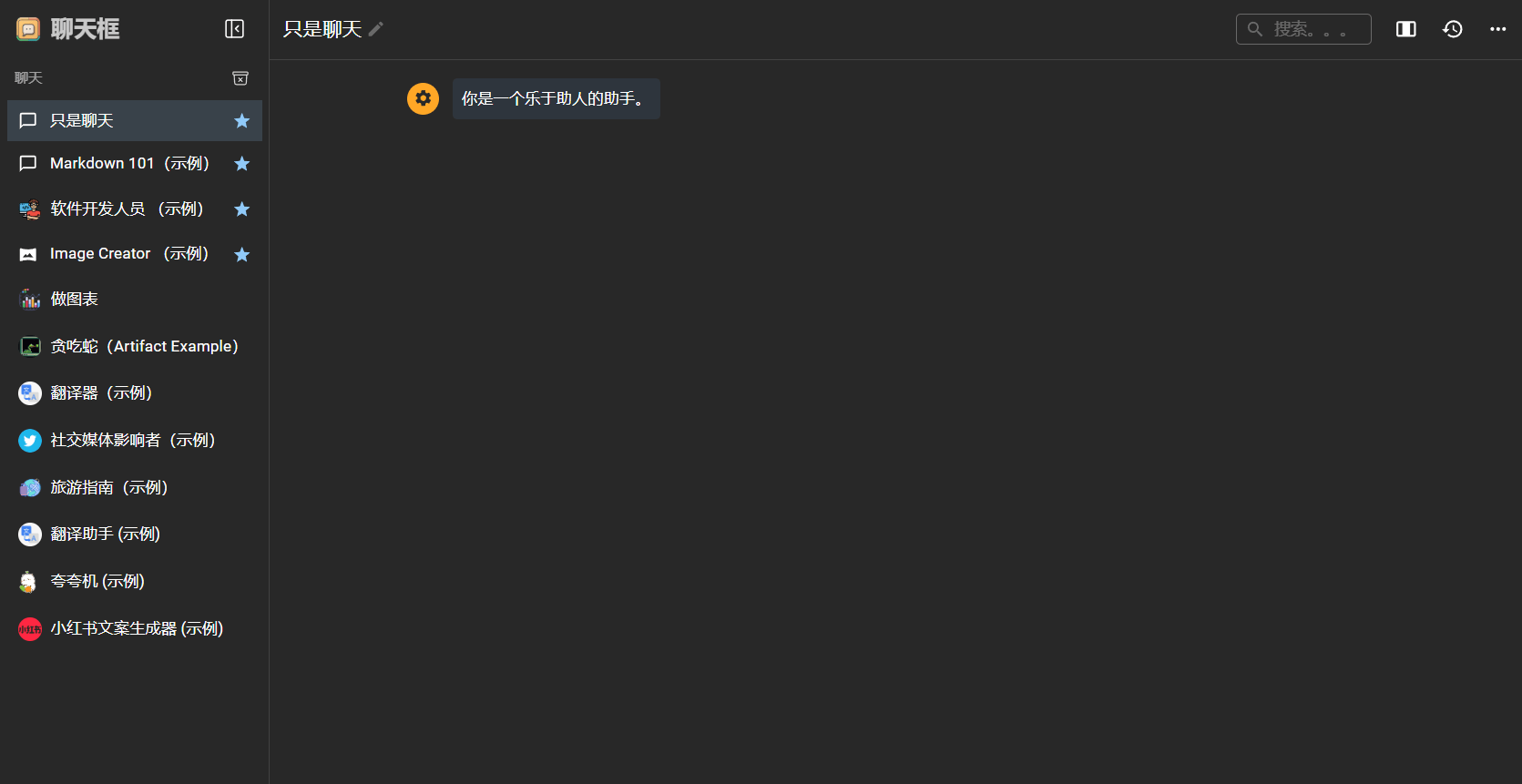

我选择了Ollama+Chatbox AI的组合来进行部署。Ollama是一款流行的本地大模型服务端工具,而Chatbox AI则是一款前端产品,提供了更直观的用户体验。安装完成后,我可以在Chatbox AI中定义自己想要交互的模型人设,并进行对话交流。

在实测中,本地部署的DeepSeek能够应对一些基础的初高中语文、数学、英语问题,但在复杂的数学和逻辑难题上表现一般。由于未联网,本地模型的知识库截至2023年,无法回答一些有时效性的问题。

尽管这台400元预算的电脑在性能上有所欠缺,但它确实能够运行本地DeepSeek模型,并为公司局域网内部的AI终端提供支持。同时,这台电脑还具备一定的游戏性能,可以在低画质下运行《孤岛惊魂6》等3A大作,以及流畅运行《英雄联盟》等网游。

然而,这台电脑也存在一些问题。矿卡驱动容易掉,导致电脑白屏,需要频繁卸载并重装驱动。二手电源也出现了问题,需要更换。因此,对于想要购买类似配置的用户来说,需要谨慎考虑。

总的来说,尽管这台400元预算的电脑在性能和稳定性上有所欠缺,但它确实证明了低配置也能运行本地大模型。对于DIY玩家来说,这无疑是一次有趣的挑战和尝试。