在DeepSeek掀起的技术风暴中,一个广泛流传的观点认为大模型的算力需求或许正面临泡沫,存在过剩风险。然而,深入分析这一现象,我们发现事实远非如此简单。

DeepSeek-V3和R1模型的横空出世,打破了“算力即霸权,规模即壁垒”的行业信条。DeepSeek以不到行业平均十分之一的成本,训练出了效果卓越的大模型,这无疑引发了对算力逻辑的深刻反思。英伟达等传统算力巨头的股价因此受挫,市场担忧算力需求下滑;而国产算力企业如海光信息、华为昇腾等,因成功适配DeepSeek模型,股价飙升或备受瞩目。

这一分化现象揭示了业界对算力认知的转变,从过去的“规模至上”转变为“效率优先”。然而,算力需求的本质并未消失,而是以更加复杂的形式重塑。DeepSeek的贡献不仅在于算法优化,更在于它大大降低了大模型的门槛,推动了大模型能力的普及。

以往,具备相同能力的大模型要么效果不佳,要么采取闭源收费策略,如GPT-4o。DeepSeek的出现迫使这些模型改变策略。同时,DeepSeek的低成本也激发了更多用户尝试大模型的热情。中信建投指出,DeepSeek R1之所以能以较少的算力实现高性能,关键在于其算法、框架和硬件的协同优化。

DeepSeek R1在算法层面引入了专家混合模型、多头隐式注意力、多token预测等技术;在框架层面实现了FP8混合精度训练;在硬件层面则采用了优化的流水线并行策略,并高效配置了专家分发与跨节点通信。当前,大模型行业正处于从生成式模型向深度推理模型过渡的阶段,算力需求也从预训练阶段逐步转向后训练和推理侧。DeepSeek R1通过协同优化,在特定阶段实现了高效算力利用,算力行业的长期增长逻辑依然稳固。

虽然单一模型的训练和推理算力需求在下降,但由此带来的技术普及却催生了更大的算力需求。一方面,基础大模型的竞争依然激烈,字节跳动、阿里巴巴等头部玩家仍在加码预训练,高端算力需求持续增长。另一方面,AI应用的普及推动了推理算力的需求激增。DeepSeek的全球日活用户迅速增长,尽管单个模型推理成本降低,但用户规模和场景复杂度的扩张使得整体算力消耗不减反增。

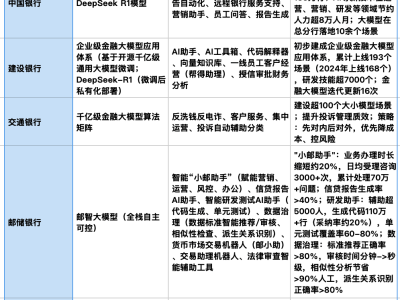

这一现象与经济学家威廉·斯坦利·杰文斯提出的“杰文斯悖论”不谋而合。该悖论指出,当技术进步提高效率时,资源消耗往往会激增。如今,AI算力支撑大模型的效率更高,但算力需求也进入了新一轮上升周期。DeepSeek的开源战略推动了其模型在教育、医疗、金融等领域的快速渗透,AI应用遍地开花。

例如,DeepSeek的视觉语言融合模型DeepSeek-VL2在工业质检中需要实时处理高分辨率图像数据;代码生成模型DeepSeek-Coder则需要支撑全球开发者的高频调用。这些场景对低延迟、高并发的需求迫使算力基础设施持续升级。某电商平台引入DeepSeek后,日均处理咨询量大幅提升,GPU集群规模也相应扩容。

DeepSeek的崛起无疑为中国AI产业注入了一剂强心针。国产AI算力厂商纷纷宣布适配DeepSeek,包括昇腾、海光、壁仞科技等多家企业。然而,在国产芯片融合方面,DeepSeek与其他国内大模型并无本质区别,其训练和推理在很大程度上依然依赖于英伟达GPU。国产AI芯片厂商要走出自己的路,关键在于底层架构要符合市场,上层软件要整体适用,并具备足够的标准化和开放性。

未来算力竞争将呈现三大趋势:一是效率竞赛转向场景战争,谁能更低成本激活边缘场景,谁将主导市场;二是硬件霸权让位于架构主权,模型定义硬件的能力比芯片制程更重要;三是国产替代升级为全球规则,中国通过DeepSeek验证的软硬协同路径,或将成为全球AI算力新范式。

DeepSeek让我们更加清晰地认识到,在智能时代,最关键的资源或许不是芯片,而是人的创造力。随着DeepSeek等先进模型的影响,硬件生态系统能否趋于统一和标准化,将是一个值得期待的问题。