英特尔于近日在其开发人员专区宣布,OpenVINO 2025.0版本已正式面世,这一里程碑式的更新标志着在性能提升、生成式AI模型支持以及对英特尔神经处理单元(NPU)的优化方面取得了显著进展。

据悉,OpenVINO 2025.0版本引入了对FLUX.1图像生成模型(包括Dev与Schnell版本)的官方支持,这意味着开发者可以在英特尔的CPU和GPU上,通过GenAI流水线运行这些模型。通过Optimum-Intel工具,开发者能够导出Flux模型,并结合Text2ImagePipeline功能,实现图像的生成。特别针对Flux模型对精度变化的高度敏感性,英特尔进行了深度优化,确保了图像生成的高性能与准确性。

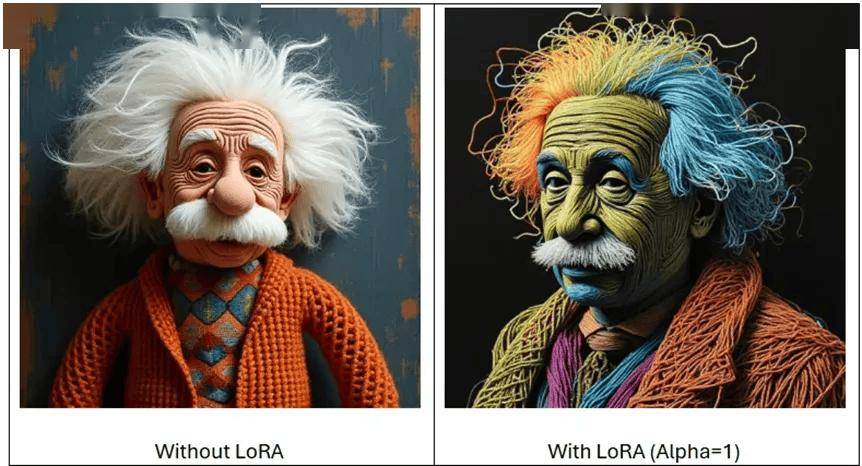

新版本还增添了Image2Image与Inpainting两大功能。Image2Image允许用户以图像和文本为输入,生成全新的、可控性更强的图像;而Inpainting则能够通过掩码图像,替换输入图像中的特定区域,实现局部内容的再生。这两种流水线均兼容LoRA适配器,为用户的定制化需求提供了更多可能性。

在LLMPipeline API方面,OpenVINO 2025.0版本也带来了创新。它引入了提示词查找解码的预览支持,这是对推测解码的一种简化。通过直接查找机制取代传统的草稿模型,这一功能在处理高相似性的请求时,能够显著减少生成延迟。例如,在问答场景中,答案将直接基于作为提示词一部分的文档生成,从而展现出明显的性能优势。

英特尔还透露,他们正在积极支持和验证最新的模型,包括Mistral-7B-Instruct-v0.2和Qwen2.5。同时,基于LLama和Qwen架构的DeepSeek蒸馏模型也得到了支持。这些举措无疑将进一步拓宽OpenVINO的应用领域和场景。

OpenVINO 2025.0版本首次实现了对NPU的加速支持。开发者现在可以通过PyTorch的torch.compile接口,轻松调用英特尔NPU的算力。此前,OpenVINO已在CPU和GPU上得到了广泛支持,并且其性能已经接近原生OpenVINO推理。这一新功能的启用方式也极为简便,为开发者提供了更多的选择和灵活性。