近期,科技界传来一项令人瞩目的新进展。据科技媒体marktechpost报道,加州大学伯克利分校的一支研究团队在人工智能领域取得了突破,他们开发了一种创新的训练方法,能够显著提升大语言模型(LLM)的推理能力,而这一过程仅需要少量的数据。

长久以来,提升LLM的推理能力一直是科研人员面临的重大挑战。传统上,为了训练模型生成具有结构化自反思、验证和回溯的长链式思维(CoT)响应,往往需要在庞大的数据集上进行长时间的微调,且许多专有模型的训练方法并不公开,这无疑增加了研究的难度。

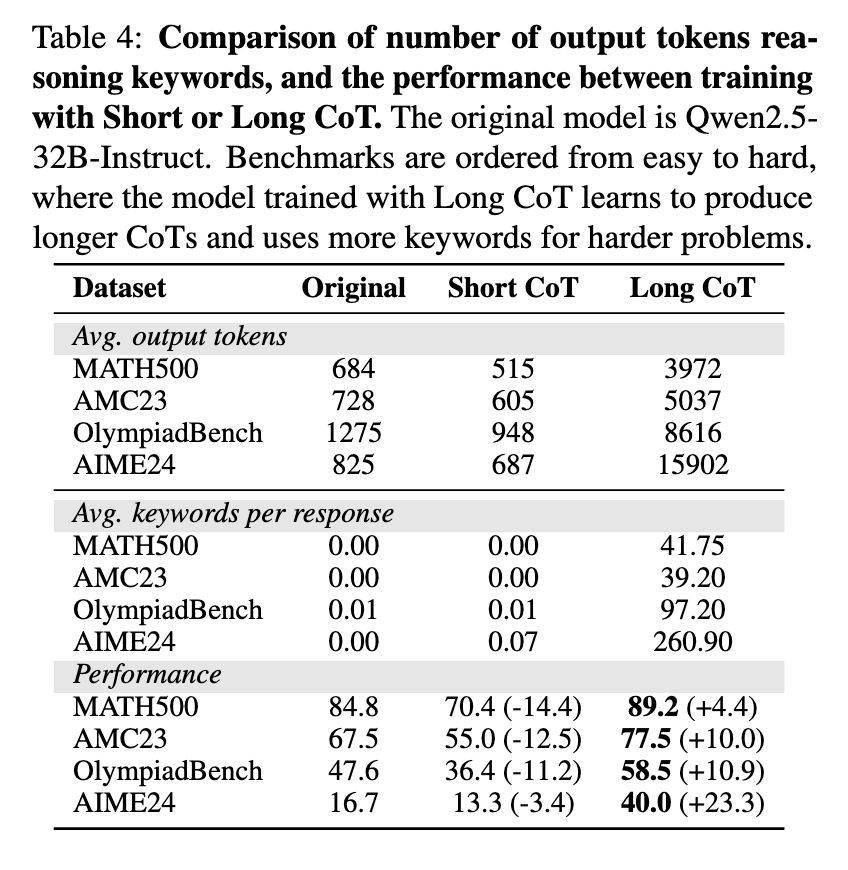

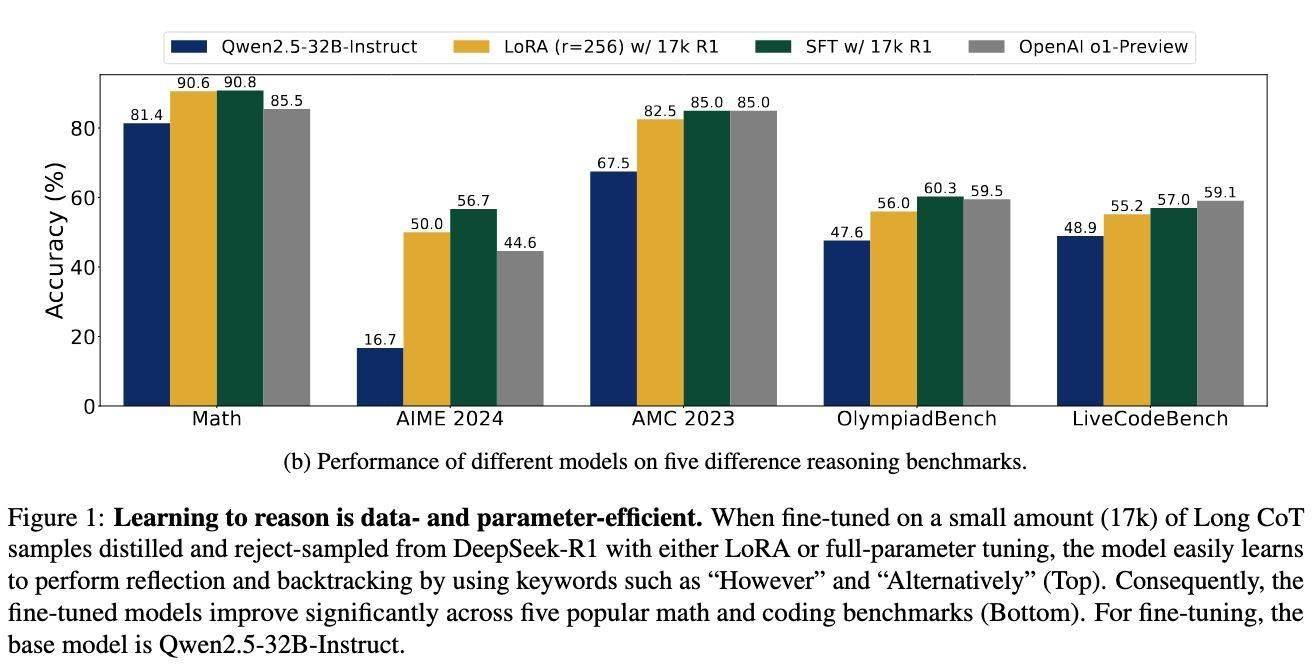

然而,这支研究团队却另辟蹊径,他们提出的新方法仅使用了17000个CoT示例,对Qwen2.5-32B-Instruct模型进行了微调,并结合了SFT和LoRA技术。这一方法的核心理念在于优化推理步骤的结构完整性,而非内容本身,通过改进逻辑一致性并减少不必要的计算开销,从而实现了LLM推理效率的显著提升。

研究表明,CoT的结构在增强LLM推理性能方面起着至关重要的作用。研究团队发现,改变训练数据的逻辑结构会显著影响模型的准确性,而单个推理步骤的修改则对整体影响较小。这一发现为进一步优化LLM的推理能力提供了重要的理论依据。

为了验证这一新方法的有效性,研究团队进行了多项测试。测试结果显示,在使用新方法后,LLM在多个基准测试上的表现均取得了显著提升。例如,在AIME 2024测试中,准确率从基线水平大幅提升至56.7%;在LiveCodeBench测试中,得分提高了8.1个百分点;在Math-500测试中,达到了90.8%的高准确率;在AMC 2023和OlympiadBench测试中,也分别取得了85.0%和60.3%的优异成绩。

这些令人瞩目的测试结果表明,这种高效的微调技术使得LLM在更少的数据需求下,能够达到与OpenAI的o1-preview等专有模型相媲美的推理能力。这一突破不仅为人工智能领域的研究开辟了新的道路,也为未来LLM在实际应用中的广泛推广奠定了坚实的基础。