近日,科技界再度掀起波澜,一项名为“DeepSeek”的新研究迅速抢占微博热搜头名,引发广泛关注。

这一热潮的源头,源自DeepSeek团队最新提交的一篇论文,而更令人瞩目的是,该项目的创始人梁文锋亲自参与撰写,并亲自提交了这篇研究成果。

论文题为《原生稀疏注意力:硬件对齐和原生可训练的稀疏注意力》,其核心内容直指当前大语言模型面临的计算成本挑战,特别是长上下文建模的高昂代价。面对这一难题,论文提出了一种创新的解决方案——NSA(Native Sparse Attention),即原生可训练的稀疏注意力机制。

NSA通过结合算法创新与硬件优化,旨在实现高效的长上下文建模。它采用了一种动态分层稀疏策略,巧妙地将粗粒度的token压缩与细粒度的token选择相结合,从而在保证上下文意识的同时,也确保了局部精度。这一策略不仅提高了效率,更在保持模型能力方面展现出了巨大潜力。

论文中,DeepSeek团队详细阐述了NSA的两项关键创新。首先,他们通过算术强度平衡算法设计,以及对现代硬件实现的优化,实现了显著的计算加速。这一创新不仅提升了计算效率,更为大规模模型的训练和应用提供了有力支持。其次,NSA启用了端到端训练,这一举措使得在不牺牲模型性能的前提下,大幅减少了训练前的计算量。

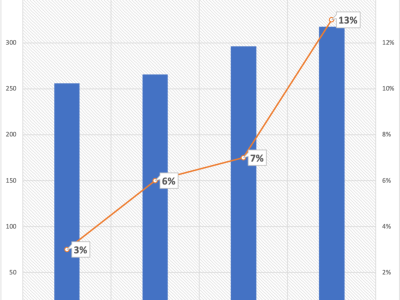

实验结果显示,采用NSA预训练的模型在多个基准测试中表现优异,不仅保持了与全注意力模型相当的性能,甚至在长上下文任务和基于指令的推理中超越了后者。更令人振奋的是,NSA在解码、向前传播和向后传播过程中,对于64k长度序列的处理速度实现了对全注意力的大幅超越,这充分验证了其在整个模型生命周期中的高效性。