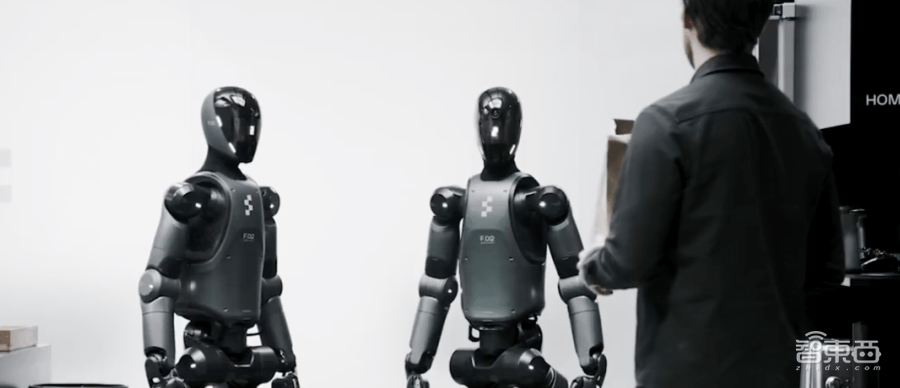

近日,美国机器人领域的创新企业Figure AI发布了一项重大突破:一款名为Helix的通用型视觉语言动作(VLA)模型。这款模型首次实现了对人形机器人完整上半身的高速连续控制,将感知、语言理解与学习控制完美融合。

Helix模型的问世,标志着人形机器人在操作灵活性上迈出了重要一步。用户只需发出简单的自然语言指令,无需任何事先演示或定制编程,机器人便能轻松抓取几乎所有家庭小物件,即便是那些训练时从未接触过的物品也不在话下。这一能力得益于Helix模型强大的物体泛化能力。

Figure AI强调,Helix模型创造了多项业界首次成就。它首次实现了对仿人机器人完整上半身的高速连续控制,包括手腕、躯干、头部及每根手指的灵活操控。在测试中,机器人成功处理了数千件杂乱无章的新物品,从玻璃器皿、玩具到工具和衣服,均无需事先演示或编程。

更令人惊叹的是,Helix模型还具备多机器人协作能力。在测试中,两台机器人能够协同完成长期复杂任务,共同处理从未见过的物品,如合作整理陌生杂货。这种能力为机器人在家庭环境中的实际应用提供了更多可能性。

Helix模型还展现了出色的场景理解与语义解析能力。当提示“捡起沙漠物品”时,机器人不仅能够识别出玩具仙人掌符合这一抽象概念,还能选择最近的手并执行精确的抓取动作。这种从语言到动作的通用抓取功能,为非结构化环境中部署人形机器人提供了更大的便利。

Helix模型之所以能够实现这些突破,得益于其开创性的双系统架构。该架构由系统1和系统2组成,分别负责高速精准控制和场景理解与语义解析。系统2基于7B参数的开源VLM,以7-9Hz频率运行,确保跨物体、跨场景的泛化能力。而系统1则是一个80M参数的视觉运动策略模型,以200Hz频率将系统2的语义表征转化为连续动作指令,实现毫秒级实时响应。这种解耦架构使得两个系统能够各司其职,共同实现高效的人形机器人控制。

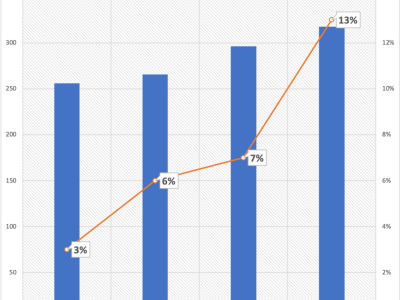

Helix模型在训练过程中使用了极少的资源。团队仅使用了约500小时的高质量监督数据,便实现了强大的物体泛化能力。这些数据仅占先前收集的视觉语言动作(VLA)数据集规模的5%不到,且无需依赖多机器人实体收集或多阶段训练。这一成果不仅展示了Helix模型的高效性,也为未来人形机器人的发展提供了更多可能性。