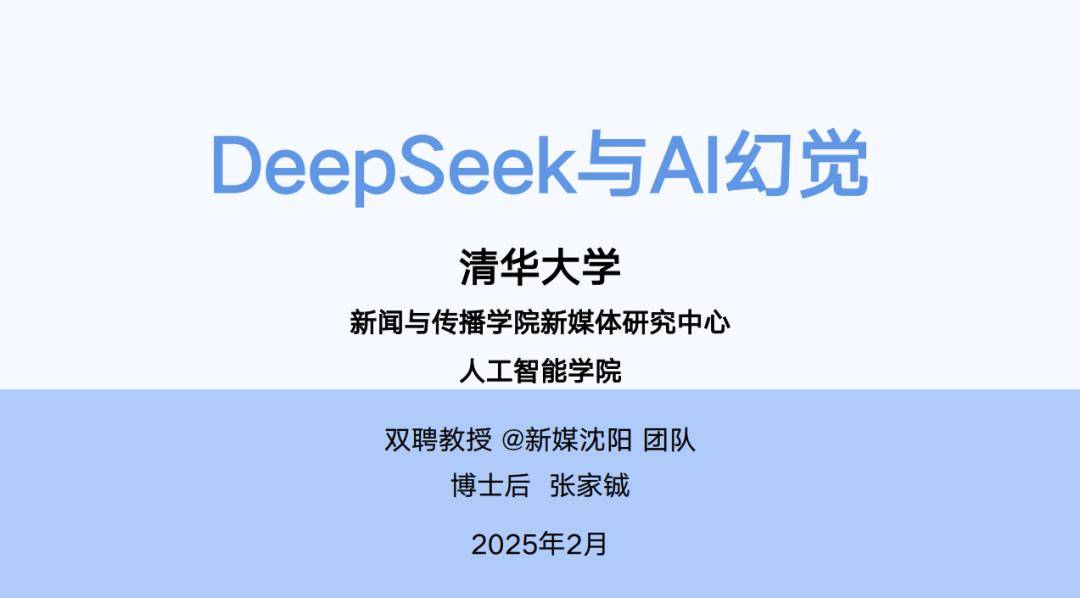

近日,清华大学沈阳团队的新作《DeepSeek攻略》再度引起广泛关注,本次攻略深度探讨了AI领域的一个独特现象——AI幻觉。

许多用户在体验DeepSeek等大语言模型时,或许都曾遭遇过看似言之凿凿,实则与事实大相径庭的回答。这些回答,正是AI幻觉的一种体现。

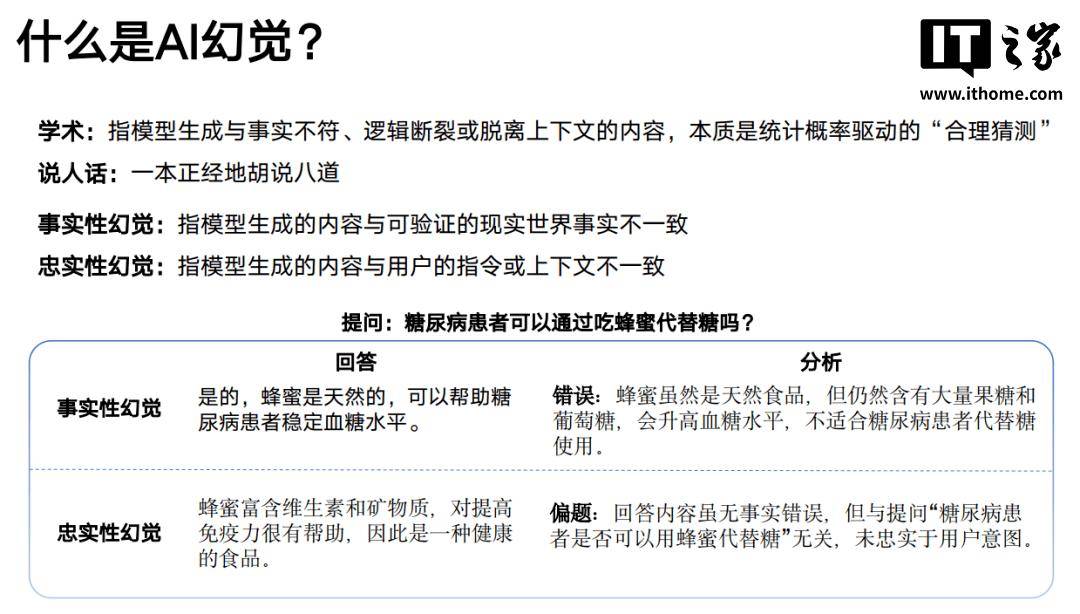

在《DeepSeek攻略》的第五部分中,详细解析了AI幻觉这一概念。AI幻觉,简而言之,即模型生成的内容与实际情况不符,逻辑断裂或脱离上下文。这些“不合理”的输出,其实是统计概率驱动下的“合理猜测”。

AI幻觉主要分为两类:事实性幻觉与忠实性幻觉。前者指的是模型生成的内容与可验证的现实世界事实不一致;后者则是模型生成的内容与用户的指令或上下文存在偏差。

那么,为何会产生AI幻觉呢?原因主要有以下几点:数据偏差导致模型放大了训练数据中的错误或片面性;泛化困境使得模型难以处理训练集外的复杂场景;知识固化让模型过度依赖参数化记忆,缺乏动态更新能力;意图误解则在用户提问模糊时,让模型容易“自由发挥”。

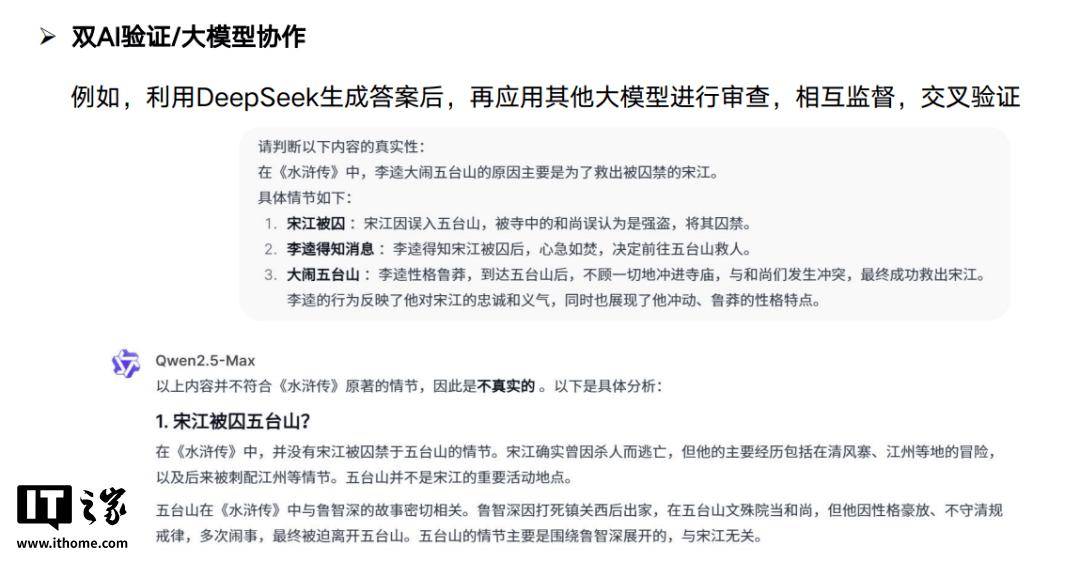

为了减缓AI幻觉的影响,作为普通用户,我们可以采取一些措施。例如,开启联网搜索功能,让AI对齐信息颗粒度,减少“胡说八道”的几率。在编写提示词时,提前做好知识边界的限定,降低模型虚构的可能性。使用多款AI模型进行交叉验证,也是一个有效的方法。

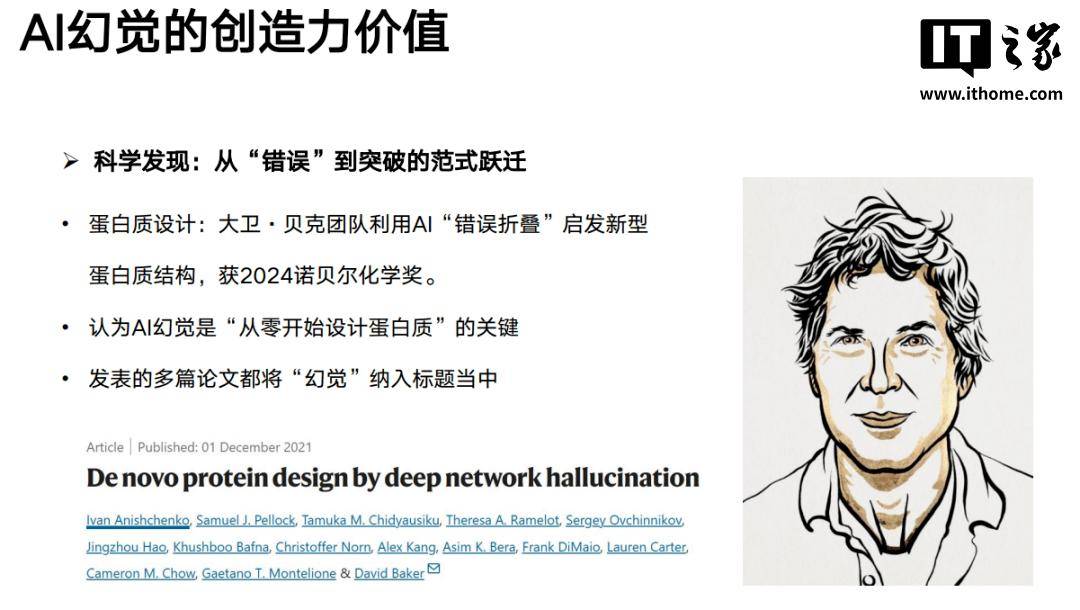

尽管AI幻觉在现阶段仍无法完全杜绝,但它在某些领域却具有创造力价值。对于需要创新思维的领域,AI幻觉或许能激发新的灵感。当然,要让AI幻觉的“想象力”为我们所用,还需要逐步建立方法论,并经过合理的验证过程。

本次分享的《DeepSeek攻略》PDF版本为原汁原味的原版,避免了网上众多被魔改、内置广告的版本,为读者提供了更加纯净的阅读体验。