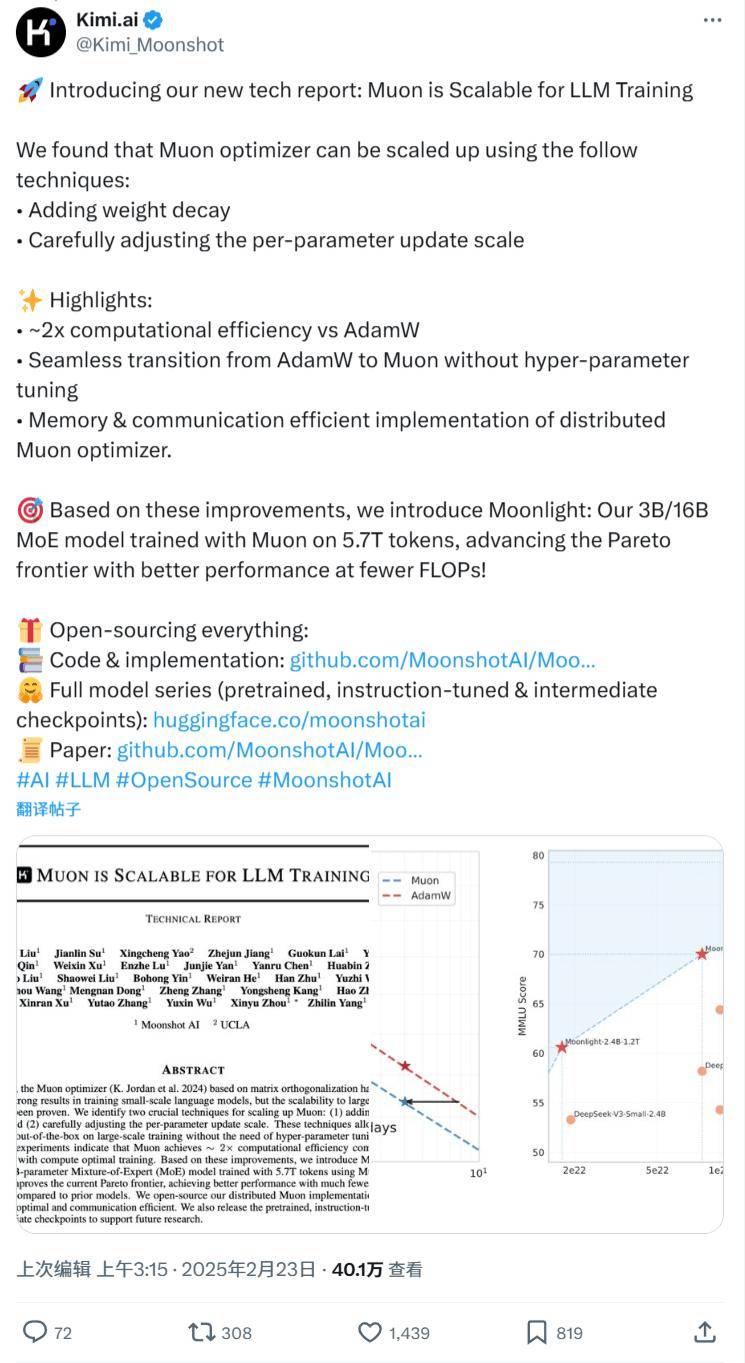

近期,人工智能领域迎来了一项引人注目的技术创新。知名技术团队月之暗面Kimi发布了一项关于Muon优化器的新技术报告,并随之推出了名为“Moonlight”的混合专家模型(MoE)。这款模型在Muon优化器的基础上进行了训练,拥有30亿至160亿不等的参数规模。

Moonlight模型在训练过程中采用了5.7万亿个token的数据量,并且在减少浮点运算次数(FLOPs)的同时,实现了卓越的性能表现。这一成果不仅提升了帕累托效率边界,更为大规模的语言模型训练提供了新的思路。

月之暗面团队表示,Muon优化器通过引入权重衰减和精细调整每个参数更新幅度的技术,实现了在大规模训练中的高效应用。这些创新技术使得Muon优化器无需繁琐的超参数调优,即可直接应用于实际训练任务。

据团队介绍,在扩展法则实验中,Muon优化器相较于计算最优训练的AdamW优化器,实现了约2倍的计算效率提升。这一显著优势使得Muon优化器在处理大规模数据集时更加得心应手。

本次发布的Moonlight模型采用了名为Moonlight-16B-A3B的具体配置,总参数量达到15.29B,其中激活参数为2.24B。在5.7T token的训练数据支持下,Moonlight模型展现出了卓越的性能表现,不仅突破了当前的Pareto前沿,还在大幅减少FLOPs的情况下实现了比以往模型更优的性能。

为了方便其他研究人员和开发者利用这一创新成果,月之暗面团队还开源了一个分布式版本的Muon实现。该实现在内存使用和通信效率上都进行了优化,旨在提高整体性能和易用性。团队还发布了预训练模型、经过指令调优的模型以及中间训练检查点,为未来的研究工作提供了有力支持。

对于对这项技术感兴趣的研究人员和开发者来说,可以通过访问GitHub和Hugging Face平台,获取更多关于Moonlight模型和Muon优化器的详细信息。