在科技探索的征途中,雷科技再次迈出了创新的一步,这次他们将目光聚焦在了手机本地部署AI大模型的尝试上。此前,雷科技已成功在无独显的笔记本电脑上,仅凭CPU和内存成功运行了一个7B参数量的Qwen蒸馏模型,但这一尝试的实际意义相对有限。于是,他们开始思考,如果将这样的AI模型部署到手机上,是否能够开启全新的应用场景?

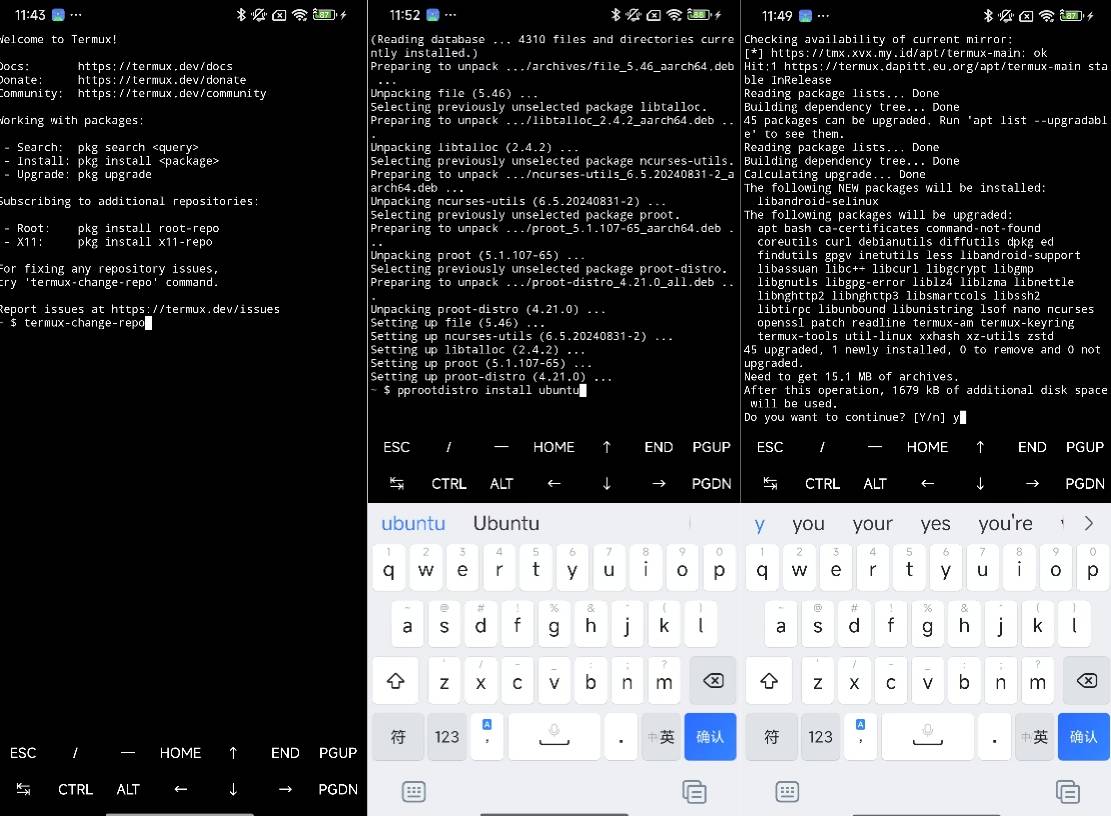

为了实现这一目标,雷科技首先对手机本地部署AI的可行性进行了深入探索。他们在网上查阅了多种相关教程,并亲自测试了其中的几种方法。其中,一个通过Termux应用模拟Linux终端来部署Ollama,再运行DeepSeek模型的方案引起了他们的注意。然而,实际操作中,他们发现教程中的服务器存在问题,无法顺利访问清华大学镜像文件源,导致部署过程困难重重。尽管经过数小时的尝试,他们还是未能成功完成安装。

面对挑战,雷科技并未放弃,他们转而寻找其他可行的部署方案。幸运的是,GitHub上丰富的开源资源为他们提供了新的思路。他们测试了三款本地AI部署应用:ChatterUI、PocketPal和MNN大模型。这三款应用各有千秋,能够满足不同用户的需求。

在ChatterUI中,用户可以直接加载本地AI模型,并通过在线下载方式远程加载模型。这款应用还支持TTS(语音输出)功能,结合语音输入,可以解锁更多使用场景。安装完成后,用户只需简单设置即可轻松部署AI模型。而PocketPal则更加简洁,虽然不支持TTS功能,但同样支持加载本地AI模型,并提供了一些小参数的AI模型快速下载通道。

对于不太擅长技术操作的用户来说,MNN大模型则是一个更为友好的选择。这款由阿里开发的开源应用整合了多个在手机等小型移动设备上运行效果良好的AI模型,用户可以根据需要直接点击下载。下载完成后,点击即可加载使用,全程操作简便。

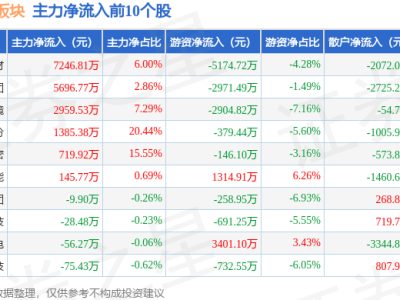

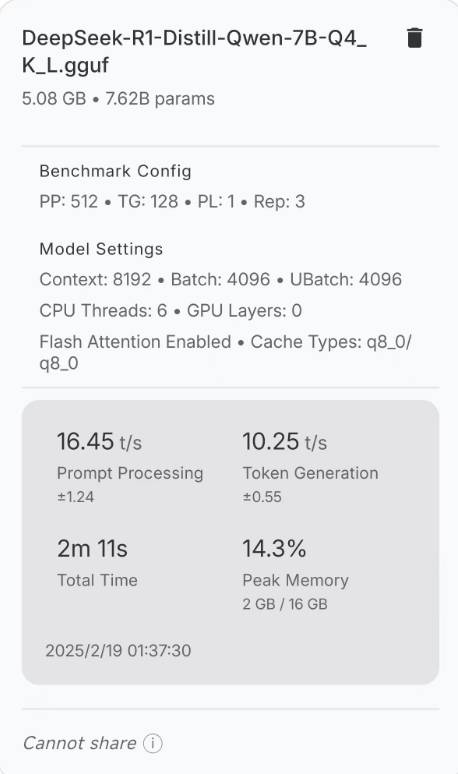

在成功部署AI模型后,雷科技开始了体验环节。他们下载了1.5B版本的DeepSeek-R1模型进行测试。虽然这个版本的模型在回答一些复杂问题时显得有些力不从心,但在骁龙8至尊版+16G运存的手机上,AI推理和生成速度都非常不错,已经能够满足日常问答和使用的需求。

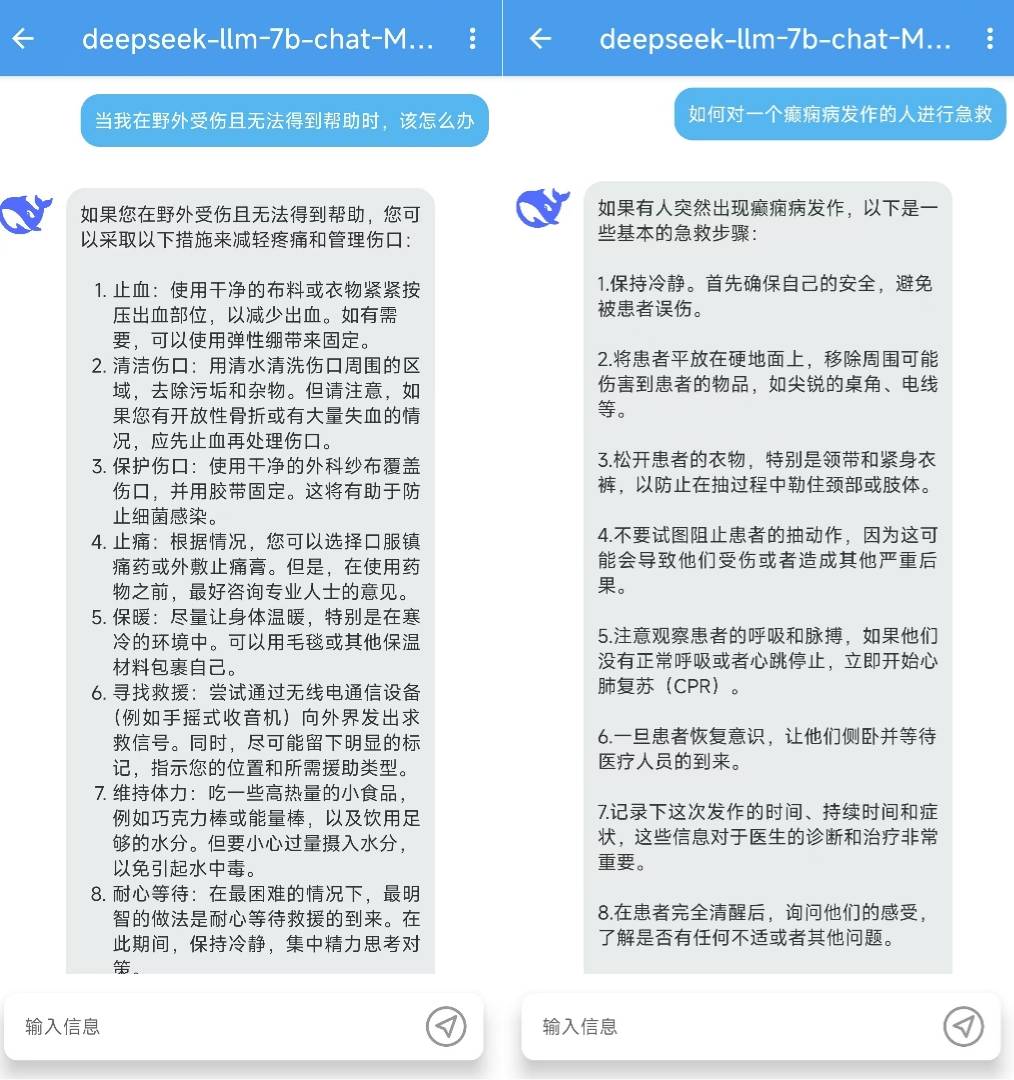

在后续测试中,7B版本的DeepSeek模型表现更加出色。它不仅能够正确回答用户的问题,还能在离线状态下提供一些紧急情况下的基础建议。例如,在遇到癫痫症发作的病人时,AI能够给出正确的急救方法;在野外受伤无人帮助时,也能提供自救建议。

雷科技认为,在手机上部署AI大模型具有实际意义。虽然电脑上的部署可能显得多余,但手机上的离线AI却能在关键时刻发挥作用。它可以在用户无网且需要帮助时提供最基础的建议,成为用户的得力助手。同时,这也为隐私保护意识较强的用户提供了另一种选择,他们可以在自己的设备上部署专属AI模型,确保数据安全和隐私保护。

在对比了三款本地AI部署应用后,雷科技给出了他们的建议。对于追求稳定可用的用户来说,MNN是最好的选择;而对于有一定AI基础和编程基础的用户来说,ChatterUI和PocketPal则提供了更多功能和灵活性。无论选择哪款应用,用户都能享受到手机本地部署AI带来的便利和乐趣。