DeepSeek公司近期宣布,其备受瞩目的“开源周”活动已正式启动,首个对外开放的代码库被命名为FlashMLA。据内部消息透露,此次活动期间,DeepSeek计划总计开源五个重要的代码库。

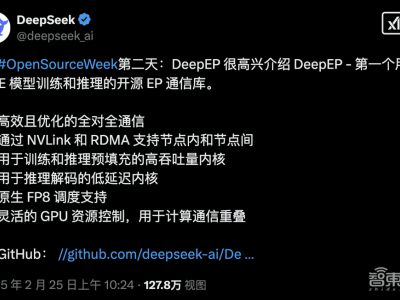

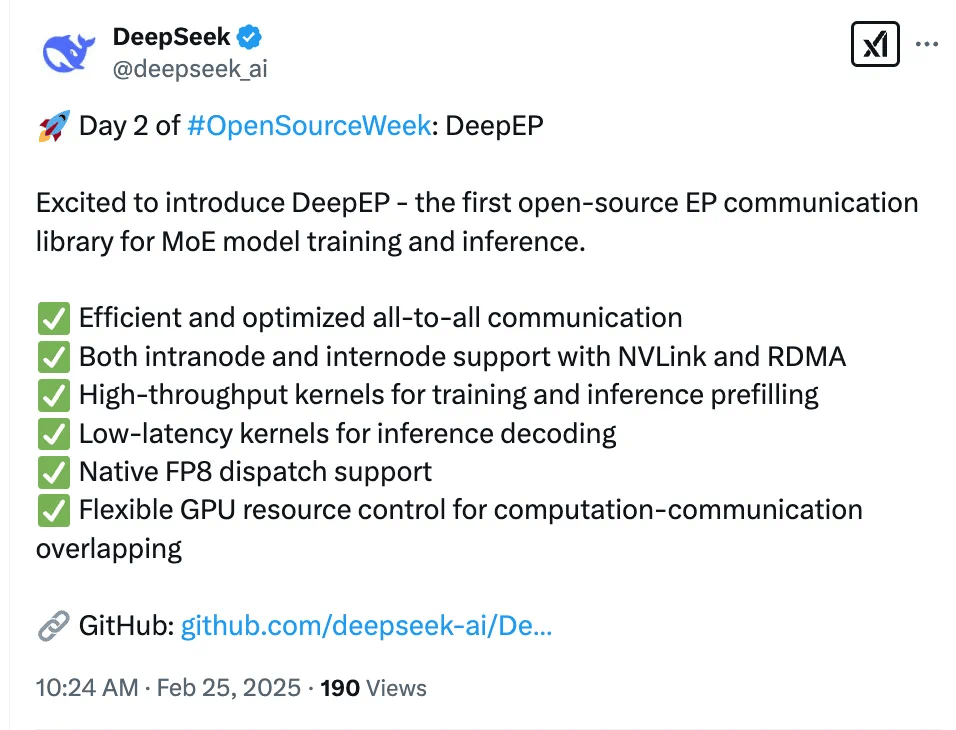

紧接着首个开源项目的发布,DeepSeek再度传来喜讯,正式推出了第二个开源项目——专为MoE模型(混合专家模型)的训练与推理设计的EP通信库DeepEP。这一举措标志着DeepSeek在推动人工智能领域开源生态发展的道路上迈出了坚实的一步。

DeepEP通信库以其卓越的性能和多功能性脱颖而出,它具备以下几大亮点:

首先,DeepEP实现了高效优化的All-to-All通信机制,这一特性显著提升了模型在分布式训练环境下的数据传输效率。其次,该库全面支持NVLink和RDMA技术,无论是节点内部还是跨节点的通信,都能实现低延迟、高带宽的数据传输。DeepEP在训练和推理的预填充阶段,提供了高吞吐量的计算核心,确保了模型处理的快速响应。

在推理解码阶段,DeepEP则采用了低延迟的计算核心,进一步优化了模型在实际应用中的表现。该库原生支持FP8数据分发,这一特性使得模型在处理高精度数据时能够更加高效。同时,DeepEP还提供了灵活的GPU资源管理功能,使得计算与通信任务能够高效重叠,进一步提升了整体性能。

DeepSeek此次开源的DeepEP通信库,无疑为人工智能领域的研究者和开发者提供了一个强大的工具,不仅有助于推动MoE模型的发展,也为整个行业的创新注入了新的活力。