阿里云近日宣布了一项重大举措,正式开源其视觉生成基座模型——万相2.1(Wan)。此次开源行动采用了极为宽松的Apache2.0协议,意味着全球开发者将能够无限制地访问和使用这一前沿技术。

万相2.1模型包含14B和1.3B两种参数规格,阿里云不仅开放了全部推理代码,还提供了相应的权重文件。这一举措极大地方便了开发者进行文生视频和图生视频等任务的探索。开发者可以在Github、HuggingFace和魔搭社区等多个平台上轻松下载并体验这一模型。

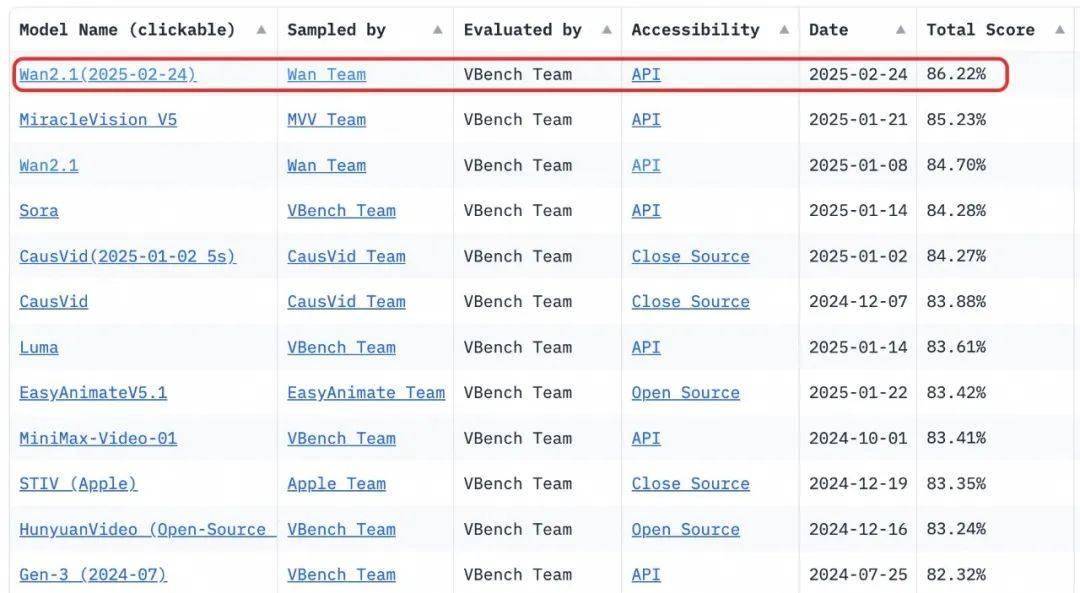

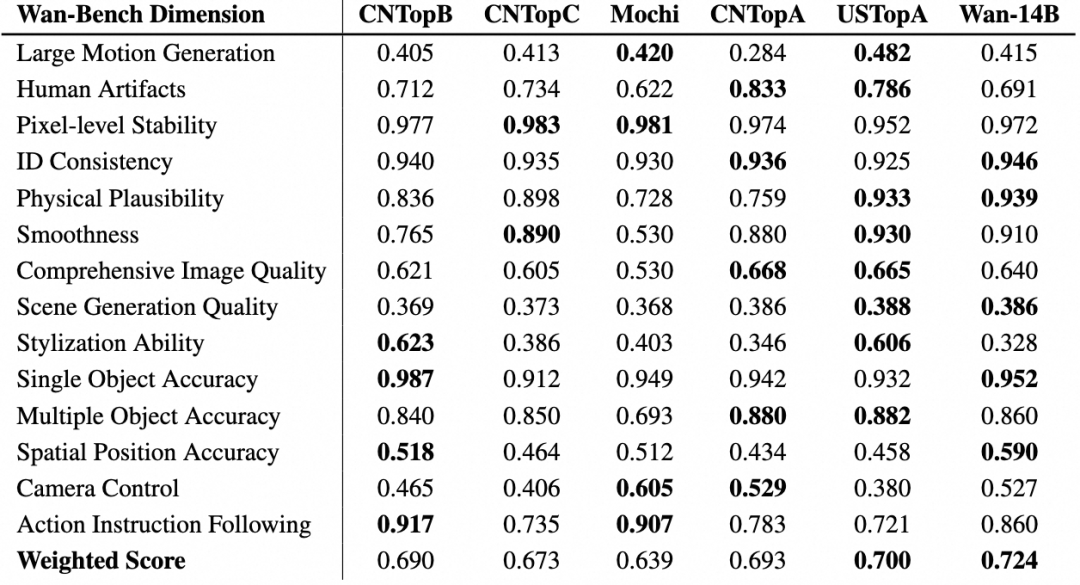

据悉,14B参数的万相模型在指令遵循、复杂运动生成、物理建模以及文字视频生成等多个领域均展现出了卓越的性能。在评测集VBench中,万相2.1以86.22%的总分力压群雄,包括Sora、Luma、Pika等国内外知名模型,成功登顶。而1.3B版本的测试结果同样令人瞩目,它不仅超越了更大尺寸的开源模型,还逼近了部分闭源模型的表现。尤为该版本能够在消费级显卡上流畅运行,仅需8.2GB显存即可生成480P视频,这对于二次模型开发和学术研究来说无疑是一个巨大的福音。

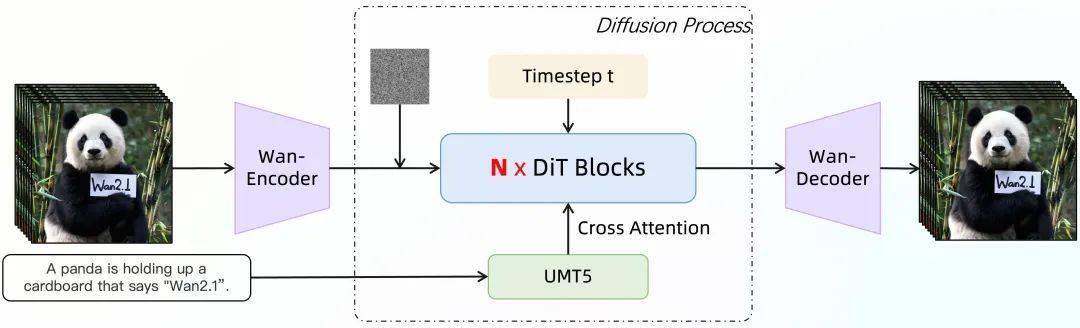

万相视频模型采用了先进的DiT架构和线性噪声轨迹Flow Matching范式,并在此基础上研发了高效的因果3D VAE和可扩展的预训练策略等创新技术。特别是在3D VAE方面,万相团队通过实现特征缓存机制,成功支持了任意长度视频的编码和解码,实现了对无限长1080P视频的高效处理。通过将空间降采样压缩提前,万相模型在不损失性能的前提下,进一步减少了29%的推理时内存占用,从而提升了整体运行效率。

在多个维度的测试中,万相模型均展现出了业界领先的表现。特别是在运动质量、视觉质量、风格和多目标等14个主要维度以及26个子维度的测试中,万相模型斩获了5项第一,充分证明了其强大的技术实力和广泛的应用潜力。

对于想要深入了解和使用万相模型的开发者来说,以下是一些开源地址的链接:

Github:https://github.com/Wan-Video

HuggingFace:https://huggingface.co/Wan-AI

魔搭社区:https://modelscope.cn/organization/Wan-AI