近日,三言科技从阿里云方面获悉,其研发的视频生成大模型——万相2.1(Wan)已正式宣布开源。此次开源遵循Apache2.0协议,涵盖了14B和1.3B两种参数规格的全部推理代码及权重,为全球开发者提供了强大的视频生成工具。

开发者们现在可以在Github、HuggingFace以及魔搭社区等平台上下载并体验这一前沿技术。万相2.1不仅支持文字生成视频的功能,还能实现图片生成视频的任务,极大地拓宽了视频创作的边界。

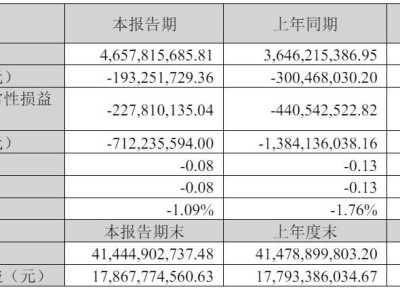

在万相2.1的两个开源版本中,14B版本展现出了卓越的性能。它在指令遵循、复杂运动生成、物理建模以及文字视频生成等多个方面均表现出色。在权威评测集Vbench中,万相2.1以86.22%的总分,遥遥领先于国内外的Sora、Luma、Pika等模型,稳居评测榜首。

而1.3B版本的万相模型同样不容小觑。尽管其参数规模较小,但性能却超越了部分更大尺寸的开源模型,甚至与一些闭源模型的结果相近。更为重要的是,这一版本的模型对硬件要求较低,能够在消费级显卡上流畅运行。仅需8.2GB的显存,就能生成480P的视频,这为二次模型开发和学术研究提供了极大的便利。