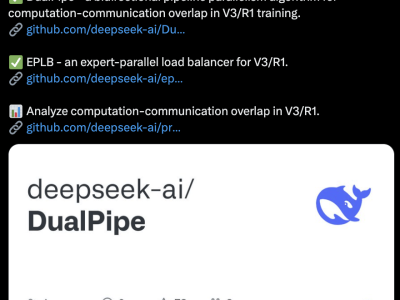

近日,科技界迎来一大盛事,DeepSeek宣布其“开源周”活动正式启动,并震撼发布了首个代码库FlashMLA,这一举动迅速吸引了全球范围内的广泛关注与讨论。

FlashMLA,作为专为英伟达Hopper GPU量身定制的高效MLA解码内核,其独特之处在于针对可变长度序列进行了深度优化。作为DeepSeek算力高效利用的核心组件,FlashMLA通过创新的MLA解码优化技术和分页KV缓存策略,实现了硬件利用率的显著提升,极大加速了大型语言模型的解码流程。这一技术突破,无疑为各类实时对话生成场景带来了前所未有的响应速度和吞吐量提升。

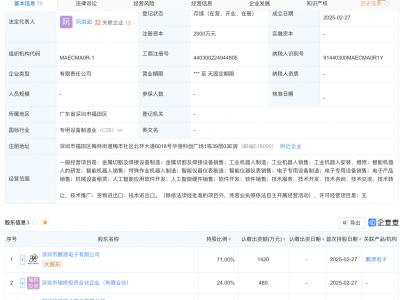

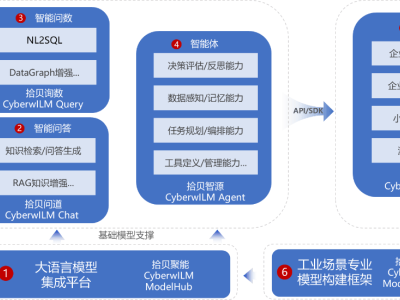

云天励飞芯片团队在FlashMLA开源后迅速响应,成功完成了DeepEdge10平台与FlashMLA的适配工作。在适配过程中,团队不仅运用了Op fusion tiling、Online softmax、Double buffer等前沿技术,还依托自研的Triton-like编程语言,高效开发了针对FlashMLA的专用算子。这些优化措施不仅大幅提高了计算效率,还有效降低了显存占用,充分彰显了DeepEdge10平台“算力积木”芯片架构的灵活性与高效性,同时也证明了其与DeepSeek生态的完美融合。

为了进一步推动开源AI的发展,云天励飞已将相关适配代码贡献给了开源平台Gitee,为开源社区注入了新的技术活力。

DeepEdge10系列芯片,作为专为应对大模型时代挑战而设计的芯片产品,其支持范围广泛,涵盖了Transformer模型、BEV模型、CV大模型、LLM大模型等多种主流模型架构。依托自主可控的国产先进工艺和独特的“算力积木”架构,DeepEdge10能够灵活适应智慧城市、智慧交通、智能制造、智慧仓储、机器人、边缘智算中心等多个领域的算力需求,为大型模型的推理提供了强大的算力支持。