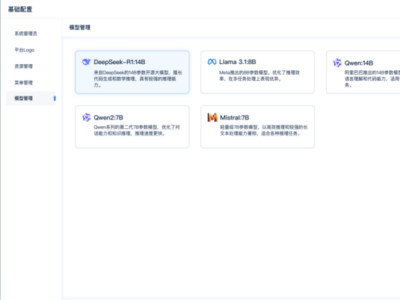

DeepSeek开源周系列活动近日迎来了第四波高潮,此次发布的焦点集中在三项针对并行计算的优化策略上。这些策略通过GitHub平台向公众详细揭示了DeepSeek-V3和R1模型背后的技术细节,展示了团队如何通过精细的计算和通信优化,最大化利用GPU的性能。

其中,DualPipe技术尤为引人注目。这是一项专为V3/R1模型训练设计的双向流水线并行算法,旨在实现计算与通信阶段的完美重叠。通过减少“流水线气泡”,即设备空闲等待的时间,DualPipe显著提升了训练效率。值得注意的是,该技术的开发团队中包括DeepSeek的创始人梁文锋。

第二项优化策略是EPLB(Expert Parallelism Load Balancer),专注于解决MoE(混合专家)模型在分布式训练和推理中的负载不平衡问题。在MoE模型中,不同的专家被分配到不同的GPU上,而EPLB通过采用冗余专家策略,确保不同GPU之间的负载保持平衡,从而提高了整体训练效率。

DeepSeek还分享了来自训练和推理框架的性能分析数据,这些数据通过PyTorch Profiler采集,并可在Chrome或Edge浏览器中可视化分析。这些分析数据不仅揭示了通信计算重叠策略的有效性,还提供了低级实现细节,有助于社区更好地理解并应用这些优化技术。

DeepSeek此次发布的优化策略,被视为对AI基础设施层的一次深入探索。OpenCSG(开放传神)创始人陈冉对此表示,DeepSeek过去更像是直接展示了一辆续航900公里的车,而现在则是在深入剖析如何达到这一续航能力的技术细节。这些“脚手架”的开源,无疑为未来的生态搭建奠定了坚实基础。

陈冉还指出,DeepSeek的代码开源可能对AI基础设施层的从业者产生深远影响。一方面,它可能促使从业者寻找新的研究方向;另一方面,如果利用好这些开源内容,也可能带来显著利益,否则就可能面临竞争压力。

在DeepSeek开源周的前三天,团队已经陆续发布了多项重要成果,包括让大模型在GPU上运行更快的MLA解码核FlashMLA、用于MoE模型训练和推理的DeepEP通信库,以及支持MoE的FP8 GEMM代码库DeepGEMM。这些项目在GitHub上获得了广泛关注和好评,FlashMLA的星标数已超过1万,DeepEP和DeepGEMM也分别获得了6000和3700以上的星标。

DeepSeek还宣布了一项API错峰优惠政策,鼓励用户在夜间空闲时段使用其服务。自2月26日起,在北京时间每日00:30至08:30期间,DeepSeek-V3的API调用价格降至原价的一半,而DeepSeek-R1的调用价格更是低至原价的25%。这一政策旨在让用户享受更经济、更流畅的服务体验。

有消息称,DeepSeek正加速推进R2模型的发布计划,以巩固其在AI领域的优势地位。尽管DeepSeek尚未对此作出正式回应,但业界普遍认为,DeepSeek-R2的发布将成为AI行业的一个重要里程碑。