在DeepSeek开源周的精彩延续中,摩尔线程于近日宣布了一项重大进展——成功集成并开源了针对DeepSeek通信库DeepEP与并行算法DualPipe的支持。这一成果标志着摩尔线程在推动大模型训练与推理效率方面迈出了坚实的一步,相关开源代码仓库MT-DeepEP与MT-DualPipe也随之亮相。

DeepEP,这一专为混合专家(MoE)模型设计的开源通信库,通过优化通信信道的使用,显著提升了大模型训练的效率,特别是在集群训练中展现出卓越性能。摩尔线程凭借MUSA Compute Capability 3.1全功能GPU的强大实力,成功适配了DeepEP,并引入了一系列创新特性,包括高效优化的All-to-All通信机制、MTLink + GPU节点内通信支持、高吞吐量与低延迟计算核心的灵活切换、原生FP8数据分发能力,以及GPU资源的灵活调度,实现了计算与通信的高效协同。

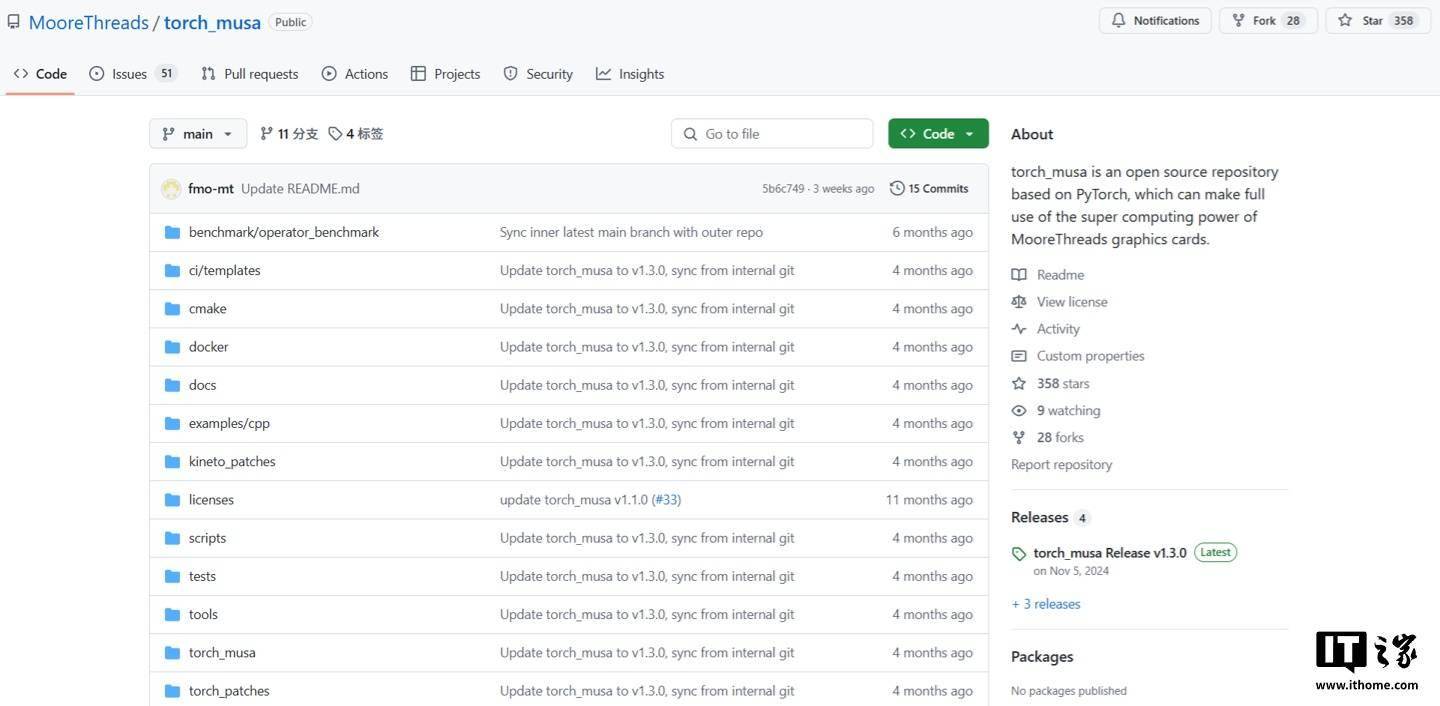

另一方面,DualPipe作为DeepSeek-V3的核心算法,通过实现前向与后向计算阶段计算与通信的完全重叠,有效减少了“流水线气泡”,即设备空闲等待时间,从而进一步提升了训练效率。摩尔线程依托其深度学习框架Torch-MUSA(已开源)及MUSA软件栈的全面兼容性,成功实现了对DualPipe算法的支持。目前,MT-DualPipe已无缝接入摩尔线程的MT-Megatron与MT-TransformerEngine框架(后者即将开源),能够完整复现DeepSeek V3的训练流程。

值得注意的是,MT-DualPipe与MT-Megatron的结合,不仅实现了DeepSeek V3模型中MLP-FFN与DW-DG的分离,进一步降低了气泡占比,还优化了通信效率。同时,MT-DualPipe与MT-TransformerEngine及MT-DeepEP的协同工作,借助MT-DeepEP的异步通信引擎,实现了更高效的通信掩盖,有效降低了对计算资源的损耗。这一系列创新技术的融合,无疑为摩尔线程在大模型训练与推理领域的发展注入了强劲动力。

对于有志于探索大模型训练与推理技术的开发者而言,摩尔线程的开源成果无疑提供了一套强大的工具集。Torch-MUSA开源地址的公布,更是为开发者们打开了一扇通往高效深度学习实践的大门。