近期,耶鲁大学携手剑桥大学及达特茅斯学院,在医疗人工智能领域取得了突破性进展,联合发布了一款名为MindLLM的创新工具。这款AI工具能够将复杂的脑部功能性磁共振成像(fMRI)数据转化为清晰可读的文字信息,其性能在多项基准测试中超越了现有的UMBRAE、BrainChat和UniBrain等技术。

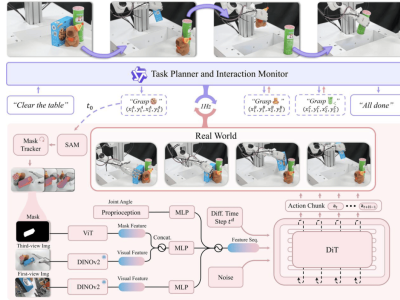

MindLLM的核心架构融合了fMRI编码器与大型语言模型,具备强大的数据分析能力。它通过解析fMRI扫描中的立体像素(Voxels),深入解读脑部活动模式。该工具的fMRI编码器采用了先进的神经科学注意力机制,能够灵活适应多样化的输入信号形态,从而高效完成多种分析任务。

为了进一步提升MindLLM的性能,研究团队引入了创新的脑部指令调优(BIT)方法。这一方法显著增强了模型从fMRI信号中提取丰富语义信息的能力,使其能够胜任图像描述、问答推理等多种解码任务,展现出广泛的应用潜力。

在严格的基准测试中,MindLLM展现出了卓越的表现。在文字解码、跨个体泛化以及新任务适应性等方面,相较于业界现有模型,其性能提升幅度分别高达12.0%、16.4%和25.0%。这一结果表明,MindLLM在适应新受试者以及处理未知语言推理任务时,均展现出了优于传统模型的显著优势。

尽管目前MindLLM仅能分析静态图像信号,但研究人员对其未来发展前景充满信心。他们表示,通过持续的改进和优化,MindLLM有望发展成为实时fMRI解码器,并在神经控制、脑机接口以及认知神经科学等领域发挥重要作用。这一创新技术有望为神经假肢修复感知能力、精神状态监控以及脑机交互等应用带来革命性的突破。