腾讯混元近期在图生视频技术领域取得了新突破,正式推出了全新的图生视频模型,并向公众开放源代码。与此同时,一系列创意玩法如对口型与动作驱动等也随之亮相,为用户提供了生成背景音效及2K高清视频的便捷工具。

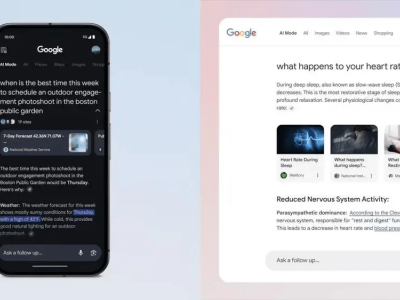

该技术的核心在于,用户仅需上传一张静态图片,并简单描述期望的画面动态和镜头变化,混元便能根据指令将图片转化为生动的5秒短视频,并自动匹配背景音效,使图片焕发新生。

更令人惊叹的是,用户只需上传人物图片,并输入希望角色“对口型”的文字或音频,图片中的人物便能仿佛被赋予生命,开始“说话”或“唱歌”。通过“动作驱动”功能,用户还能一键生成与指定舞蹈同步的视频,极大地丰富了创作的可能性。

目前,这些创新功能已通过混元AI视频官网向广大用户开放体验。对于企业和开发者而言,他们还可以在腾讯云平台上申请使用API接口,将这项技术融入自己的产品或服务中。

腾讯混元方面表示,此次开源的图生视频模型是其在文生视频模型开源工作上的进一步拓展。该模型拥有130亿参数,具备广泛的适用性,能够应对多种角色和场景的视频生成需求,无论是写实风格的视频制作,还是动漫或CGI角色的创作,都能游刃有余。

开源内容涵盖了模型的权重、推理代码以及LoRA训练代码,为开发者提供了基于混元训练专属LoRA等衍生模型的强大支持。现在,开发者可以在Github、HuggingFace等主流社区轻松下载并体验这一前沿技术。

随着腾讯混元图生视频模型的开源,这一技术有望激发更多创意灵感,推动视频创作领域的革新与发展。

腾讯混元还计划在未来持续推出更多创新功能和技术升级,为用户和开发者带来更加丰富多样的视频创作体验。