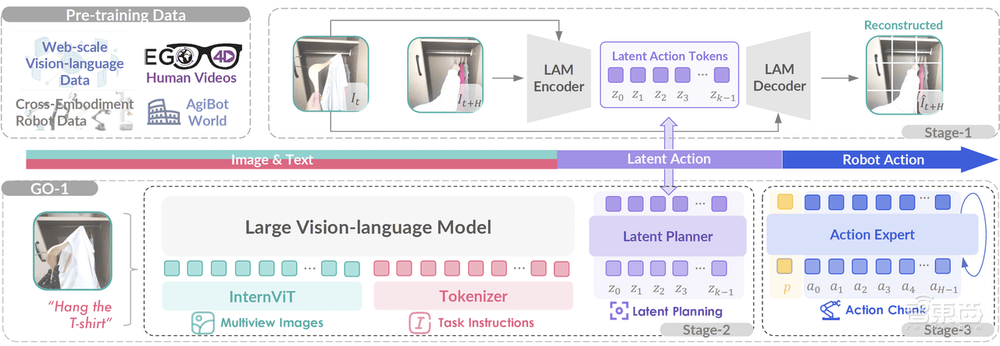

在机器人技术的前沿探索中,一款名为智元启元大模型Genie Operator-1(简称GO-1)的通用具身基座模型横空出世,由智元机器人公司于近日正式发布。这款模型以其创新的Vision-Language-Latent-Action(ViLLA)框架,为机器人智能开启了新的篇章。

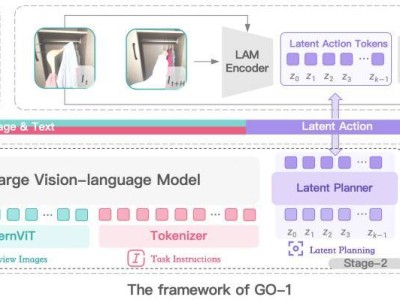

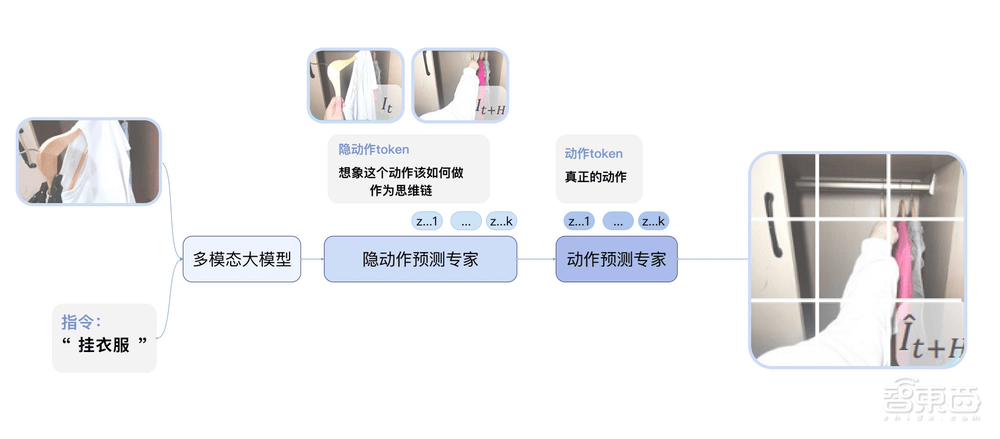

GO-1的核心在于其独特的ViLLA框架,该框架巧妙融合了VLM(多模态大模型)与MoE(混合专家)技术。VLM作为主干网络,借助互联网的海量纯文本与图文数据,赋予了GO-1强大的场景感知与理解能力。而MoE则通过隐动作专家模型和动作专家模型,利用人类操作视频和高质量仿真数据,使GO-1具备了动作的理解和精细执行能力。

GO-1展现出了多方面的卓越性能。其采训推一体化设计,实现了数据采集、模型训练与推理的无缝对接。小样本快速泛化能力,使得GO-1能够在极少数据甚至零样本的情况下,迅速适应新场景和新任务。“一脑多形”的跨本体应用能力,让GO-1能够轻松迁移至不同形态的机器人,实现快速适配。持续进化能力,则通过数据回流系统,让GO-1能从实际执行中遇到的问题数据中不断学习进化。而人类视频学习能力,则进一步增强了GO-1对人类行为的理解。

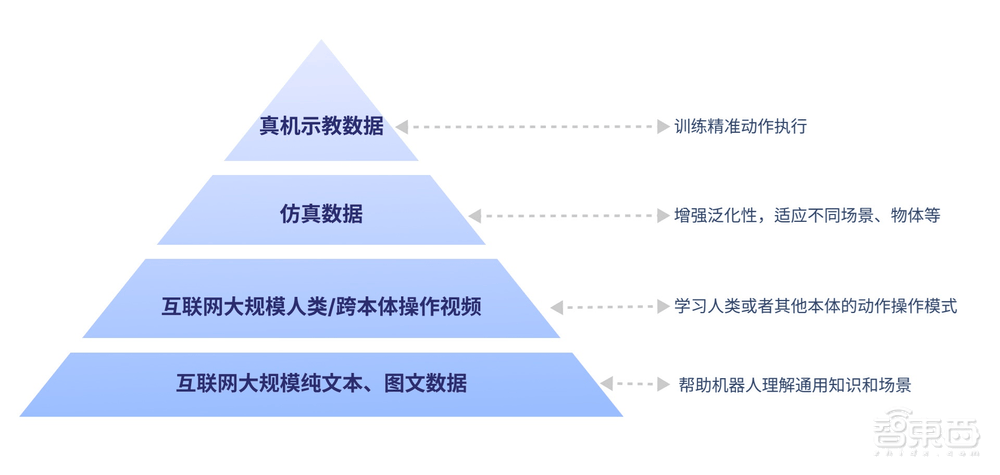

GO-1的构建基于具身领域的数字金字塔模型。底层是互联网的大规模纯文本与图文数据,为机器人提供基础知识和场景理解。之上是人类操作/跨本体视频,帮助机器人学习动作操作模式。再上层是仿真数据,用于增强泛化性。而金字塔的顶层,则是高质量的真机示教数据,用于训练精准动作执行。这一结构使得GO-1能够全面适应新场景,快速学习新操作。

在实际应用中,GO-1展现出了惊人的表现。用户只需用日常语言向机器人发出指令,如“挂衣服”,GO-1便能根据所学知识和经验,拆解任务步骤,精准完成任务。从家庭场景中的倒水、烤吐司,到商务会议中的拿饮料、拿苹果,GO-1都能迅速响应,完美执行。GO-1还能通过数据回流持续进化,如做咖啡时杯子放歪的问题,GO-1能从中学习并改进,直至成功完成任务。

GO-1的出现,标志着具身智能向通用化、开放化与智能化迈出了重要一步。它打破了场景和物体的泛化限制,实现了语言指令的泛化,能够快速学习新技能,并跨本体部署。这意味着,从家庭到办公、从商业到工业,GO-1都能迅速适应各种场景,为机器人代替人类完成工作生活中的各种事情提供了强大的脑力支持。