近期,AI基础设施领域迎来了一股新的开源浪潮,由Deepseek引领,该公司连续发布了包括FlashMLA、DeepEP、DeepGEMM、DualPipe在内的一系列代码库以及3FS系统,这些成果几乎全面覆盖了AI基础设施底层的计算、网络与存储优化,为同行提供了宝贵参考。

在这一背景下,国内AI基础设施领域的公司正积极探索针对大模型训练和推理优化的新路径,驿心科技便是其中的佼佼者。驿心科技由前旷视科技联合创始人吴文昊于2023年9月创立,专注于从基础架构层面进行研发,旨在利用标准的GPU服务器本地存储与通用以太网络,提供与传统基于RDMA的智能计算存储网络以及独立部署的商业训练存储相当的能力,从而大幅降低模型落地成本并加速部署。

驿心科技的核心优势在于,其解决方案完全基于标准企业服务器和标准网络,无需任何定制硬件、网络或软件。这与以往AI基础设施部署所需的传统高性能文件存储形成了鲜明对比,后者往往需要定制硬件服务器、特定网络交换以及定制的操作系统内核和客户端。

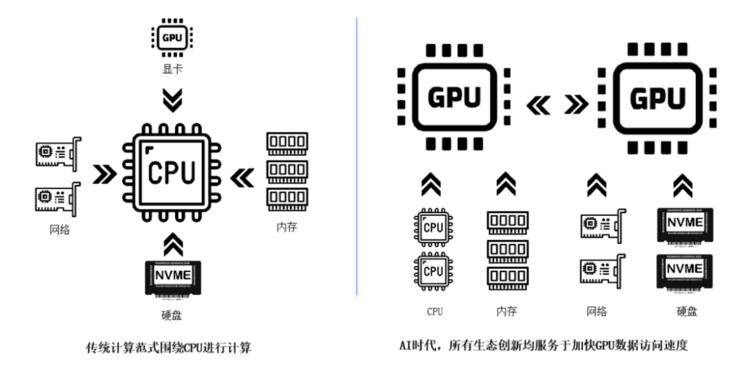

在AI基础设施领域,架构重构和供应链重构正带来新的创业机遇。技术架构方面,HPC、云和AI所需的基础设施存在差异,AI以GPU为中心,而云大厂很难提供最优化的底层基础设施,因为它们还需兼顾云原生应用的需求。尽管AI源自HPC,且都追求大规模部署,但两者在计算范式上存在本质差异,HPC追求确定性和高精度计算,而AI则追求概率和准确性。

同时,国内芯片供应链的重构也在催生巨大的AI基础设施机会,Deepseek的开源进一步推动了这一进程。然而,算力设备、能耗、机房空间和资金四大瓶颈限制了AI算力的发展。针对这些挑战,驿心科技依托GPU服务器本地存储与通用以太网络,构建了一套具有独特优势的一体化解决方案。

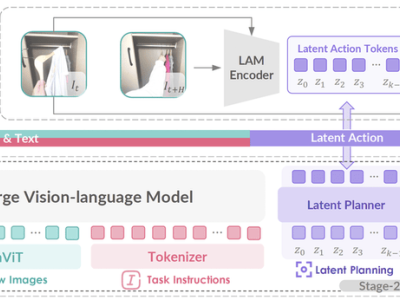

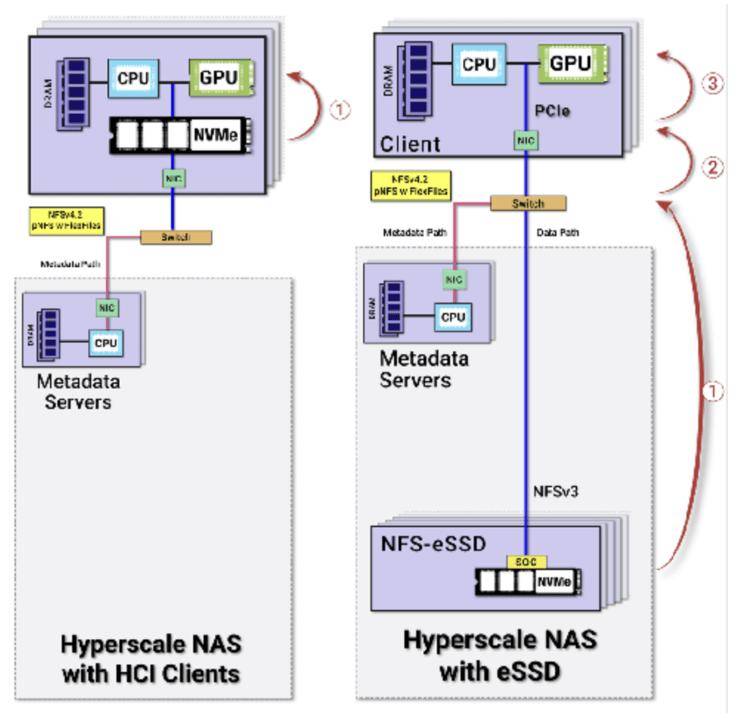

驿心科技的解决方案包括AI集群一体化方案技术创新,其Tier-0存储方案能有效利用GPU服务器内部存储,无需再构建专属的存储集群和存储网络,从而大幅削减模型落地成本并加速部署进程。在AI存储层面,驿心科技支持多云多数据中心的全局文件系统,提供统一的存储管理,使AI数据访问更高效,并支持智能数据分层和缓存机制,快速响应AI工作负载对数据的需求。

驿心科技的创始人吴文昊拥有丰富的HPC、云计算和AI经验,他的经历有助于驿心精准洞察并解决AI训练与推理的主要痛点。驿心科技目前重点布局了三个领域:云和大模型客户、AI研发类客户以及传统客户。对于云和大模型客户,驿心提供了专业的存储解决方案以及轻量级客户服务界面;对于AI研发类客户,驿心提供了专业的AI基础设施解决方案以及模型与数据能力;对于传统客户,驿心通过与OEM厂商的合作,提供了针对细分行业的存算一体机方案。

吴文昊指出,Deepseek的出现正体现了中国作为“AI工厂”的实力,尽管GPU的生产地可能不同,但打造AI工厂的最终供应链仍将来自中国。驿心科技也针对国内市场给出了更加垂直的一体化方案,与海外市场联合提供的存储方案相比,更加贴合国内客户的需求。

在模型优化层面,驿心科技结合算力、网络、分布式KV Cache等能力,提高了LLM集群的吞吐,并通过可靠的Tier-0/Tier-1存储方案保证了模型与数据的可靠性,同时支持模型的后训练与推理加速。吴文昊认为,从存储到网络向GPU传输数据的能力在LLM时代至关重要,因此驿心的AI基础设施能力主要聚焦在存储与模型层面。

驿心科技的最新一轮融资即将完成,未来将在多模态和端侧方面寻求更多突破。吴文昊表示,未来AI基础设施特别是AI存储将迎来巨大增长,因为多模态的数据量远大于语言模型,同时端侧AI也需要经过多个周期的发展才能达到如今语言模型的水平,这当中蕴含着新的机遇。