智元机器人在科技创新领域迈出了重要一步,正式揭晓了其首个通用具身基座大模型——智元启元大模型(简称GO-1)。这一发布标志着具身智能技术取得了突破性进展。

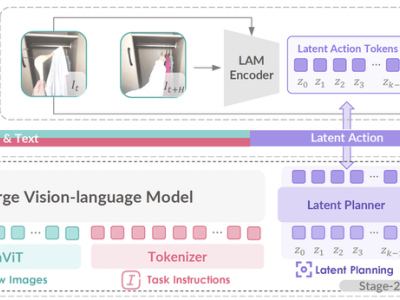

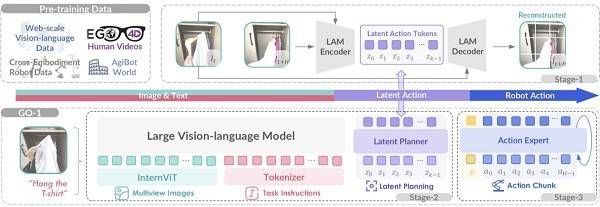

GO-1大模型的核心在于其创新的Vision-Language-Latent-Action(ViLLA)架构,该架构由多模态大模型(VLM)与混合专家模型(MoE)两大组件构成。VLM通过海量互联网图文数据的训练,获得了卓越的场景感知和语言理解能力。而MoE则进一步细分为隐式规划器(Latent Planner)和动作专家(Action Expert),前者通过大规模跨本体和人类操作数据,实现了对动作的深刻理解;后者则凭借百万真机数据的训练,具备了精细的动作执行能力。这三者之间的紧密协作,不仅使GO-1大模型能够学习人类视频,还实现了小样本快速泛化,极大地降低了具身智能的应用门槛。

GO-1大模型的问世,意味着具身智能的全面革新。它能够结合人类和多种机器人数据,使机器人具备革命性的学习能力,可广泛应用于各类环境和物品中,迅速适应新任务,学习新技能。同时,GO-1大模型支持部署到不同形态的机器人本体,实现高效落地,并在实际应用中持续进化。

GO-1大模型的四大特点尤为突出:首先,它能够结合互联网视频和真实人类示范进行学习,从而更好地理解人类行为,提升服务质量。其次,GO-1大模型具备强大的小样本快速泛化能力,能够在极少数据甚至零样本的情况下,迅速适应新场景和新任务,显著降低了使用门槛和后训练成本。再者,GO-1大模型作为通用机器人策略模型,能够在不同机器人形态之间迁移,实现快速适配和群体升智。最后,得益于智元的数据回流系统,GO-1大模型能够在实际执行中遇到问题时持续学习进化,变得越来越智能。

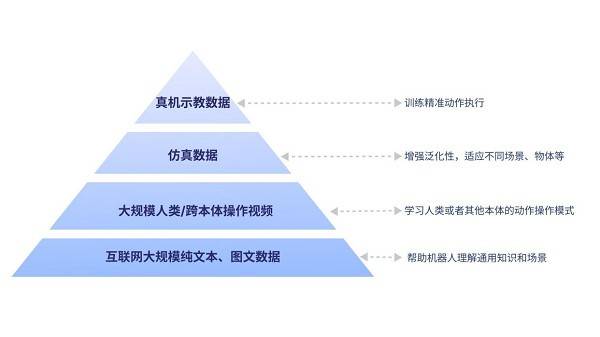

GO-1大模型的构建基于具身领域的数字金字塔模型,该模型吸纳了人类世界多种维度和类型的数据。数字金字塔的底层是互联网的大规模纯文本与图文数据,为机器人提供通用知识和场景理解的基础。往上是大规模人类操作/跨本体视频数据,帮助机器人学习动作操作模式。再往上则是用于增强泛化性的仿真数据,使机器人能够适应不同场景和物体。而金字塔的顶层,则是高质量的真机示教数据,用于训练精准动作执行。

相较于现有的Vision-Language-Action(VLA)架构,ViLLA架构通过预测隐式动作标记,有效弥合了图像-文本输入与机器人执行动作之间的鸿沟。它能够充分利用高质量的AgiBot World数据集以及互联网大规模异构视频数据,显著增强策略的泛化能力。基于ViLLA架构,GO-1大模型能够接收多相机的视觉信号、力觉信号、语言指令等多模态信息,直接输出机器人的动作执行序列。

GO-1大模型为机器人提供了全面的“基础教育”和“职业教育”,使机器人天生就能适应新场景,轻松面对多样化的环境和物体,快速学习新的操作。例如,当用户给出“挂衣服”的指令时,GO-1大模型能够根据看到的画面理解任务要求,设想操作步骤,并最终执行完成整个任务。

在更深层次的技术层面,GO-1大模型在构建和训练阶段学习了互联网的大规模纯文本和图文数据,使其能够理解“挂衣服”在此情此景下的具体含义和要求。同时,通过学习人类操作视频和其他机器人的操作视频,GO-1大模型能够知道挂衣服通常包括哪些环节。通过仿真不同衣服、衣柜和房间,以及模拟挂衣服的操作,GO-1大模型能够理解环节中对应的物体和环境,并打通整个任务过程。最后,由于学习了真机的示教数据,机器人能够精准完成整个任务的操作。

GO-1大模型的推出,标志着具身智能正朝着通用化、开放化、智能化的方向快速迈进。机器人将能够在不同场景中执行多种任务,而无需针对每个新任务重新训练。同时,机器人将不再局限于实验室环境,而是能够适应多变的真实世界。机器人将能够理解自然语言指令,并根据语义进行组合推理,而不再局限于预设程序。