科大讯飞与华为携手,在国产算力领域迈出了重要一步。近日,双方联合宣布,在MoE模型的大规模跨节点专家并行集群推理方面取得了突破性进展。这一成果不仅标志着国产算力在AI领域的一次飞跃,也预示着未来智能计算的新篇章。

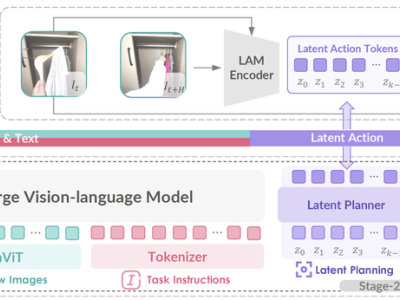

此次合作的亮点在于,双方团队通过软硬件的深度协同创新,成功挖掘了硬件的极致潜力。特别是在昇腾集群上的验证和部署过程中,团队在算子融合方面取得了显著成果。通过MLA预处理阶段的Vector与Cube异构计算单元并行流水,以及将多个小算子融合重构为原子级计算单元,团队成功消除了小算子下发的开销,MLA前处理时延降低了50%以上,性能得到了大幅提升。

在混合并行策略和通信计算并行优化方面,科大讯飞与华为的团队也展现出了卓越的创新力。他们构建了TP(张量并行)+EP(专家并行)的混合范式,对MLA计算层采用机内TP并行,充分发挥了机内高速互联的优势,降低了跨机通信的损耗。同时,团队还创新性地进行了MoE专家分层调度,64卡均衡分配专家计算节点,并定制了AllToAll通信协议,使得专家数据交换效率提升了40%。通过构建跨机/机内双层通信架构,团队实现了分层优化,降低了跨机流量60%。他们还研发了路由专家负载均衡算法,使得卡间负载差异小于10%,集群吞吐提升了30%。

这一系列的创新使得国产算力在分布式架构与算法协同优化方面取得了显著的性能提升。单卡静态内存占用缩减至双机部署的1/4,效率提升了75%,专家计算密度增加了4倍,推理吞吐提升了3.2倍,端到端时延降低了50%。这些成果无疑为国产算力在AI领域的应用打开了新的大门。

科大讯飞研究院表示,这一突破性的解决方案将广泛应用于讯飞星火深度推理模型的训练加速中。预计训练时的推理效率将提升200%,同时基于该方案的推理引擎也将在国产算力上实现DeepSeek V3和R1的高效推理。这无疑将进一步提升科大讯飞在AI领域的竞争力。

科大讯飞深度推理大模型星火X1也完成了升级。在模型参数量比业界同行少一个数量级的情况下,星火X1的数学能力已经全面对标DeepSeek R1和OpenAI o1,在中文数学各项任务中均实现了领先。这一成果不仅展示了科大讯飞在AI领域的深厚底蕴,也为其未来的发展奠定了坚实的基础。

科大讯飞与华为的这一合作不仅是一次技术上的突破,更是国产算力在AI领域崛起的重要标志。随着双方合作的不断深入,相信未来会有更多令人瞩目的成果涌现。

双方团队在合作过程中展现出的创新精神和协作能力也值得称赞。他们通过深度协同创新,成功挖掘了硬件的极致潜力,为国产算力的发展注入了新的活力。相信在未来的合作中,双方将继续携手前行,共同推动国产算力在AI领域的蓬勃发展。