近日,智元机器人在科技创新领域迈出了重要一步,正式推出了其首个通用具身基座模型——智元启元大模型Genie Operator-1(简称GO-1)。这一突破性成果不仅标志着智元机器人在具身智能技术上的深度探索,也为机器人行业带来了全新的发展视角。

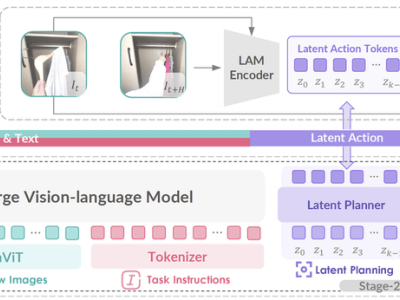

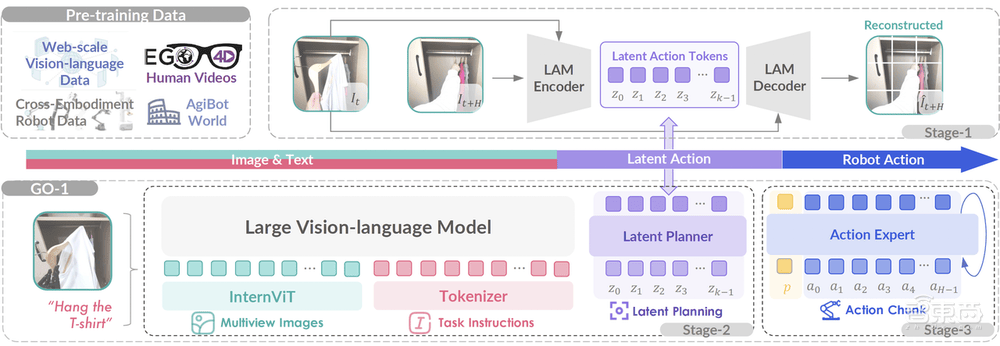

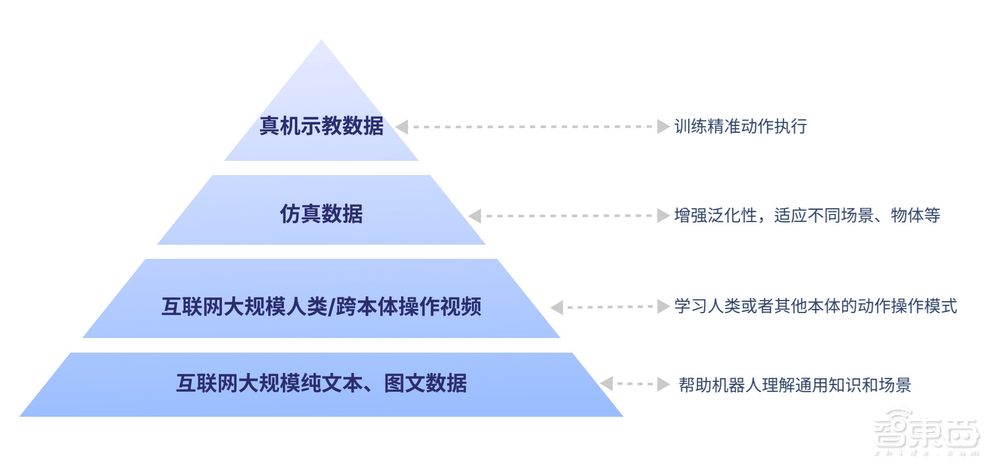

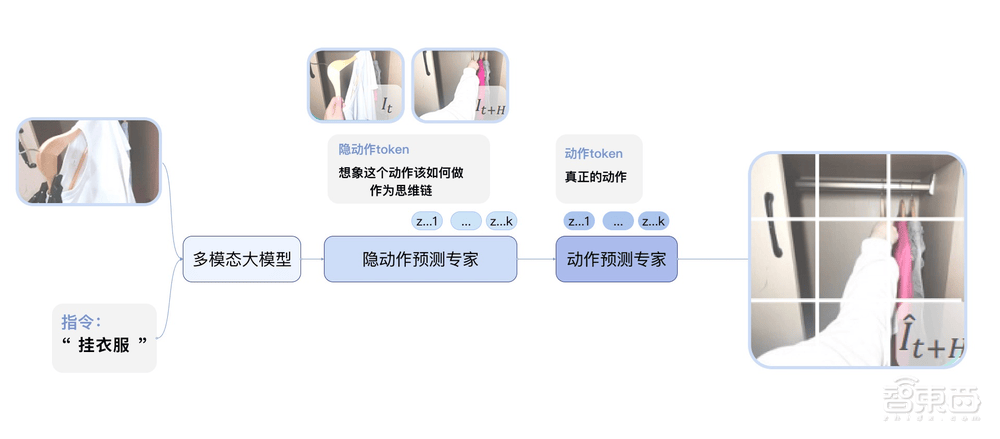

GO-1的核心在于其创新的Vision-Language-Latent-Action(ViLLA)框架,该框架巧妙融合了VLM(多模态大模型)与MoE(混合专家)技术。VLM作为模型的主干网络,通过大规模互联网纯文本和图文数据的训练,赋予了GO-1强大的场景感知与理解能力。而MoE则进一步增强了模型的动作规划与执行能力,特别是隐动作专家模型和动作专家模型的引入,使得GO-1能够基于互联网上的人类操作视频和高质量仿真数据,精准执行多样化任务。

GO-1的推出,解决了传统具身智能面临的诸多挑战,如场景与物体泛化能力不足、语言理解能力缺失、新技能学习缓慢以及跨本体部署困难等。其独特的“一脑多形”特性,使得GO-1能够轻松适配不同形态的机器人本体,实现快速迁移与应用。同时,借助智元软硬件一体化框架,GO-1实现了数据采集、模型训练与模型推理的无缝衔接,大大提高了开发效率。

在功能展示中,GO-1展现出了惊人的小样本快速泛化能力。用户仅需通过简单的语言指令,如“挂衣服”,GO-1便能迅速理解并执行任务。这一过程不仅依赖于VLM对语言与视觉信息的深入理解,更得益于MoE对人类操作模式的精准模拟与仿真数据的强化训练。从理解指令、规划动作到执行操作,GO-1展现了高度的智能化与自主性。

GO-1的学习能力同样令人瞩目。通过结合互联网视频与真实人类示范,GO-1能够不断增强对人类行为的理解与模仿能力。而数据回流系统的引入,则让GO-1能够从实际执行中遇到的问题数据中持续进化学习,不断优化自身性能。例如,在制作咖啡时若出现杯子放置不当的情况,GO-1能够通过数据回流进行自我修正,直至成功完成任务。

在实际应用场景中,GO-1展现了广泛的应用潜力。无论是家庭场景中的餐食准备、桌面收拾,还是办公与商业场景中的接待访客、发放物品,GO-1都能轻松应对。其强大的跨场景适应能力,让机器人得以走向更多不同领域,适应多变的真实世界。在商务会议中,面对“帮我拿一瓶饮料”或“帮我拿一个苹果”的语音指令,GO-1能够迅速响应并执行任务,展现了其在高要求环境下的稳定性与可靠性。

智元机器人的这一创新成果,无疑为具身智能的通用化、开放化与智能化发展注入了新的活力。随着GO-1的广泛应用与持续优化,我们有理由相信,未来的机器人将更加智能、灵活与高效,为人类社会带来更多便利与价值。