在探讨产业未来的关键驱动力时,技术创新的重要性不言而喻,但更为核心的是,如何以更低的成本和更高的效率将创新转化为实际生产力,特别是人工智能(AI)领域的潜力。近期,随着DeepSeek的横空出世,大模型技术再次迎来了爆发期,短短一个多月内,其能力边界不断被突破,“落地”已成为业内共识。

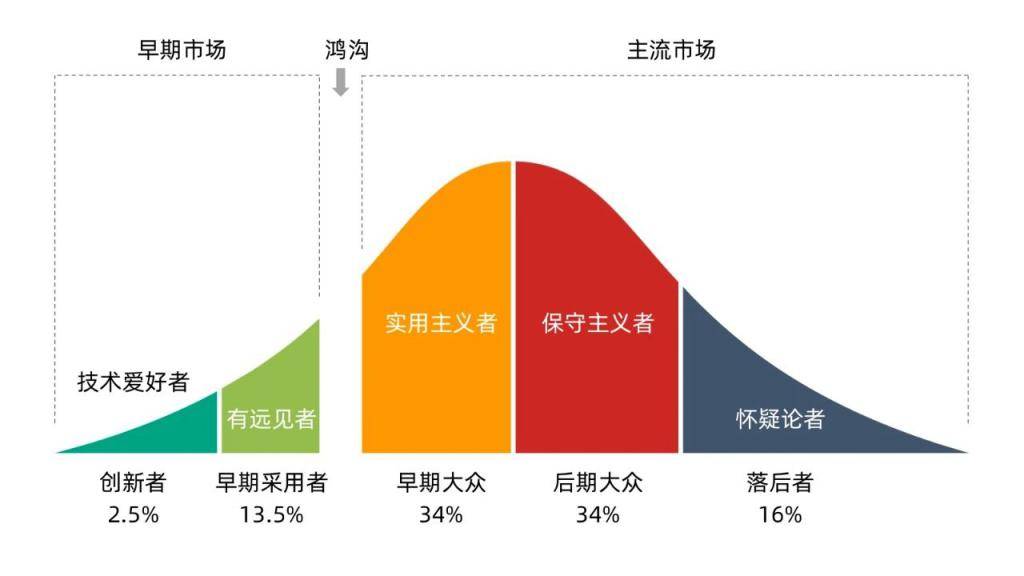

在这一背景下,企业如何在生态系统中找到最佳定位成为关键议题。上世纪90年代,杰弗里·摩尔基于埃弗雷特·罗杰斯的“创新扩散理论”,在《跨越鸿沟》一书中将技术采用者分为五类:创新者、早期采用者、早期大众、后期大众和落后者。当前,大模型正处于从早期采用者向早期大众过渡的“鸿沟”阶段,如何迅速扩散创新,支撑应用落地成为核心挑战。

算力瓶颈成为制约大模型落地的一大障碍。DeepSeek在流量洪峰下一度陷入崩溃循环,而一些第三方MaaS平台也因算力成本高昂,月亏4亿,不得不关闭相关服务。算力供应的不稳定和价格居高不下,不仅束缚了使用者的手脚,也给MaaS平台带来了巨大压力。因此,打破算力瓶颈,成为大模型创新扩散的关键。

与此同时,百度智能云宣布在百舸4.0的加持下,成功点亮昆仑芯三代万卡集群,为跨越算力鸿沟提供了新解法。百舸4.0通过覆盖大模型落地全流程的算力平台,让用户能够高效、低成本地使用算力。创建集群的过程从通常需要的几周缩短到仅需1小时,且能保障大规模集群的高稳定性和高效训练。

在大模型训练中,百舸4.0在集群设计、任务调度、并行策略、显存优化等方面进行了大量优化,使端到端性能提升了30%。其多芯混训、多芯适配能力,能够统一管理不同厂商、不同代际的芯片,高效完成模型的训练和推理任务。在万卡规模上,百舸4.0将两种芯片混合训练的效率折损控制在了5%以内,为行业树立了新标杆。

随着大模型产业的深入发展,大中型企业的选择成为市场需求的真实反映和创新方向的洞察窗口。据统计,2024年全年大模型相关中标项目中,百度智能云斩获55个项目,中标金额3.4亿元,在能源、政务、金融等行业领先。进入2025年,百度智能云继续保持领先,中标项目数量和中标金额均位居第一,显示出其在高效率和低成本方面的显著优势。

这一优势的背后,是百度智能云的全栈AI技术能力。作为国内少数同时深耕芯片、框架、模型、应用的企业,百度能够针对大模型的训推、部署和调优进行全流程优化。昆仑芯三代万卡集群的率先验证,展示了通过模型优化等手段,最大化提升集群综合利用率,降低单位算力成本的可行性。

随着“百模大战”格局的瓦解,大模型市场仅剩少数玩家,企业开始将注意力集中到应用层,思考如何将技术可能性转化为稳定生产力。百度智能云的示范效应,倒逼全行业提升工程能力,从底层芯片到智算平台,再到大模型,进行全栈创新与快速迭代。

在落地应用的号角吹响后,竞争的天平进一步向“扩散”倾斜。算力、模型以及工程能力的比拼成为关键。谁能借助系统性的技术体系和方法论降低成本、提升大模型落地易用性、帮助企业更好地构建AI原生应用,谁就有机会成为最后的赢家。

展望未来,随着大模型技术的不断成熟和应用场景的拓展,对算力的需求将呈现出指数级增长态势。百度智能云等领先企业正积极布局更大规模的智算集群,以满足源源不断的算力需求,推动大模型从创新走向产业应用,开启AI新时代。