在科技界的瞩目下,“MemoryS 2025”存储行业峰会于深圳盛大召开,汇聚了全球闪存领域的领军企业及其高管。此次峰会上,一个令人瞩目的现象是,高管们的演讲中频繁提及的词汇不再是NAND、LPDDR或UFS等专业技术术语,而是AI、大模型以及DeepSeek,这些词汇成为了新的焦点。

峰会以“存储格局·价值重塑”为主题,嘉宾们的演讲内容紧紧围绕着行业格局的深刻变革。大会主办方CFM闪存市场的总经理邰炜先生风趣地表示,如果非要为本次大会挑选一个口号,那非“谢谢大家,谢谢AI”莫属。

AI虽非新鲜事物,但DeepSeek-R1的问世却颠覆了传统规则。以往,AI给人的印象是需要庞大的算力来支撑大模型的训练和推理任务。然而,DeepSeek凭借其创新的MoE架构和稀疏算力机制,显著降低了对算力的需求,加之MIT开源协议,使得AI真正步入了全民普惠的新纪元。忆恒创源的CEO张泰乐乐观预测,全民AI的时代将在2025年到来。而在摆脱对大规模算力的依赖后,闪存成为了推动AI普及的关键。

AI技术正以前所未有的力量赋能各行各业,闪存与算力成为了支撑大模型发展的两大基石。闪存的传统应用场景包括服务器、PC和手机,而智能化程度日益提升的汽车正迅速成为第四大应用场景。尽管手机与PC行业的市场趋于饱和,给闪存市场规模的扩大带来了挑战,但AI时代的到来将打破这一僵局,为闪存行业注入新的活力。

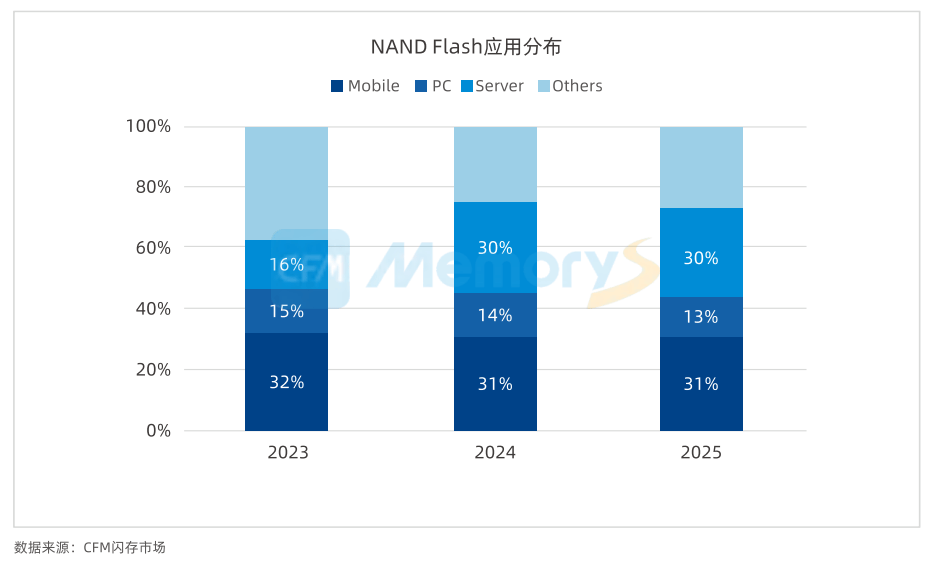

CFM闪存市场的数据显示,2024年存储应用市场中,服务器的份额从2023年的16%跃升至30%,仅比手机低1个百分点,有望在2025年超越手机成为最大份额的应用领域。这一增长背后的重要驱动力正是AI。AI大模型的训练需要海量的数据,这对企业的存力提出了极高要求,促使企业大量采购存储设备。过去,一些企业为了降低成本,会选择使用价格低廉的企业级机械硬盘存储数据,然而AI大模型对数据读写速度、带宽和功耗的要求极高,机械硬盘已难以满足需求。

大普微电子董事长杨亚飞公布的测试数据揭示,在AI工作流程的各个环节中,机械硬盘与固态硬盘的性能差距高达十几倍。因此,闪存技术成为了AI企业的必然选择。AI技术从云端向端侧的转移,也为闪存行业带来了新的机遇。云侧AI大模型需要将数据上传至云端,这引发了用户对数据安全的担忧。而DeepSeek提供了不同参数量的版本,且不依赖GPU运算,非常适合在手机或PC上本地部署。

在AI技术的推动下,闪存行业正迎来前所未有的发展机遇。IDC预测,2025年AI智能手机的销量将同比增长73.1%,LPDDR5X的容量也将比2024年的旗舰机型增长50%-100%。Gartner则预测,2025年AI PC将占据PC出货总量的43%,并且DRAM容量将比普通PC高出80%以上。在汽车领域,小鹏汽车的高管也阐述了AI与汽车融合的情况以及闪存的重要性,强调AI汽车需要高带宽、低延迟、大容量的存储产品。

AI已然成为闪存行业的福祉。在AI大模型超高需求量的推动下,2024年全球NAND市场规模达到了700亿美元,容量高达8330亿GB;DRAM市场规模则达到了970亿美元,容量达2500亿Gb。未来,AI行业对存储设备的需求量还将持续增长,闪存市场也将借助AI的东风实现迅猛发展。

然而,机遇总是与挑战并存。AI大模型的训练和推理对闪存的读写速率、带宽、功耗以及成本都极为敏感,这对闪存企业提出了更高的要求。只有全方位满足AI行业对闪存产品要求的企业,才能在激烈的市场竞争中脱颖而出,赢得更多的市场份额。

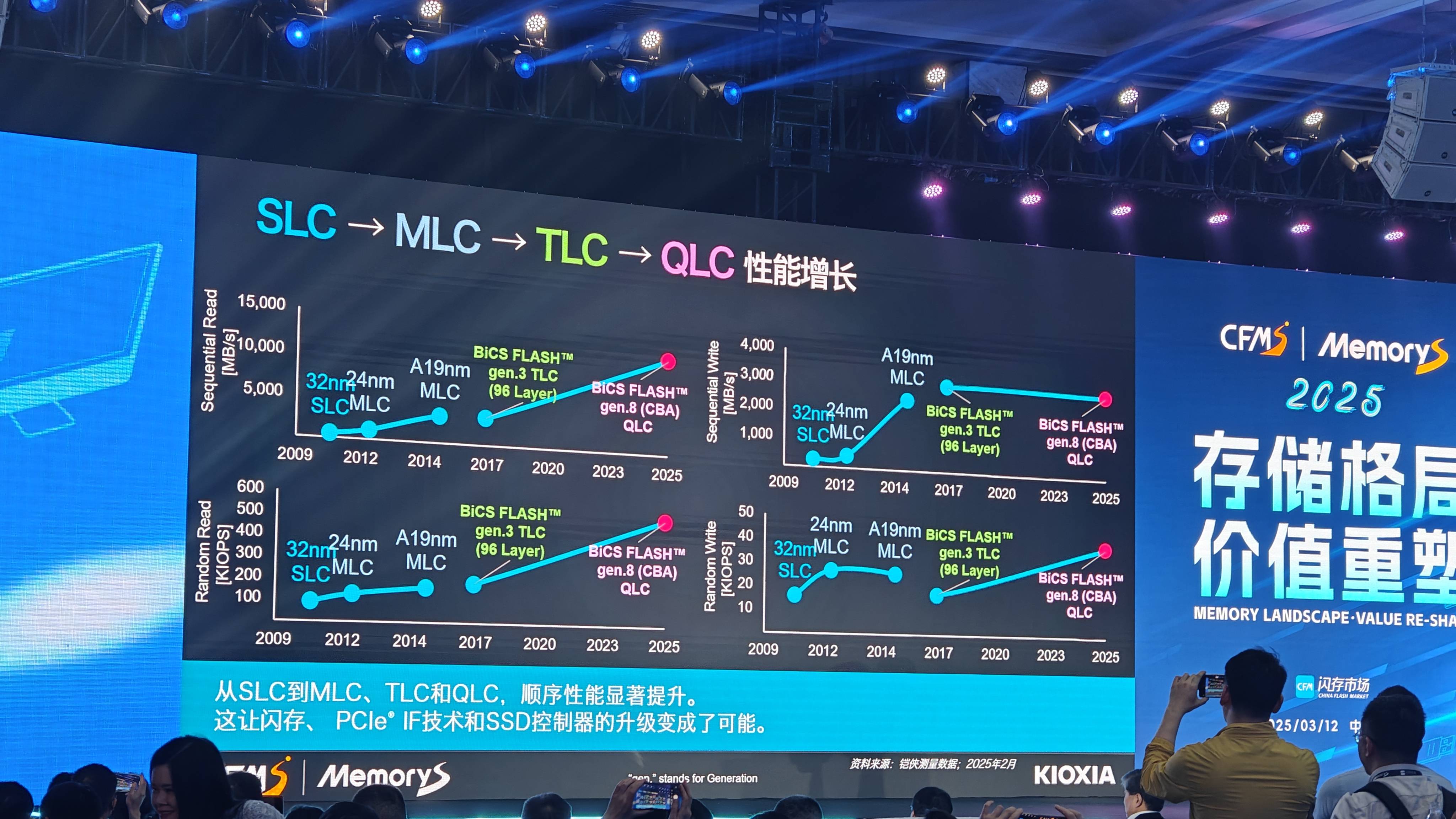

在大会上,邰炜先生率先指出,由于大容量存储的需求,QLC时代提前到来。2024年QLC SSD甚至出现了供不应求的情况,32TB大容量企业级SSD已经大规模量产,64TB和128TB容量的QLC企业级SSD需求量也在不断增加。预计2025年,QLC SSD将有45%的产能应用在服务器上。相较于消费级市场常见的TLC颗粒,QLC颗粒成本更低,且性能随着技术的演进不断提升。如今QLC SSD的顺序读写速度可达7000MB/s左右,完全能够满足AI大模型数据存储和调用的需求。

为了进一步降低成本,企业正不断尝试更高堆叠层数的NAND产品。预计2025年,NAND将全面进入300+层数时代。一些企业甚至已经爆出了400+层数的NAND,这将进一步提升QLC SSD的容量密度并降低成本,为AI行业的发展提供坚实的基础。闪存企业还在主控方面投入巨资进行技术研发。群联电子、联芸科技等大多数参会企业都强调了主控的重要性,并表示未来将持续投入资金研发主控技术和芯片,以提高存储设备的读写速度、降低功耗。