近日,科技界迎来了一项新的突破,meta AI与加州大学伯克利分校携手推出了一个名为SWEET-RL的强化学习框架,并配套发布了CollaborativeAgentBench(简称ColBench)基准测试。这一合作旨在提升大语言模型(LLMs)在多轮人机协作任务中的性能,特别是在后端编程和前端设计两大领域。

随着大语言模型的发展,它们逐渐展现出执行复杂任务的潜力,但在多轮决策任务中仍面临诸多挑战。传统的训练方法主要依赖于单轮反馈或模仿高概率行为,这种方法在处理长期依赖和累积目标时显得力不从心,导致模型在协作场景中表现平平,特别是在理解人类意图和多步骤推理方面。

SWEET-RL框架的推出,正是为了解决这一难题。它采用了非对称的“演员-评论家”结构,其中评论家在训练过程中能够访问额外信息(如正确答案),从而更准确地评估演员的决策。这一创新不仅简化了信用分配过程,还与LLMs的预训练架构实现了更好的对齐。

实验结果显示,SWEET-RL在后端编程任务中的通过率显著提升至48.0%,在前端设计任务中的余弦相似度也达到了76.9%,这一成绩显著优于其他多轮强化学习方法。这一突破性的进展,无疑为LLMs在多轮人机协作任务中的应用开辟了新的道路。

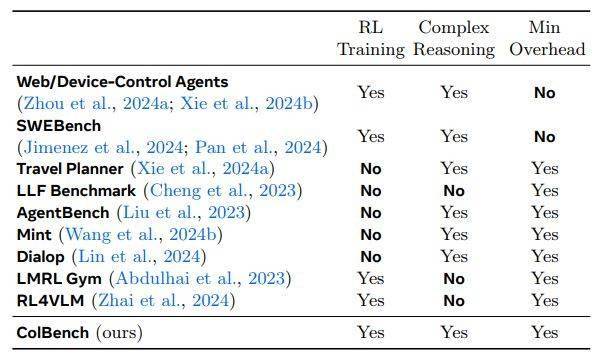

为了更全面地评估SWEET-RL的性能,meta AI和加州大学伯克利分校还推出了ColBench基准测试。ColBench包含了超过10000个训练任务和1000个测试案例,这些任务设计均模拟了真实的人机协作场景,涵盖了后端编程(如Python函数编写)和前端设计(如HTML代码生成)两大领域。该基准测试还限制了每轮交互的次数,最多不超过10次。

ColBench基准测试通过单元测试通过率和余弦相似度两个指标来评估模型的性能,为多轮任务提供了可靠的评估标准。这一测试平台的推出,不仅有助于研究人员更准确地评估SWEET-RL的性能,也为未来LLMs在多轮人机协作任务中的发展提供了有力的支持。