在人工智能领域,大模型的崛起无疑成为了技术进步的强大驱动力。然而,随着模型参数量的急剧增加,对算力的需求也随之飙升,给行业带来了前所未有的挑战。如何在保证效率的同时,降低运行大模型的成本,成为了众多企业关注的焦点。

DeepSeek R1满血大模型,凭借其高达6710亿的参数量以及创新的MLA注意力机制和混合专家(MoE)架构,在提升推理效能方面取得了显著成果。然而,在实际应用中,企业对于大模型的性价比有着更为严格的要求。

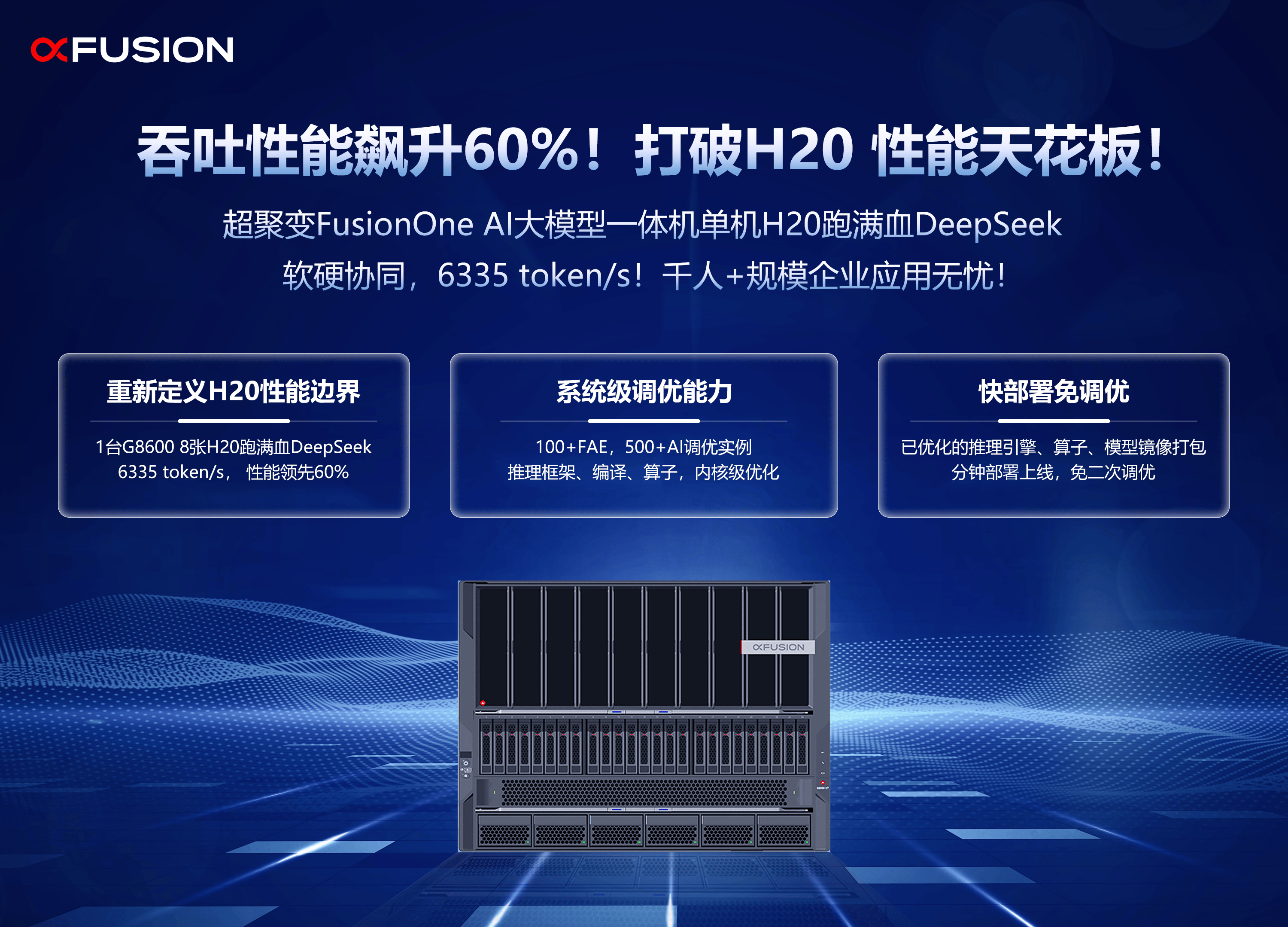

近日,超聚变公司推出的FusionOne AI大模型一体机,通过软硬件的深度协同优化,成功突破了H20硬件在运行DeepSeek满血大模型时的性能极限。在模拟的对话场景中,仅需一台FusionServer G8600服务器搭载8张H20硬件,便能流畅运行DeepSeek R1满血版,支持高达1024的并发访问数,总吞吐量更是达到了6335 token/s,相比业内同类方案,性能提升了60%。

这一突破得益于超聚变在软硬件协同优化方面的深厚积累。通过内核优化,FusionOne AI大模型一体机提升了显存空间的利用率,使得模型参数和过程数据能够更高效地运行。同时,采用DP数据并行和TP模型张量并行技术,实现了多卡分布式并行计算,进一步提升了token生成的吞吐效率。

FusionOne AI大模型一体机还采用了创新的推理任务切片混合调度策略。在Prefill阶段,即首token输出阶段,通过长文本切片加速初始内容的生成速度。而在每个切片计算过程中,混合调度Decode任务,即后续token迭代生成任务,使得这些任务能够并行运行,无需串行等待,从而提高了资源利用率,降低了TTFT(首token输出时间)和TPOT(每个输出token的时间)。

超聚变FusionOne AI大模型一体机的推出,不仅大幅降低了DeepSeek-R1 671B模型的部署门槛,更以普惠的形态让更多的企业和科研机构能够轻松应用这一先进技术。这一成果不仅展示了超聚变在AI算力优化方面的强大实力,更为推动AI技术的广泛应用和落地注入了新的动力。

超聚变在软硬件协同优化方面的探索并未止步。未来,随着技术的不断进步和应用场景的不断拓展,超聚变将继续加大研发投入,聚焦AI算力优化与应用拓展,为企业AI应用的落地提供更加全面和高效的支持。