近日,阿里云通义千问宣布了一项重要进展,正式开源了尺寸更小的视觉理解模型Qwen2.5-VL-32B-Instruct。此次开源行动紧随其发布步伐,引发了科技界的广泛关注。

Qwen2.5-VL-32B-Instruct在多个方面展现了显著优势。首先,研究人员对模型的输出风格进行了调整,使其回答更为详尽、格式更加规范,更符合人类的阅读习惯和偏好。其次,在数学推理能力上,该模型能够应对复杂的数学问题,展现出强大的逻辑分析能力。在图像解析、内容识别以及视觉逻辑推导等任务中,Qwen2.5-VL-32B-Instruct也表现出了极高的准确性和细粒度分析能力。

这款新模型是在1月底开源的Qwen2.5-VL系列视觉模型的基础上,通过强化学习框架持续优化而来的。新模型采用了Apache 2.0协议进行开源,使得更多开发者能够轻松获取并利用这一先进技术。

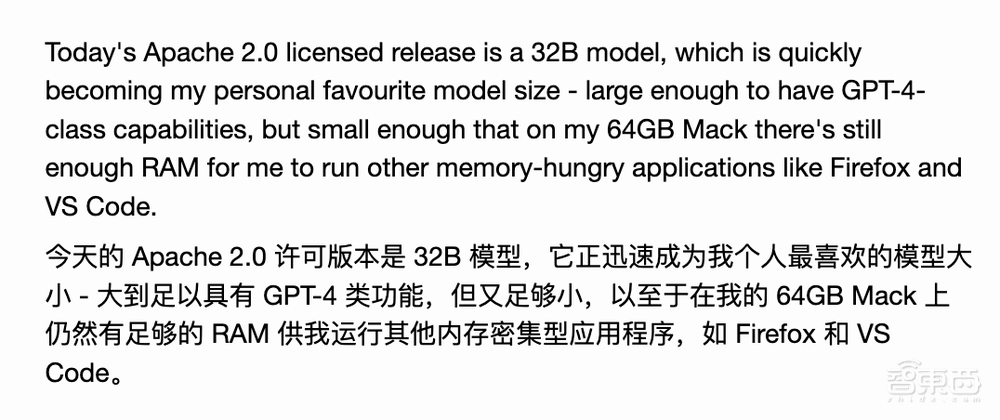

科技博主Simon Willison在其博客中分享了对Qwen2.5-VL-32B-Instruct的使用体验。他表示,32B参数规模的模型正逐渐成为他的最爱,因为它既能提供接近GPT-4级别的能力,又能在配备64GB内存的Mac上流畅运行,同时留出足够的RAM空间用于运行其他内存占用较大的应用程序,如Firefox浏览器和Visual Studio Code开发工具。

Qwen2.5-VL-32B-Instruct的图片理解能力同样令人印象深刻。Simon Willison通过上传一张图片进行测试,模型迅速识别出了图片中的地理特征、分颜色区域、深度等值线以及保护区等诸多要素,展现了其在细粒度图像理解方面的强大实力。

官方博客中进一步展示了Qwen2.5-VL-32B-Instruct在细粒度图像理解和数学推理方面的实际应用。在一道关于货车行驶时间的题目中,模型不仅理解了用户需求,还准确识别了图片中的限速信息,并据此给出了合理的结论。在解决几何难题时,模型也展现出了对几何图形基本概念和相关角之间位置关系的准确理解。

在基准测试中,Qwen2.5-VL-32B-Instruct的表现同样抢眼。它不仅超过了Mistral-Small-3.1-24B和Gemma-3-27B-IT等同类模型,还超越了参数规模更大的前代模型Qwen2-VL-72B-Instruct。特别是在强调复杂任务多步骤推理的MMMU、MMMU-Pro和MathVista测试中,Qwen2.5-VL-32B-Instruct更是展现出了卓越的性能。同时,在注重主观用户体验评估的MM-MT-Bench基准测试中,该模型也取得了优于前代的成绩。