阿里云近期在人工智能技术领域迈出了重要一步,隆重推出了其新一代多模态旗舰模型Qwen2.5-Omni,这款模型的问世标志着在全方位多模态感知能力上的重大突破。

Qwen2.5-Omni的亮点在于其能够无缝处理文本、图像、音频以及视频等多种输入形式,并以一种即时且流畅的流式响应方式,生成相应的文本和自然语音合成输出。这一特性使其在多种应用场景中展现出极高的灵活性和实用性。

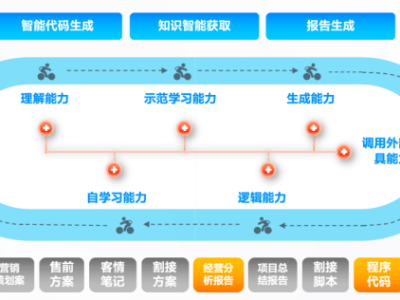

据阿里云官方透露,Qwen2.5-Omni采用了前沿的Thinker-Talker双核架构设计。具体而言,Thinker模块如同智慧的大脑,负责深度解析和处理来自文本、音频、视频等多种模态的输入信息,生成高层次的语义表征和对应的文本内容。而Talker模块则扮演了发声器官的角色,它接收Thinker模块传递的实时语义表征和文本,通过流式处理技术,高效地将这些信息转化为连贯、自然的语音输出。

在严格的测试中,Qwen2.5-Omni展现了其卓越的多模态处理能力。与规模相近的单模态模型以及封闭源模型相比,如Qwen2.5-VL-7B、Qwen2-Audio和Gemini-1.5-pro,Qwen2.5-Omni在图像、音频、音视频等多个模态场景下的表现均更为出色。这一成绩不仅验证了其在技术上的先进性,也为其在实际应用中的广泛推广奠定了坚实的基础。