随着AI技术的飞速发展,本地部署大模型已成为技术发烧友们的热门话题。今年年初,DeepSeek AI大模型的横空出世,更是将这一热潮推向了新的高度。相较于付费使用现成的AI应用,DeepSeek的完全开源特性吸引了大量爱好者,他们热衷于在本地部署这一大模型,充分利用现代硬件的强大AI性能。

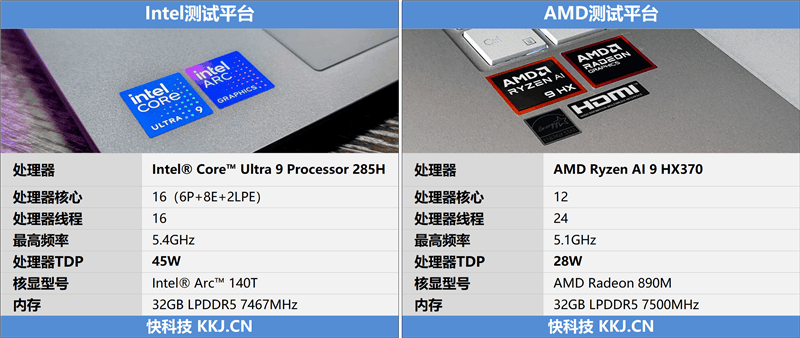

然而,对于主流的笔记本平台而言,本地运行DeepSeek大模型的效果究竟如何呢?为了解答这一问题,我们选取了两台配置相近的轻薄本进行测试,分别搭载了Intel酷睿Ultra 9 285H处理器和AMD锐龙AI 9 HX370处理器,它们都是各自平台上轻薄本能够搭载的最强处理器。

在本地部署的DeepSeek只能是蒸馏版,因为满血版DeepSeek-R1模型的庞大参数远超笔记本平台的承载能力。但幸运的是,DeepSeek提供了六个不同规模的蒸馏后小模型,用户可以根据自己的硬件配置选择合适的模型规模。这些模型都是开源的,任何人都可以下载并部署到自己的设备上。

选择合适的模型规模,关键在于运行设备的显存或内存容量,对于笔记本用户来说,这主要取决于内存大小。近年来,随着AI PC概念的兴起,电脑的内存容量普遍从32GB起步,就连一向以高昂价格著称的苹果,其最新的Mac Mini M4也将内存升级到了16GB起步。

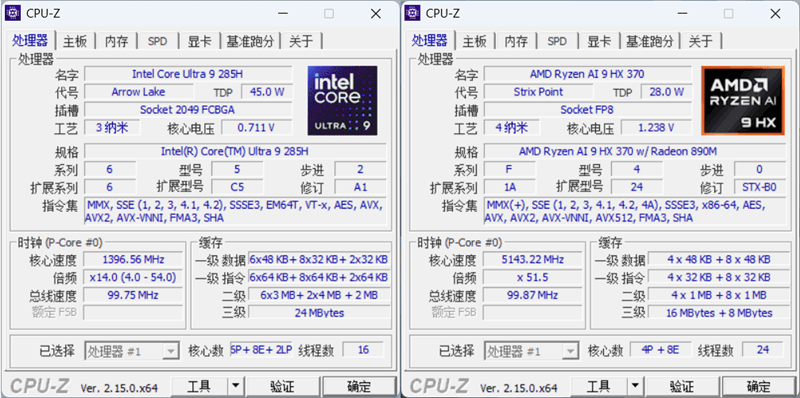

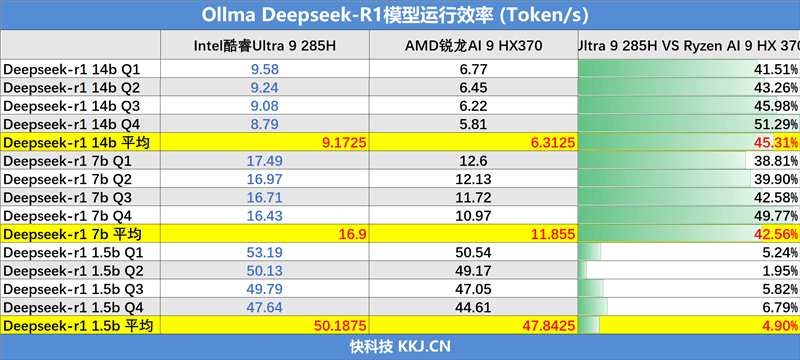

我们测试的两台笔记本,在配置上各有千秋。Intel酷睿Ultra 9 285H处理器基于Arrow Lake架构,拥有16核心(不支持超线程),性能核最大睿频可达5.4GHz,并内建Intel锐炫140T显卡和NPU,提供高达13 TOPS的算力。而AMD锐龙AI 9 HX370处理器则基于Zen 5架构,拥有12核心24线程,最高加速频率为5.1GHz,并内建AMD Radeon 890M显卡和独立的NPU引擎,算力高达55 TOPS。

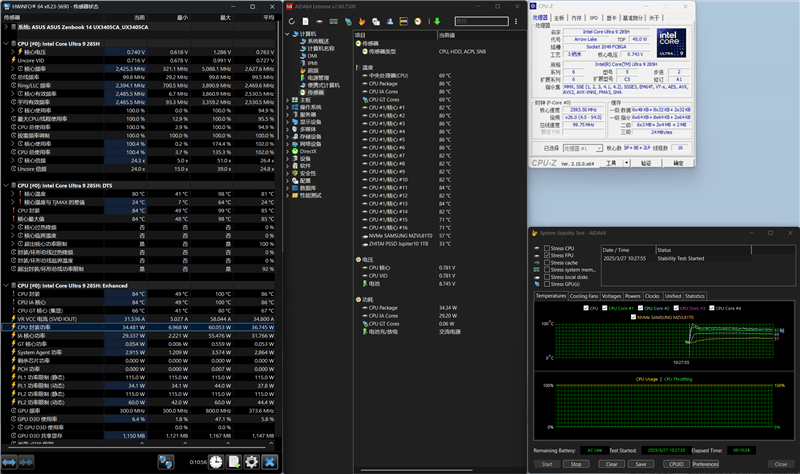

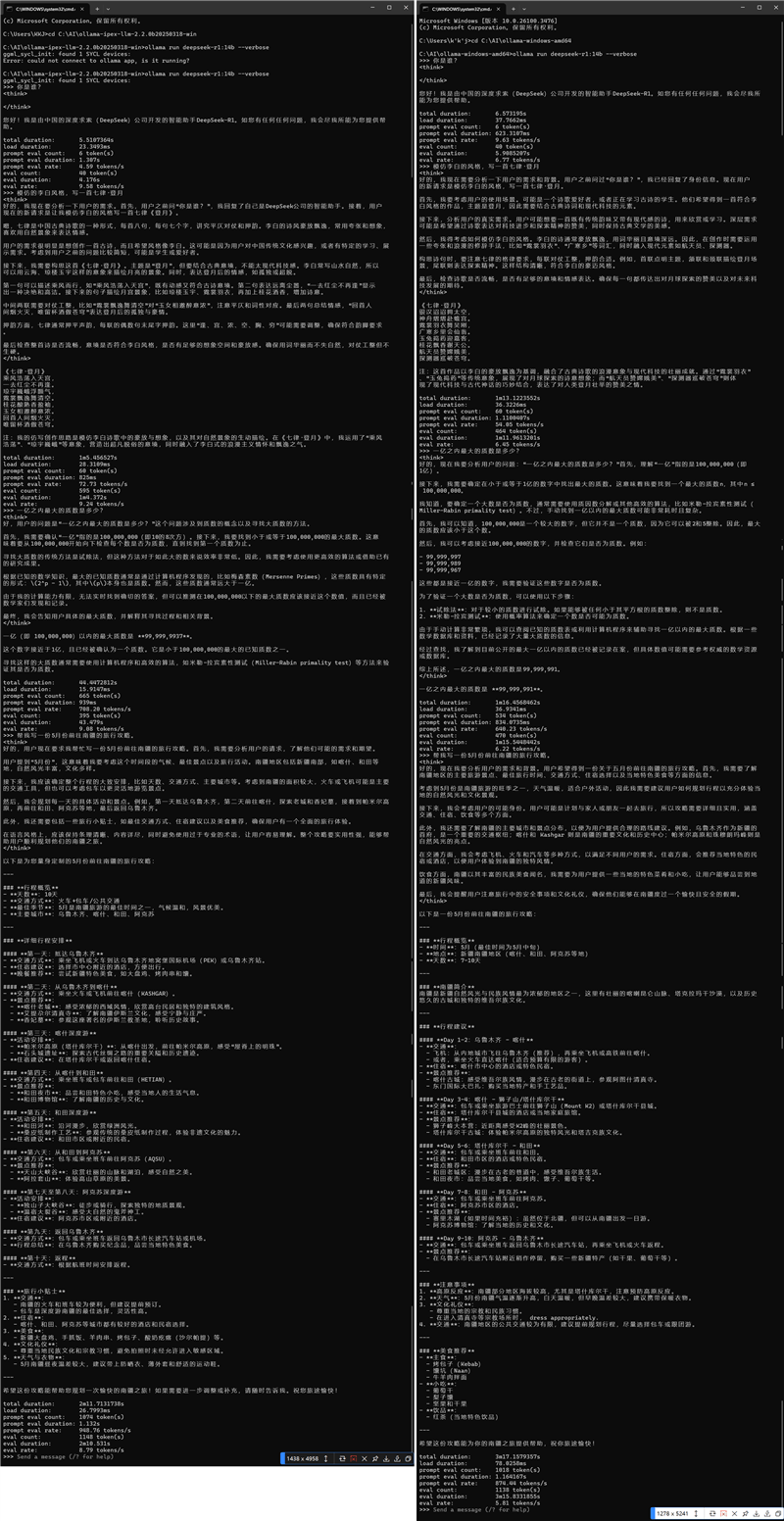

在实际测试中,我们基于Ollama框架,在本地部署了DeepSeek-R1的蒸馏版模型,并测试了使用iGPU的运行效率。为了避免图形UI造成的延迟和性能影响,我们直接在命令行中与DeepSeek-R1:14B模型进行对话,准备了四个问题来测试其表现。结果显示,14B规模的模型在反应速度和回答准确率上都表现出色,而更小规模的模型虽然执行速度更快,但AI智力明显下降,经常出现无法回答或陷入死循环的情况。

在对比Intel和AMD处理器的表现时,我们发现Intel酷睿Ultra 9 285H在针对Intel优化过的Ollama上每秒token输出更高,在14B和7B规模模型中,相比AMD锐龙AI 9 HX370有40%左右的领先。这一结果虽然并不能代表Intel处理器在AI性能上就一定比AMD处理器强很多,但至少从实际测试来看,针对Intel优化过的框架确实拥有更好的支持。

我们还测试了Deepseek-R1:14B模型在Intel酷睿Ultra 9 285H处理器的轻薄本上的实际表现。通过安装针对Intel酷睿Ultra处理器优化的AI应用工具Flowy AI PC软件,我们使用Deepseek-R1:14B模型编写了一个基于HTML语言的贪吃蛇游戏。结果显示,虽然游戏比较简陋,但基本的游戏功能已经没有问题,这证明了Intel酷睿Ultra 9 285H处理器搭配Deepseek-R1:14B模型已经具备了一定的实用价值。

DeepSeek大模型的开源极大地降低了本地部署AI大模型的门槛,即使在轻薄本这种性能有限的移动平台上,也能实现相当不错的性能表现。而Intel酷睿Ultra 9 285H处理器在针对Intel优化过的框架上展现出了强劲的实力,这从一个侧面说明了软件适配对于AI大模型高效运行的重要性。