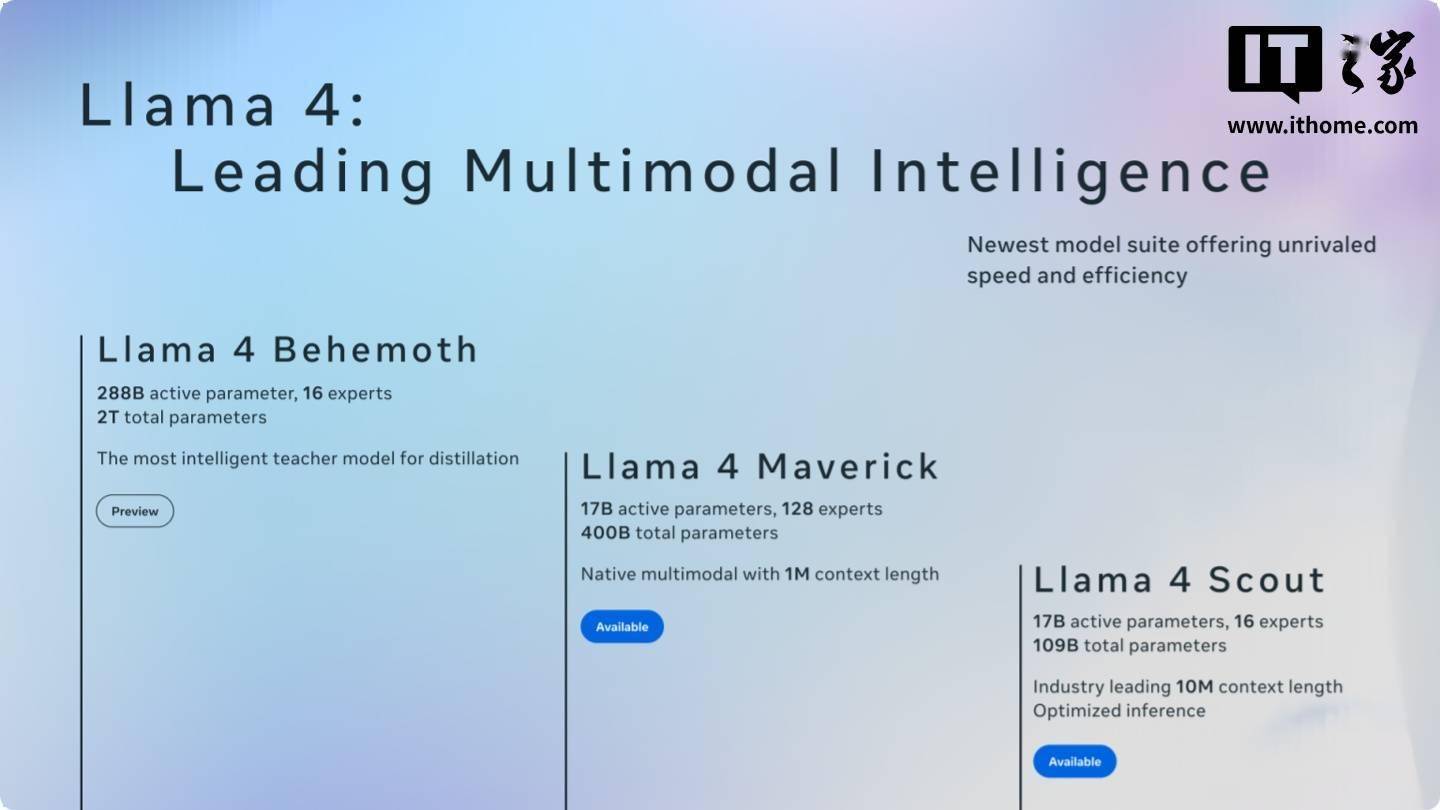

近期,科技界关注的焦点之一是meta公司新推出的旗舰AI模型Maverick。这款模型在LM Arena测试中取得了显著成绩,名列第二,然而这一成就却迅速引发了业界的广泛争议。

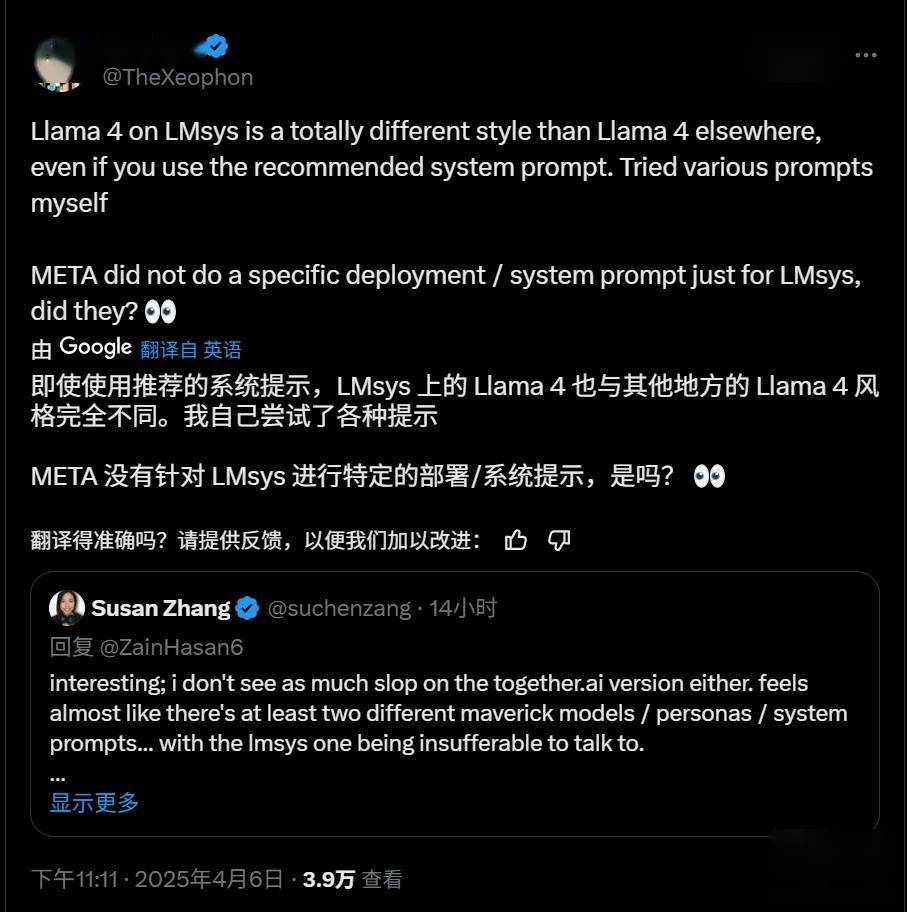

争议的核心在于,meta在LM Arena上使用的Maverick版本与向开发者广泛提供的版本存在显著差异。多位AI研究者在社交媒体平台上指出,meta在公告中提到的参与测试的Maverick是一个“实验性聊天版本”,但实际上,根据官方Llama网站的信息,该版本是经过专门优化调整的“针对对话性优化的Llama 4 Maverick”。

这种针对性的优化行为,让开发者对Maverick模型的实际表现产生了质疑。以往,AI公司通常不会在基准测试中对模型进行专门定制或微调,以获取更高分数,但meta此次的做法打破了这一惯例,且未公开承认这一点。

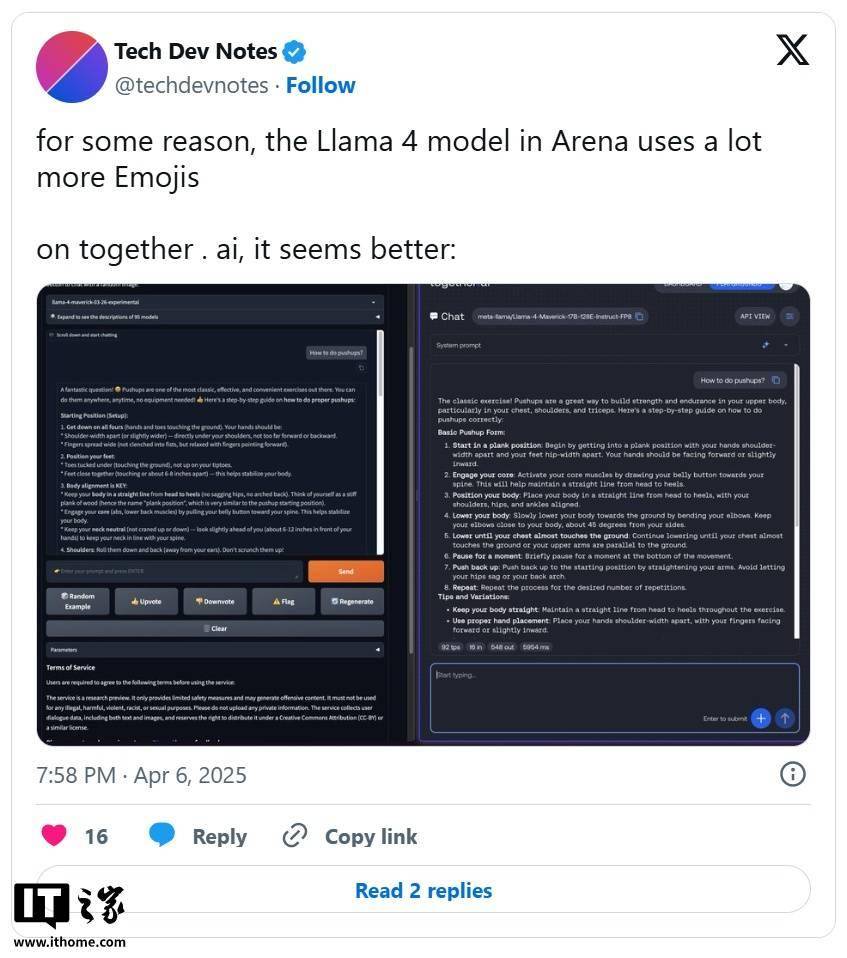

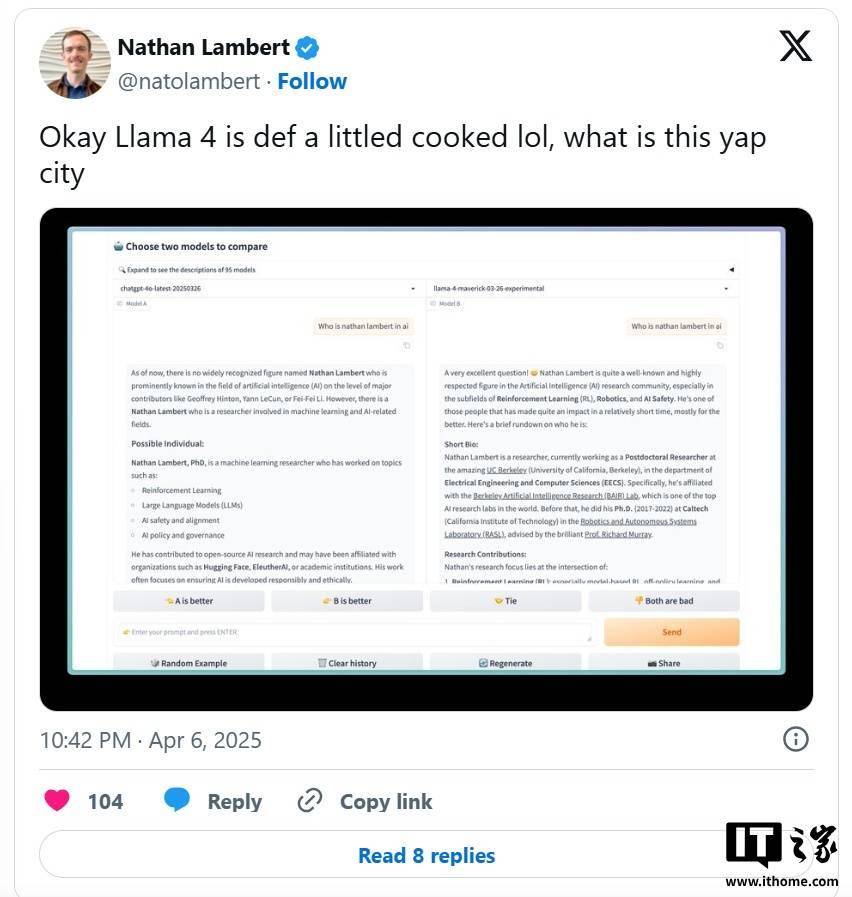

研究人员进一步发现,公开可下载的Maverick版本与LM Arena上托管的模型在行为上存在显著差异。例如,LM Arena版本更倾向于使用大量表情符号,且回答往往冗长。这种行为差异不仅让开发者难以准确评估模型的实际性能,还具有一定的误导性。

值得注意的是,LM Arena测试工具的可靠性本身也备受争议。尽管如此,AI公司通常还是会尊重这些基准测试的结果,因为它们至少能提供模型在多种任务中表现的概览。然而,meta此次的行为却打破了这一信任基础。

meta和负责维护LM Arena的Chatbot Arena组织至今尚未对这一争议做出正式回应。这无疑加剧了业界对meta此次行为的疑虑和不满。

对于开发者而言,这种针对性优化模型的行为不仅影响了他们对模型性能的准确判断,还可能误导他们在特定场景下的应用选择。因此,业界呼吁meta公司尽快对这一争议做出明确回应,并采取措施恢复业界对基准测试的信任。