在近日举行的华为云生态大会上,硅基流动公司的创始人袁进辉带来了一项重大宣布:硅基流动携手华为云,基于CloudMatrix 384超节点昇腾云服务以及高性能推理框架SiliconLLM,正式推出了DeepSeek-R1的最新版本。这一版本采用了大规模专家并行的最佳实践,为用户带来了前所未有的性能体验。

据悉,DeepSeek-R1在确保每位用户能够达到20 TPS(每秒事务数)的基础上,单卡Decode的吞吐量更是突破了1920 Tokens/s,这一表现与H100的部署性能不相上下。更重要的是,经过广泛的主流测试集验证及大规模线上盲测,使用昇腾算力部署的DeepSeek-R1模型精度,与DeepSeek官方提供的版本完全一致。

CloudMatrix超节点集群,凭借其基于新型高速总线架构的设计,在总算力、互联带宽以及内存带宽方面均处于业界领先地位。这一创新架构,为DeepSeek-R1的高效运行提供了坚实的基础。

硅基流动此前已在SiliconCloud大模型云服务平台上,推出了基于昇腾云的稳定生产级DeepSeek-V3与R1推理服务,并支持模型的私有化集群部署。此次与华为云的深度合作,进一步推动了基于国产算力的DeepSeek-R1推理服务的持续优化与升级。

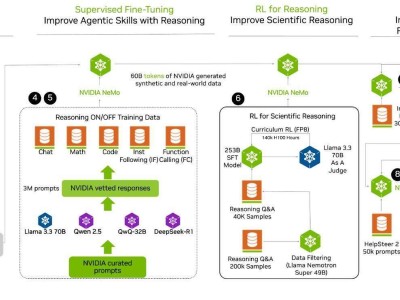

DeepSeek在全球范围内掀起了一场风暴,其高效、低成本的MoE(Mixture of Experts,专家混合)架构为解决大模型推理的挑战提供了新的思路。然而,要想成功部署DeepSeek,并非易事,尤其是缺乏强大的AI Infra技术能力的情况下。DeepSeek采用了大规模专家并行(Expert Parallelism,大EP并行)的MoE模型架构,如果采用单机部署方案,其性能将远逊于DeepSeek官方公布的部署方案,且成本差距可能高达数倍。

面对这些挑战,硅基流动与华为云共同攻克了技术难关。在CloudMatrix 384超节点昇腾云服务上部署DeepSeek-R1时,他们采用了大规模专家并行方案,通过多专家负载均衡和极致的通信优化,实现了高吞吐和更高性能,从而显著提升了用户体验。同时,他们还利用了昇腾高性能算子库以及硅基流动推理加速框架SiliconLLM在模型、机制、算子上的协同优化,使得在国产算力上,DeepSeek-R1的推理效率与资源利用率得到了显著提升,且未损失模型精度。

硅基流动与华为云的这次合作,不仅为用户提供了坚实的全国产软硬件体系部署方案,使DeepSeek推理服务更加经济高效,同时也展示了AI生态合作的强大力量。这一合作成果,将推动AI技术在更多场景中的落地和应用,为用户带来更加优质的AI服务体验。