OpenAI近期推出了一个名为Codex CLI的终端运行编码智能体,这一创新工具已经在GitHub平台上实现了全面的开源。这一举措标志着OpenAI在推动人工智能与开发者社区融合方面迈出了重要一步。

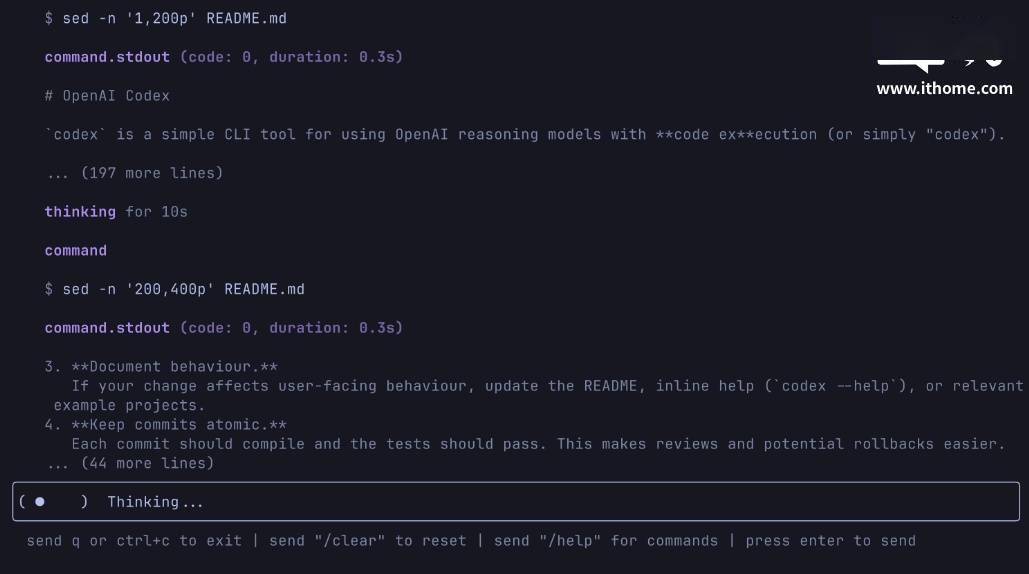

Codex CLI的核心优势在于其能够在用户的本地计算机上直接运行,无需依赖云端服务。该工具充分利用了o3和o4-mini等模型的推理能力,并预告未来将支持GPT-4.1等更高级的API模型。这一特性对于追求高效、即时反馈的开发者而言,无疑是一个巨大的福音。

更令人兴奋的是,Codex CLI提供了多模态推理的能力。用户只需通过命令行,就可以将截图或低保真草图传递给模型,并结合对本地代码的访问,实现更加灵活、智能的开发体验。这一功能不仅提升了开发效率,还为创意实现提供了更多可能性。

OpenAI将Codex CLI定位为连接其模型与用户及其计算机的最小化界面。这一工具特别为那些习惯于在终端环境中工作的开发者设计,他们不仅能够获得ChatGPT级别的推理能力,还能实际运行代码、操作文件,并在版本控制下进行迭代。简而言之,Codex CLI成为了一个理解并执行仓库的聊天驱动开发工具,为开发者带来了前所未有的便捷和高效。

Codex CLI的使用门槛极低。用户只需导入OpenAI API密钥,即可直接开始使用,无需进行繁琐的配置。同时,该工具还提供了全自动批准机制,并通过运行网络禁用和目录沙箱化等措施,确保用户的安全。这些贴心的设计,无疑让Codex CLI更加易于上手和值得信赖。

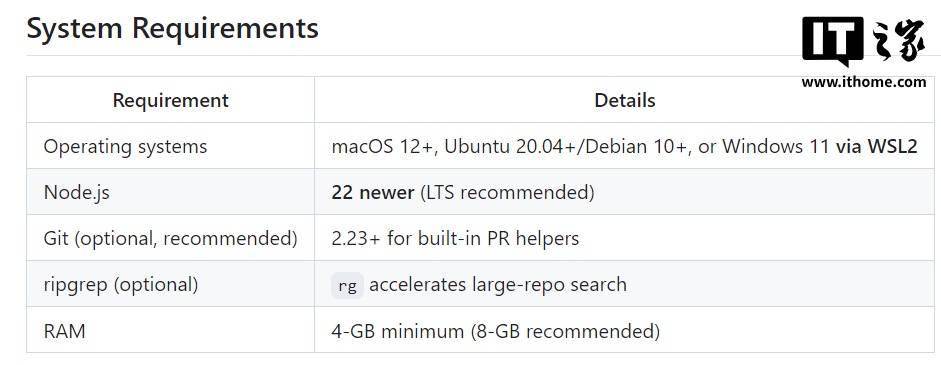

Codex CLI的兼容性也非常出色,支持在macOS 12+、Ubuntu 20.04+/Debian 10+、以及Windows 11的WSL2子系统中运行。同时,该工具对硬件的要求也不高,最少只需4GB内存(建议8GB),即可流畅运行。这一特性使得更多的开发者能够轻松上手,享受Codex CLI带来的便利。

对于对Codex CLI感兴趣的开发者而言,可以通过以下链接获取其开源代码: