杭州,这座科技与创新并蓄的城市,近期迎来了火山引擎Force Link AI创新巡展的首站。这一选择似乎并非偶然,因为在这里,不仅有新兴的大模型独角兽DeepSeek熠熠生辉,更有老牌云计算巨头阿里云稳坐钓鱼台。火山引擎此番亮相,不仅是为了展示其技术实力,更是为了传递一个更为深远的信息。

火山引擎总裁谭待在一席发言中掷地有声:“如果说2024年是中国AI应用的启航之年,那么2025年,极有可能见证AI Agent应用的全面爆发。”这一观点不仅代表了火山引擎的深刻洞察,更成为了整个行业的广泛共识。上一次大模型行业如此众志成城,或许还要追溯到那场轰轰烈烈的“百模大战”。

技术和商业层面的共识,如同一把双刃剑。其积极面在于,产业方向得以明确,资源得以集中,有力推动了新技术的繁荣和新商业模式的崛起。然而,其负面效应也不容忽视,竞争迅速从蓝海转向红海,留给参与者的时间窗口愈发狭窄。

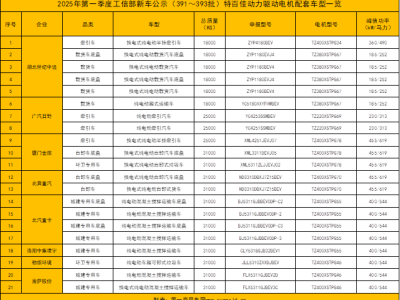

火山引擎,这个习惯于在产业共识中茁壮成长的玩家,近期在IDC发布的《中国公有云大模型服务市场格局分析,1Q25》报告中大放异彩。报告显示,2024年中国公有云大模型调用量中,火山引擎以46.4%的市场份额稳居榜首。这一数据,不仅反映了火山引擎在B端客户的极高受欢迎程度,更是其在上一次产业共识中取得辉煌成就的有力证明。

在Agent元年共识的大背景下,火山引擎于4月17日面向企业市场推出了豆包1.5·深度思考模型,并同步升级了文生图模型3.0、视觉理解模型,同时推出了OS Agent解决方案及AI云原生推理套件,旨在助力企业更快、更经济地构建和部署Agent应用。

有趣的是,同一天,OpenAI也发布了其系列中能力最强的推理模型——o3模型和o4-mini模型。其中,o3模型作为第一代能够在思维链中使用图像进行推理的模型,还能自主调用工具,并预告未来将推出一系列编程工具。这一举动,无疑进一步印证了大模型正朝着更适合Agent化的方向演进。

在这场新的共识竞争中,火山引擎展现出了其深厚的底蕴和前瞻的视野。谭待强调,要做好Agent,技术上需做好三个准备:首先是打造更强的模型,具备思考、计划和反思的能力,并支持多模态;其次是构建更好的架构和工具,支持大模型操作数字和物理世界,构建好OS agent;最后是通过AI云原生,不断降低模型推理的成本和延迟,推动应用普及。

豆包深度思考模型,正是火山引擎为此次Agent元年量身打造的利器。此前大模型行业的价格战并未能推动大模型的广泛落地,本质上还是因为模型能力有限。而深度思考模型则通过强化逻辑推理和思维链能力,更好地满足了复杂场景的需求,证明了模型性能仍有巨大的潜力可挖。

本次豆包1.5·深度思考模型突出体现在效果好、低延迟和多模态上,包括大语言模型Doubao-1.5-thinking-pro和多模态版本Doubao-1.5-thinking-pro|m两个版本。前者推理能力更强,后者则支持视觉推理,开发者可以根据实际需求灵活选择。

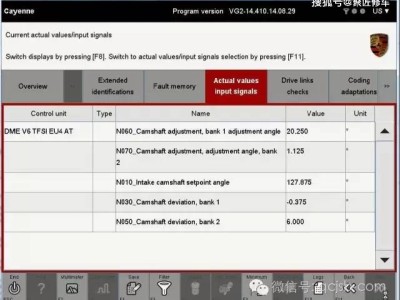

豆包1.5·深度思考大语言模型采用了MoE架构,总参数为200B,但激活参数仅20B,能够以较小的参数实现媲美顶尖模型的效果。同时,基于高效算法,该模型在提供极高并发承载能力的同时,实现了20毫秒的极低延迟,即便在延迟敏感的场景中也能游刃有余。

根据现场公布的数据,豆包1.5·深度思考模型在专业领域的推理任务中表现卓越,数学推理AIME 2024测试得分与OpenAI的o3-mini-high持平,编程竞赛和科学推理测试成绩也接近o1。在创意写作、人文知识问答等通用任务上,该模型同样展现出了出色的泛化能力。

豆包·文生图模型也升级为3.0版本,并正式向企业开放。该版本已在即梦AI、豆包产品上线,支持2K分辨率直出,在生图结构准确性、小字生成与排版、美感、真实度等方面均表现出色,并在近期的权威竞技场Artificial Analysis文生图榜单中跻身第一梯队。

在DeepSeek之后,模型厂商呈现出“两极分化”的趋势。有的转向垂类场景或应用领域,而云厂商则以更快的速度迭代。这是因为DeepSeek的成功不仅是模型算法的更新,更是AI infra的全链路优化。而目前国内外云巨头已成为基础模型的主要参与者,AI独角兽也大多获得了云厂的直接投资。

谭待指出,传统的云是伴随着互联网发展起来的,当时的云原生很多涉及的是互联网应用(如web、APP)在实践中涉及的中间件、数据库、容器等方面。而现在范式发生了变化,以前是人通过编写软件规则、中间件等来实现对业务的抽象,现在则是利用数据加上模型自动解决更多问题。这种变化催生了新的产品——AI云原生。

AI云原生以满足AI和Agent发展的需求为核心,通过云原生技术栈与AI能力的深度融合,使模型的开发、部署、迭代等能力和效果成为基础设施比拼的关键。为此,火山引擎一直在以AI云原生为理念推陈出新,如本次大会新发布的AI云原生推理套件ServingKit,就整合了AI容器编排、AI网关、推理全链路观测和AI加速套件的能力,支持在大规模GPU集群上运行推理工作负载。

火山引擎可能比所有云厂商更早看清AI云原生的趋势。字节跳动的主营业务,如搜索、广告、推荐等,都是基于人工智能技术实现的。这使得火山引擎对技术预判具有天然优势。在大模型之前,外界对字节跳动卷入云计算行业的动机尚存疑惑,但火山引擎最终“等”到了大模型,新技术的发展往往充满巧合。

火山引擎此前就表示,下一个十年,计算范式应该进入AI云原生的新时代。如今,这一观点已成为广泛共识。当通算时代的云生态被拆解,智算时代的云生态又该如何构建?火山引擎给出的答案是,围绕AI云原生,在存储、计算、数据、安全以及新的中间件等方面推出一系列产品。

在本次大会上,火山引擎还推出了OS Agent解决方案,并演示了由Agent操作浏览器搜索商品页实现iPhone比价的任务,甚至由Agent在远程计算机上用剪映进行视频编辑、配乐。这一解决方案包含豆包1.5·UI-TARS模型以及veFaaS函数服务、云服务器、云手机等产品,可实现对代码、浏览器、电脑、手机以及其他Agent的操作。

面对大规模推理需求,火山引擎打造的AI云原生·ServingKit推理套件,让模型部署更快、推理成本更低,GPU消耗相比传统方案大幅下降。在实际业务场景中,该套件通过算子优化,使DeepSeek R1满血版TPS提升超2.4倍;智能路由提供负载感知路由和KVCache感知路由,使TTFT降低60%;EIC在多轮次对话中,TTFT从3秒降低到1秒,长文本推理KVCache命中率提升了10倍以上。

火山引擎的豆包大模型自发布以来,调用量实现了爆发式增长。从去年12月的日均4万亿tokens调用量,到今年3月底已超过12.7万亿,不到一年的时间里实现了超过106倍的高速增长。金山办公、梅赛德斯-奔驰、浙江大学、杭州银行等不同行业的众多客户,都在火山引擎上使用豆包大模型,打造自己的AI业务生态。